Command Palette

Search for a command to run...

Venkatesh Mishra Amir Saeidi Satyam Raj Mutsumi Nakamura Jayanth Srinivasa Gaowen Liu Ali Payani Chitta Baral

초록

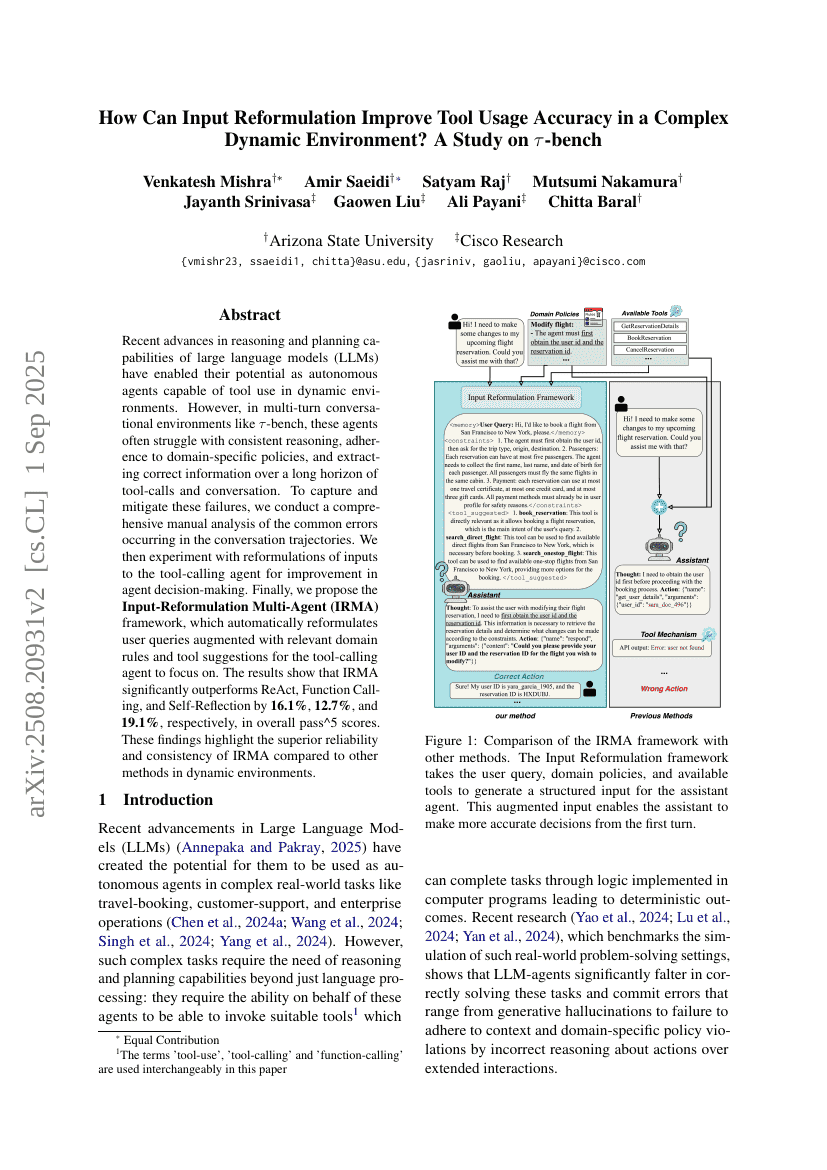

최근 대규모 언어 모델(LLM)의 추론 및 계획 능력이 향상되면서, 동적 환경에서 도구 사용이 가능한 자율 에이전트로서의 잠재력을 발휘할 수 있게 되었다. 그러나 $τ$-bench와 같은 다단계 대화 환경에서는 이러한 에이전트가 장기적인 도구 호출 및 대화 흐름 속에서 일관된 추론 수행, 도메인 특화 정책 준수, 정확한 정보 추출에 어려움을 겪는 경우가 많다. 이러한 실패를 포착하고 완화하기 위해, 우리는 대화 경로에서 발생하는 일반적인 오류에 대해 포괄적인 수동 분석을 수행하였다. 그 후, 도구 호출 에이전트의 결정 품질 향상을 위해 입력의 재구성 방식을 실험하였다. 마지막으로, 사용자 쿼리를 관련 도메인 규칙과 도구 제안 정보로 보강하여 도구 호출 에이전트가 집중할 수 있도록 자동으로 재구성하는 Input-Reformulation Multi-Agent(IRMA) 프레임워크를 제안한다. 실험 결과, IRMA는 전반적인 pass^5 점수에서 ReAct, Function Calling, Self-Reflection보다 각각 16.1%, 12.7%, 19.1% 우수한 성능을 보였다. 이러한 결과는 동적 환경에서 다른 방법에 비해 IRMA가 훨씬 뛰어난 신뢰성과 일관성을 갖는다는 점을 강조한다.