Command Palette

Search for a command to run...

Yibin Wang Zhimin Li Yuhang Zang Yujie Zhou Jiazi Bu Chunyu Wang Qinglin Lu Cheng Jin Jiaqi Wang

초록

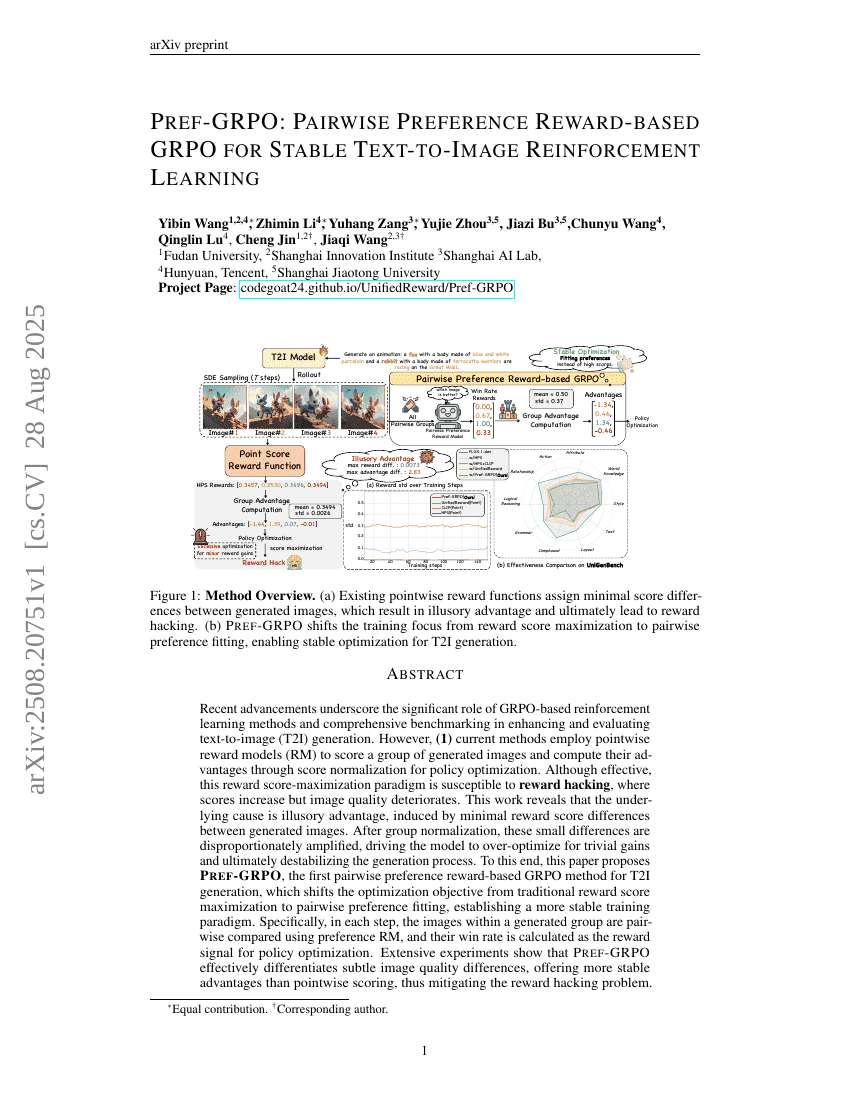

최근의 기술 발전은 텍스트-이미지(T2I) 생성 향상에 있어 GRPO 기반 강화학습 방법과 벤치마킹의 중요성을 부각시키고 있다. 그러나 현재의 점별 보상 모델(RM)을 활용하여 생성된 이미지를 평가하는 방법은 보상 조작(reward hacking)에 취약하다는 문제가 있다. 본 연구에서는 이미지 간 미미한 점수 차이가 정규화 과정에서 확대되면서 허상의 우위가 발생하고, 이로 인해 모델이 사소한 이득에 과도하게 최적화되며 결국 이미지 생성 과정이 불안정해진다는 현상을 밝혀냈다. 이를 해결하기 위해, 점수 최대화가 아닌 선호도 적합(preferring fitting)을 최적화 목표로 삼는 쌍별 선호도 보상 기반의 GRPO 방법인 Pref-GRPO를 제안한다. 이 방법에서는 각 그룹 내 이미지들을 쌍별로 비교하여 선호도 RM을 활용하고, 승률(win rate)을 보상 신호로 사용한다. 광범위한 실험을 통해 Pref-GRPO가 미세한 이미지 품질 차이를 효과적으로 구분함으로써 더 안정적인 우위를 제공하고, 보상 조작 문제를 완화함을 입증하였다. 또한, 기존의 T2I 벤치마크는 평가 기준이 과도하게 대략적이어서 모델 종합 평가를 방해하는 한계가 있었다. 이를 해결하기 위해, 5개의 주요 주제와 20개의 하위 주제를 포함하는 총 600개의 프롬프트로 구성된 통합형 T2I 벤치마크인 UniGenBench를 제안한다. 이 벤치마크는 주요 10개 및 보조 27개의 평가 기준을 통해 의미 일관성(semantic consistency)을 평가하며, 다중 모달러 랭귀지 모델(MLLM)을 활용하여 벤치마크의 구축과 평가를 수행한다. 제안된 벤치마크를 통해 오픈소스 및 클로즈소스 T2I 모델의 강점과 약점을 정밀하게 파악하고, Pref-GRPO의 효과성을 검증하였다.