Command Palette

Search for a command to run...

초록

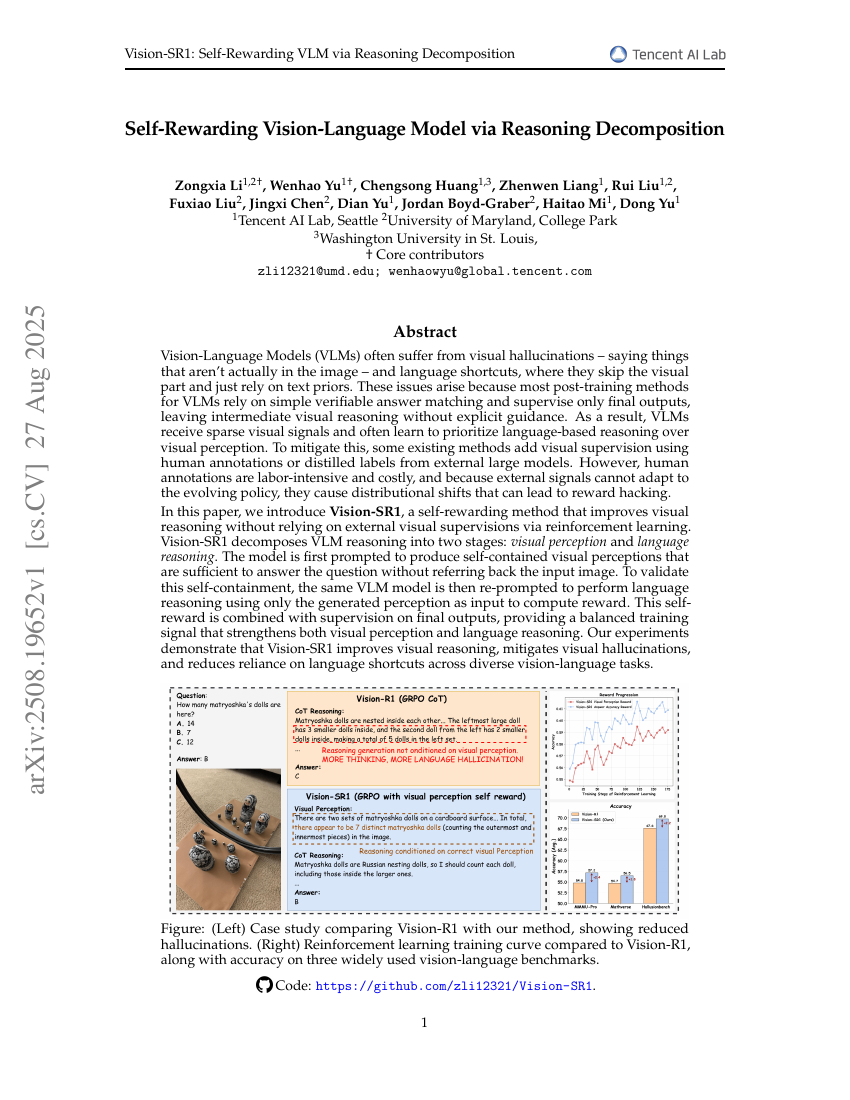

시각-언어 모델(Vision-Language Models, VLMs)은 종종 시각적 환각(visual hallucinations)과 언어적 단순화(linguistic shortcuts) 문제를 겪는다. 시각적 환각은 이미지에 실제로 존재하지 않는 내용을 언급하는 현상이며, 언어적 단순화는 시각 정보를 생략하고 단지 텍스트 사전 지식(text priors)에 의존하는 현상이다. 이러한 문제들은 대부분의 VLM 후기 훈련 방법이 단순한 검증 가능한 답변 매칭에 의존하고 최종 출력만을 감독하기 때문에 발생한다. 이로 인해 중간 단계의 시각적 추론에는 명시적인 지침이 부족해지며, 결과적으로 VLMs는 시각적 인식보다 언어 기반 추론을 우선시하게 된다. 이를 완화하기 위해 기존의 일부 방법들은 인간의 주석(annotation) 또는 외부 대규모 모델로부터 추출한 정제된 레이블(distilled labels)을 활용해 시각적 감독을 추가한다. 그러나 인간 주석은 노동력과 비용이 크며, 외부 신호는 모델의 진화하는 정책(policy)에 적응하지 못하기 때문에 분포 이동(distributional shift)을 초래할 수 있으며, 이는 보상 조작(reward hacking)을 유발할 수 있다. 본 논문에서는 강화학습을 통해 외부 시각적 감독 없이도 시각적 추론을 향상시키는 자기 보상(self-rewarding) 기법인 Vision-SR1을 제안한다. Vision-SR1은 VLM의 추론 과정을 두 단계로 분해한다: 시각적 인지(visual perception)와 언어적 추론(language reasoning). 먼저 모델은 입력 이미지에 다시 의존하지 않고도 질문에 답할 수 있을 정도로 자가 포함(self-contained)된 시각적 인지를 생성하도록 유도한다. 이 자가 포함성(self-containment)을 검증하기 위해, 동일한 VLM 모델을 다시 프롬프트하여 생성된 인지 정보만을 입력으로 받아 언어적 추론을 수행하고 보상을 계산한다. 이 자기 보상(self-reward)은 최종 출력에 대한 감독과 결합되어 시각적 인지와 언어적 추론을 동시에 강화하는 균형 잡힌 훈련 신호를 제공한다. 실험 결과, Vision-SR1은 다양한 시각-언어 작업에서 시각적 추론 능력을 향상시키고, 시각적 환각을 완화하며 언어적 단순화에 대한 의존도를 줄이는 데 성공했다.