Command Palette

Search for a command to run...

Fan Nie Ken Ziyu Liu Zihao Wang Rui Sun Wei Liu Weijia Shi et al

초록

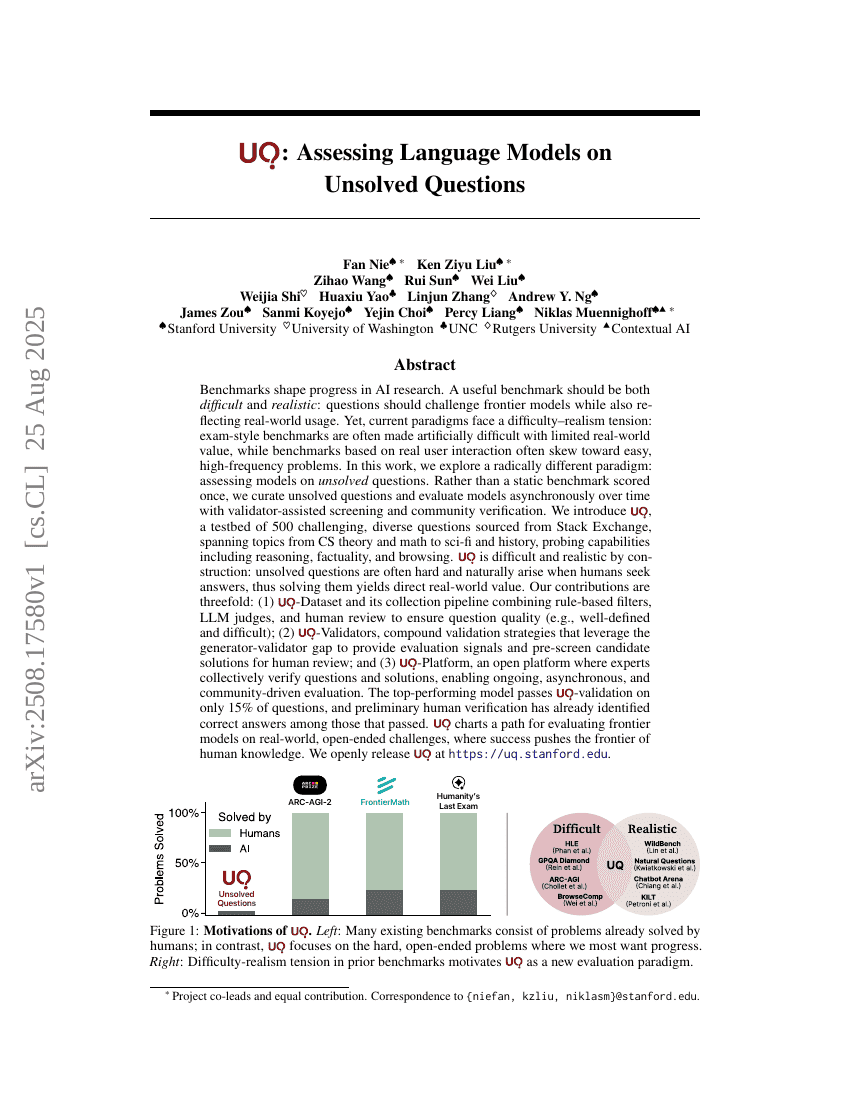

AI 연구의 발전을 이끄는 핵심 요소는 벤치마크이다. 효과적인 벤치마크는 난이도와 현실성의 균형을 가져야 한다. 즉, 최전방 모델을 도전하게 하면서도 실제 사용 상황을 반영해야 한다. 그러나 현재의 벤치마크 패러다임은 ‘난이도-현실성’ 간의 긴장 관계에 직면해 있다. 시험형 벤치마크는 현실적 가치가 제한적인 방식으로 인위적으로 난이도를 높이는 경향이 있고, 반면 실제 사용자 상호작용을 기반으로 한 벤치마크는 일반적으로 쉬우면서도 빈번히 발생하는 문제들에 치우쳐 있다. 본 연구에서는 근본적으로 다른 패러다임을 탐색한다. 즉, 아직 해결되지 않은 질문들에 대해 모델을 평가하는 방식이다. 단순히 한 번 평가되는 정적 벤치마크가 아니라, 해결되지 않은 질문들을 체계적으로 수집하고, 검증자(validator)의 지원과 커뮤니티 기반 검증을 통해 시간이 지남에 따라 비동기식으로 모델을 평가한다. 우리는 UQ(unsolved questions)라는 테스트베드를 제안한다. 이는 스택 엔지니어(Stack Exchange)에서 수집한 500개의 도전적이고 다양한 질문들로 구성되며, 컴퓨터 과학 이론, 수학, 과학소설, 역사 등 다양한 주제를 아우르며, 추론 능력, 사실성, 웹 브라우징 능력 등을 평가할 수 있다. UQ는 구성 자체에서 난이도와 현실성을 모두 갖춘다. 해결되지 않은 질문은 일반적으로 어려우며, 인간이 답을 찾으려는 시도에서 자연스럽게 발생하므로, 이를 해결하는 것은 직접적인 실용적 가치를 창출한다. 본 연구의 기여는 세 가지로 요약된다. (1) 규칙 기반 필터, LLM 기반 평가자, 그리고 인간 검토를 결합한 수집 파이프라인을 통해 질문의 품질(예: 명확하게 정의되고 어려운 질문)을 보장하는 UQ-데이터셋; (2) 생성자-검증자 간의 격차를 활용하여 평가 신호를 제공하고, 인간 검토를 위한 후보 솔루션을 사전 선별하는 복합 검증 전략인 UQ-Validator; (3) 전문가들이 함께 참여하여 질문과 솔루션을 검증할 수 있는 개방형 플랫폼인 UQ-Platform. 최상위 모델은 UQ 검증에서 단지 15%의 질문에 대해 통과할 뿐이며, 초기 인간 검증 과정을 통해 통과한 답변들 중에서 정답이 이미 확인된 바 있다. UQ는 인간 지식의 전면을 확장하는 데 성공하는 모델을 평가할 수 있는 길을 제시하며, 실제 세계의 열린 문제에 대해 선도적인 모델을 평가하는 새로운 가능성을 열어준다.