Command Palette

Search for a command to run...

Tanvir Bhathal Asanshay Gupta

초록

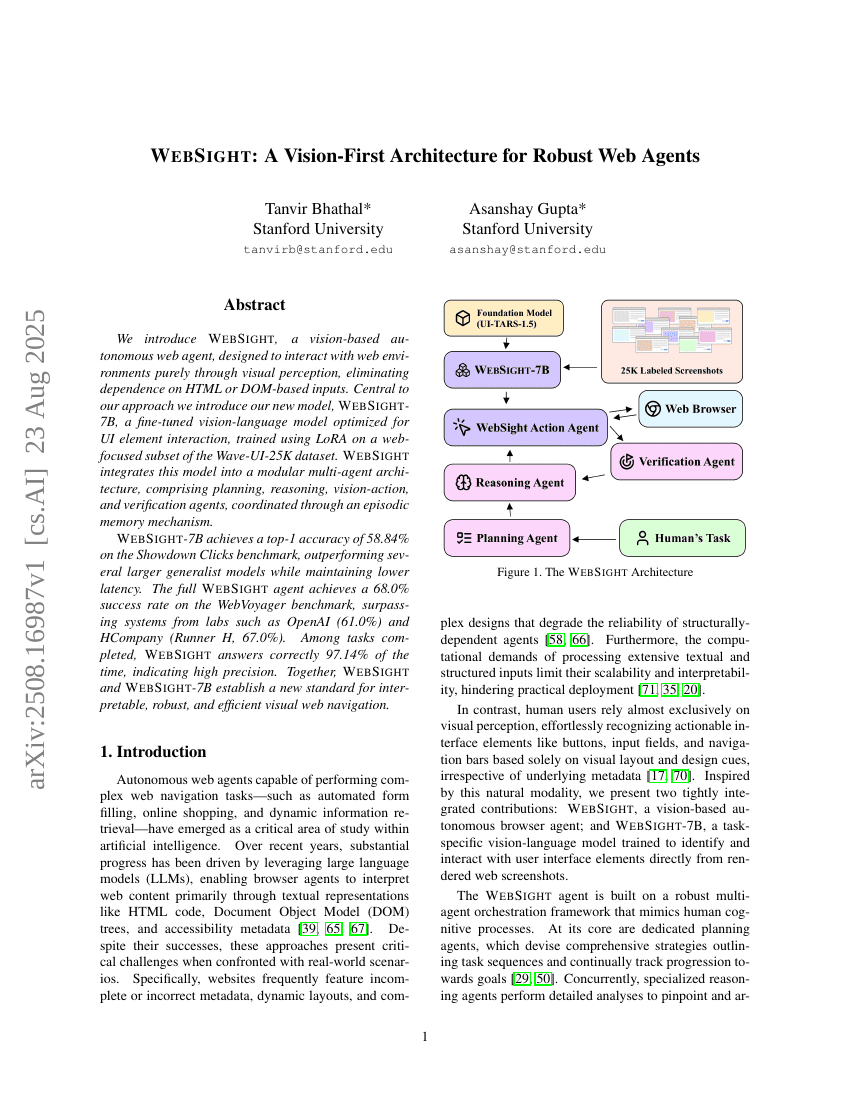

우리는 시각 인식을 통해 웹 환경과 상호작용하는 데만 의존하는, HTML이나 DOM 기반 입력에 대한 의존을 제거한 시각 기반 자율 웹 에이전트인 WebSight를 소개한다. 본 연구의 핵심은 웹 인터페이스 요소 상호작용에 최적화된 시각-언어 모델인 WebSight-7B를 개발한 점이다. 이 모델은 Wave-UI-25K 데이터셋의 웹 중심 서브셋을 기반으로 LoRA(LoRA: Low-Rank Adaptation)를 사용해 미세조정(fine-tuning)하여 학습하였다. WebSight는 이 모델을 계획, 추론, 시각-행동, 검증 에이전트로 구성된 모듈형 다중 에이전트 아키텍처에 통합하였으며, 에피소딕 메모리(episodic memory) 기반의 기제를 통해 각 에이전트를 조율한다. WebSight-7B는 Showdown Clicks 벤치마크에서 58.84%의 top-1 정확도를 기록하며, 더 큰 일반화 모델들보다 뛰어난 성능을 보였으며, 지연 시간(latency)은 낮은 수준을 유지했다. 전체 WebSight 에이전트는 WebVoyager 벤치마크에서 68.0%의 성공률을 달성하여 OpenAI(61.0%) 및 HCompany(Runner H, 67.0%)의 시스템을 모두 상회하였다. 수행된 작업 중 WebSight는 97.14%의 정확도로 정답을 제시하며 높은 정밀도를 입증하였다. 이러한 결과를 통해 WebSight와 WebSight-7B는 해석 가능하고, 견고하며, 효율적인 시각 기반 웹 탐색의 새로운 기준을 설정하였다.