Command Palette

Search for a command to run...

Haoze Wu Yunzhi Yao Wenhao Yu Huajun Chen Ningyu Zhang

초록

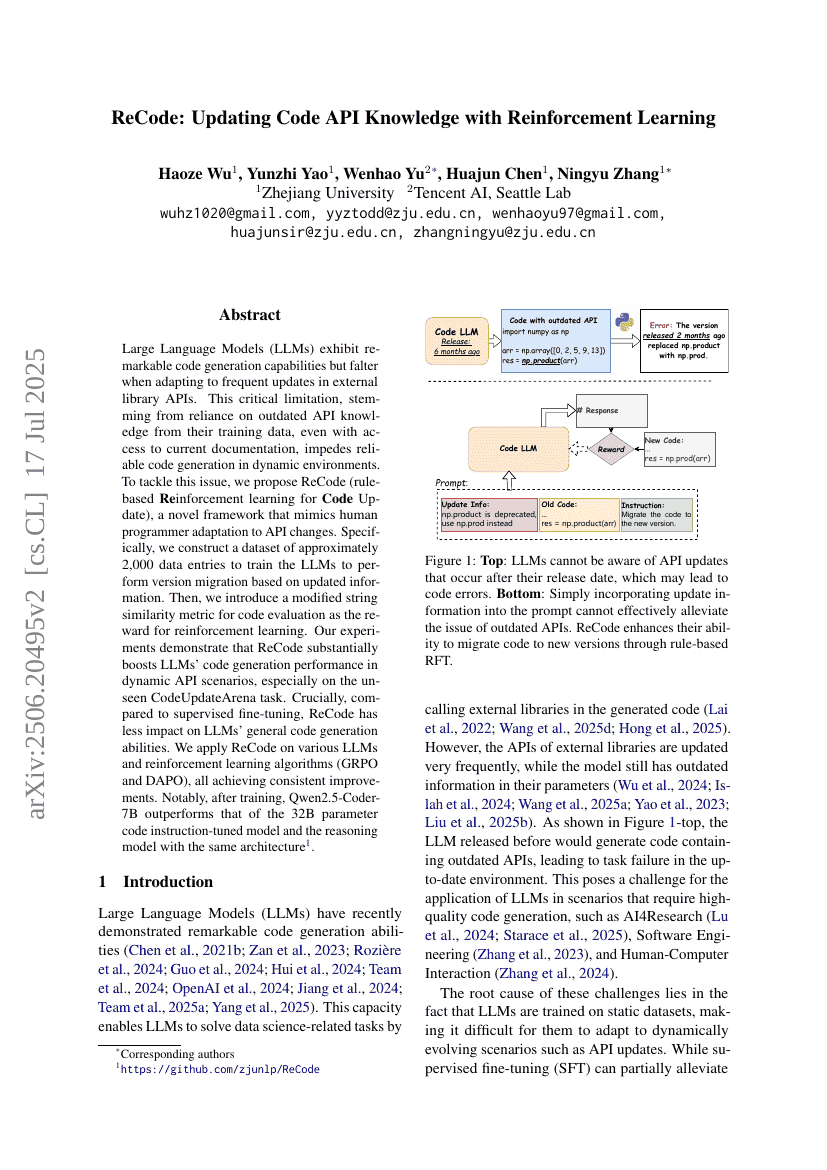

대형 언어 모델(LLMs)은 뛰어난 코드 생성 능력을 보여주지만, 외부 라이브러리 API의 자주 발생하는 업데이트에 적응할 때는 실패합니다. 이 중요한 제한은 훈련 데이터에서 구식 API 지식에 의존하기 때문에 발생하며, 현재 문서에 접근할 수 있더라도 동적인 환경에서 신뢰성 있는 코드 생성을 방해합니다. 이러한 문제를 해결하기 위해, 우리는 ReCode(규칙 기반 강화 학습으로 코드 업데이트)라는 새로운 프레임워크를 제안합니다. ReCode는 인간 프로그래머가 API 변경에 적응하는 방식을 모방합니다. 구체적으로, 약 2,000개의 데이터 항목으로 구성된 데이터셋을 만들어 LLMs가 업데이트된 정보를 바탕으로 버전 마이그레이션을 수행하도록 훈련시킵니다. 그런 다음, 코드 평가를 위한 수정된 문자 유사도 메트릭을 도입하여 강화 학습의 보상으로 사용합니다. 우리의 실험 결과는 ReCode가 동적인 API 시나리오에서 LLMs의 코드 생성 성능을 크게 향상시키며, 특히 미처 보지 못한 CodeUpdateArena 작업에서 더욱 두드러진다는 것을 보여줍니다. 중요한 점은 감독 학습 미세 조정과 비교했을 때 ReCode가 LLMs의 일반적인 코드 생성 능력에 미치는 영향이 작다는 것입니다. 우리는 다양한 LLMs와 강화 학습 알고리즘(GRPO 및 DAPO)에 ReCode를 적용하였으며, 일관된 개선 효과를 얻었습니다. 특히 훈련 후 Qwen2.5-Coder-7B는 32B 매개변수로 코드 지시 튜닝된 모델과 같은 아키텍처를 가진 추론 모델보다 우수한 성능을 보였습니다. 코드는 https://github.com/zjunlp/ReCode에서 확인할 수 있습니다.