Command Palette

Search for a command to run...

초록

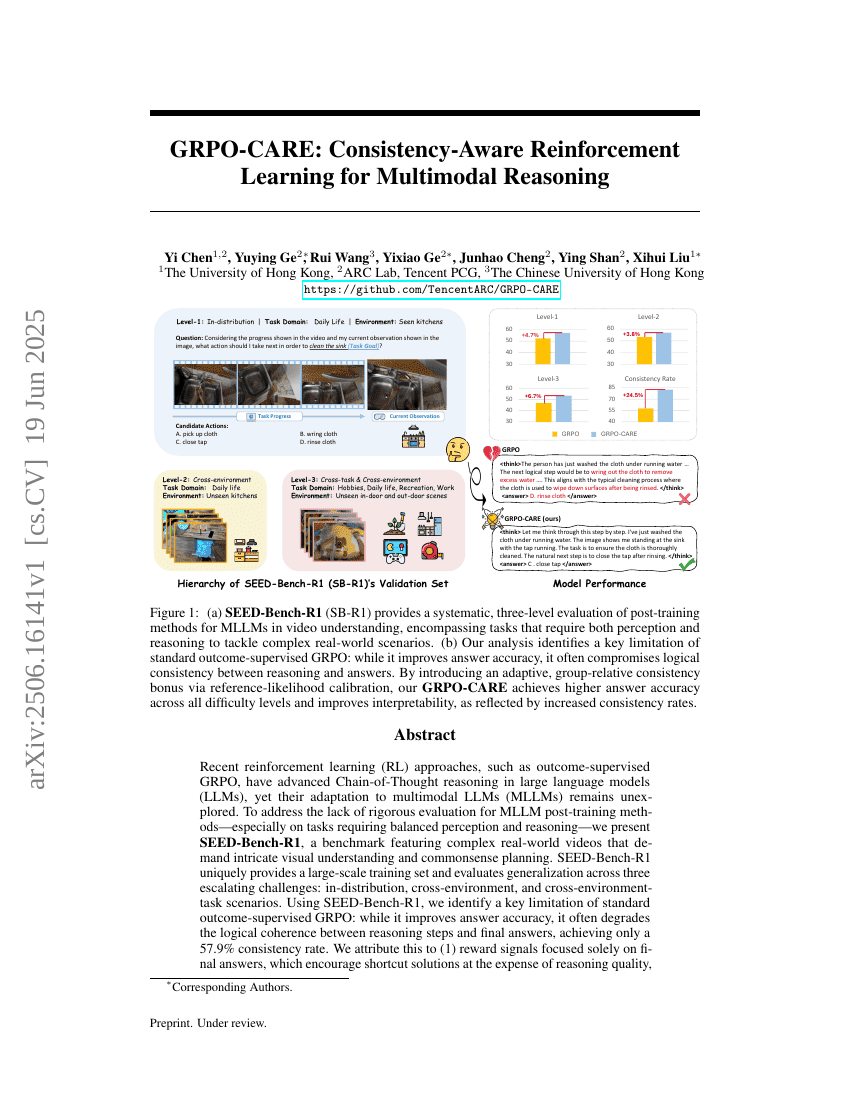

최근의 강화 학습 접근 방식, 예를 들어 결과 지도형 GRPO는 대형 언어 모델(Large Language Models, LLMs)에서 사슬적 사고(Chain-of-Thought) 추론을 발전시켰지만, 다중 모달 LLMs(Multimodal LLMs, MLLMs)에 대한 그들의 적응은 아직 연구되지 않았습니다. MLLM 후 훈련 방법의 엄격한 평가 부족을 해결하기 위해, 우리는 복잡한 실제 세계 비디오를 포함하고 감지와 추론의 균형을 요구하는 벤치마크인 SEED-Bench-R1을 소개합니다. 이 벤치마크는 큰 훈련 세트를 제공하며, 세 가지 점진적인 도전 과제(in-distribution, cross-environment, cross-environment-task 시나리오)에 걸쳐 일반화를 평가합니다.SEED-Bench-R1을 사용하여 분석한 결과, 표준 GRPO는 답변 정확성을 개선하지만 종종 추론 단계와 답변 사이의 논리 일관성이 줄어들어 일관성율이 57.9%에 불과함을 발견했습니다. 이는 보상 신호가 최종 답변에만 집중되어 단축 경로를 장려하고, 엄격한 KL 패널티가 탐색을 제한하기 때문입니다. 이를 해결하기 위해, 우리는 답변 정확성과 추론 일관성을 모두 최적화하면서 명시적인 감독 없이 작동하는 일관성 인식 강화 학습(RL) 프레임워크인 GRPO-CARE를 제안합니다.GRPO-CARE는 두 단계 보상을 도입합니다: (1) 답변 정확성에 대한 기본 보상(base reward), (2) 모델의 추론-답변 확률(서서히 진화하는 참조 모델을 통해 계산)과 그룹 동료 간의 비교를 통해 산출되는 적응형 일관성 보너스(adaptive consistency bonus). 이 이중 메커니즘은 올바르면서 논리적으로 일관된 추론 경로에 대해 보상을 증폭시킵니다. KL 패널티를 이 적응형 보너스로 대체함으로써, GRPO-CARE는 SEED-Bench-R1에서 표준 GRPO보다 우수한 성능을 보여주며 가장 어려운 평가 수준에서 6.7%의 성능 향상과 24.5%의 일관성 개선을 달성했습니다. 또한 다양한 비디오 이해 벤치마크에서도 모델 성능 개선 효과를 나타내며 강력한 전이 가능성을 보여주었습니다.우리의 연구는 체계적으로 설계된 벤치마크와 일반화 가능한 후 훈련 프레임워크를 기여하며, 더 해석 가능하고 견고한 MLLMs 개발을 촉진합니다.