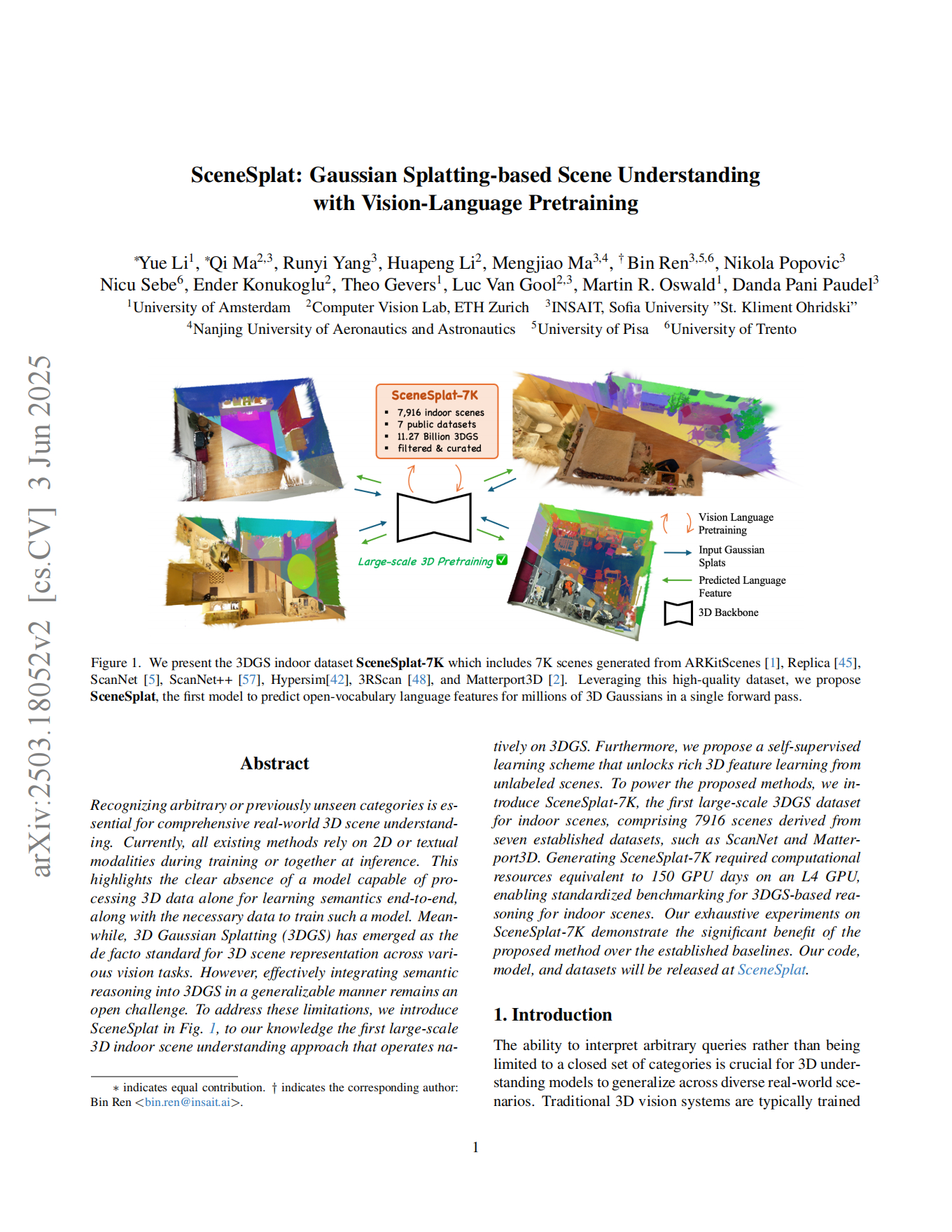

SceneSplat: 시각-언어 사전학습을 통한 가우시안 스플래터링 기반의 장면 이해

실제 환경의 3차원(3D) 장면을 포괄적으로 이해하기 위해서는 사전에 알려지지 않은 또는 임의의 카테고리를 인식하는 것이 필수적이다. 현재까지 제안된 모든 기법들은 학습 단계나 추론 단계에서 2차원(2D) 또는 텍스트 모달리티를 활용하고 있다. 이는 3D 데이터만을 사용하여 의미 정보를 엔드투엔드로 학습할 수 있는 모델과 이를 훈련할 수 있는 적절한 데이터의 명백한 부재를 시사한다. 한편, 3D 가우시안 스플래팅(3D Gaussian Splatting, 3DGS)은 다양한 시각 작업에서 3D 장면 표현의 사실상 표준으로 부상하고 있다. 그러나 3DGS에 일반화 가능한 방식으로 의미적 추론을 효과적으로 통합하는 것은 여전히 열린 과제로 남아 있다. 이러한 한계를 극복하기 위해, 본 연구에서는 3DGS를 원천적으로 활용하는 최초의 대규모 실내 장면 이해 방법론인 SceneSplat을 제안한다. 더불어, 레이블이 없는 장면에서 풍부한 3D 특징 학습을 가능하게 하는 자기지도 학습 방식을 제안한다. 제안된 방법론을 구현하기 위해, ScanNet 및 Matterport3D와 같은 7개의 기존 데이터셋에서 유도된 총 7,916개의 실내 장면으로 구성된, 실내 장면용으로 최초의 대규모 3DGS 데이터셋인 SceneSplat-7K를 소개한다. SceneSplat-7K를 생성하기 위해 L4 GPU 기준 약 150 GPU일에 해당하는 계산 자원이 필요했으며, 이는 실내 장면 기반 3DGS 기반 추론에 대한 표준화된 벤치마킹을 가능하게 한다. SceneSplat-7K를 대상으로 수행한 철저한 실험 결과는 제안된 방법론이 기존 벤치마크 대비 상당한 성능 향상을 보임을 입증한다.