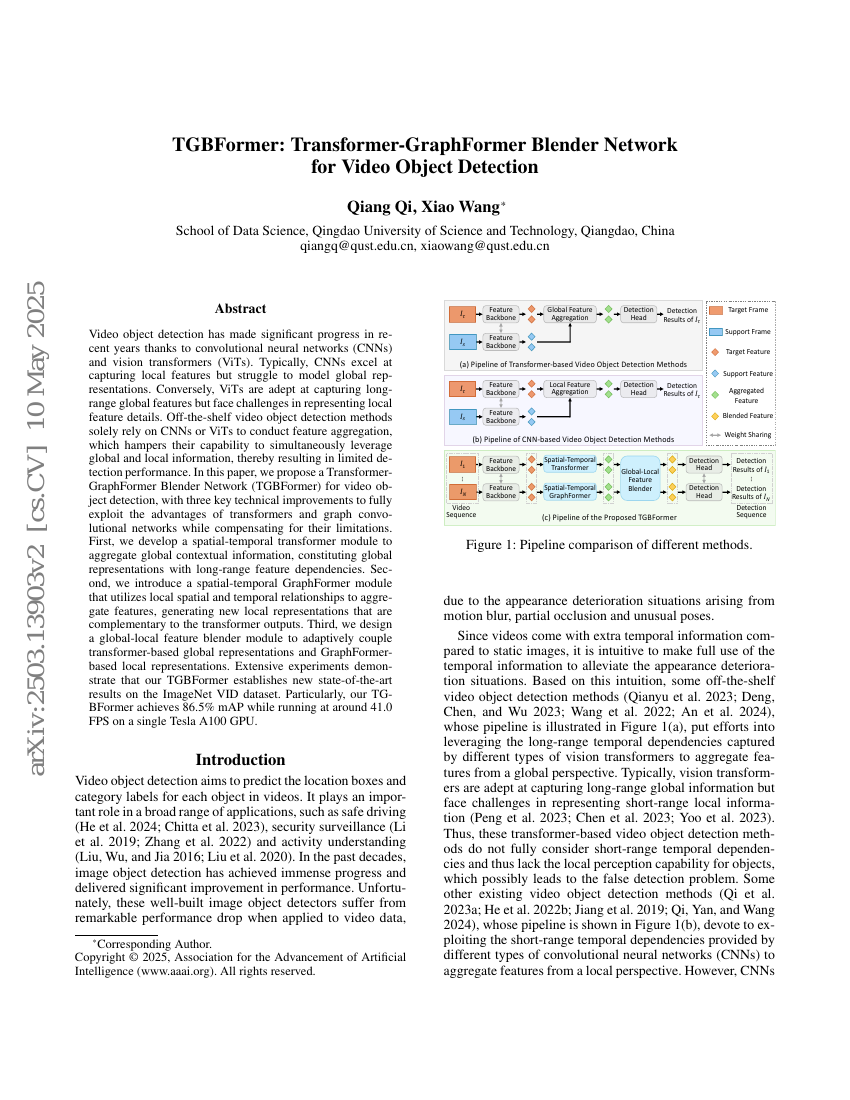

최근 몇 년간 컨볼루션 신경망(CNN)과 비전 트랜스포머(ViT)의 발전 덕분에 영상 객체 탐지 기술은 큰 진전을 이루었다. 일반적으로 CNN은 국소적 특징을 효과적으로 추출하지만, 전역적인 표현을 모델링하는 데 어려움을 겪는다. 반면 ViT는 장거리 전역적 특징을 잘 포착할 수 있지만, 국소적 특징 세부 정보를 표현하는 데 한계가 있다. 기존의 영상 객체 탐지 방법들은 특징 집약 과정에서 단순히 CNN 또는 ViT만을 사용하기 때문에, 전역적 정보와 국소적 정보를 동시에 활용하는 능력이 제한되어 탐지 성능에 한계가 있다. 본 논문에서는 트랜스포머와 그래프 컨볼루션 네트워크(GCN)의 장점을 극대화하고 각각의 단점을 보완하기 위해, 트랜스포머-그래프포머 블렌더 네트워크(TGBFormer)를 제안한다. 본 연구는 세 가지 핵심 기술적 개선을 통해 이를 달성한다. 첫째, 장거리 특징 종속성을 갖는 전역 표현을 구성하기 위해 시공간 트랜스포머 모듈을 개발하여 전역적 맥락 정보를 집약한다. 둘째, 국소적 공간적 및 시간적 관계를 활용하여 특징을 집약하는 시공간 그래프포머 모듈을 도입하여, 트랜스포머 출력과 보완적인 새로운 국소 표현을 생성한다. 셋째, 트랜스포머 기반 전역 표현과 그래프포머 기반 국소 표현을 적응적으로 결합할 수 있도록 전역-국소 특징 블렌더 모듈을 설계한다. 광범위한 실험을 통해 제안한 TGBFormer이 ImageNet VID 데이터셋에서 새로운 최고 성능(SOTA)을 달성함을 입증하였다. 특히, 단일 Tesla A100 GPU에서 약 41.0 FPS의 속도로 실행되면서도 86.5%의 mAP를 달성하여 뛰어난 성능을 보였다.