Command Palette

Search for a command to run...

Jarvis Guo Tuney Zheng Yuelin Bai Bo Li Yubo Wang King Zhu Yizhi Li Graham Neubig Wenhu Chen Xiang Yue

초록

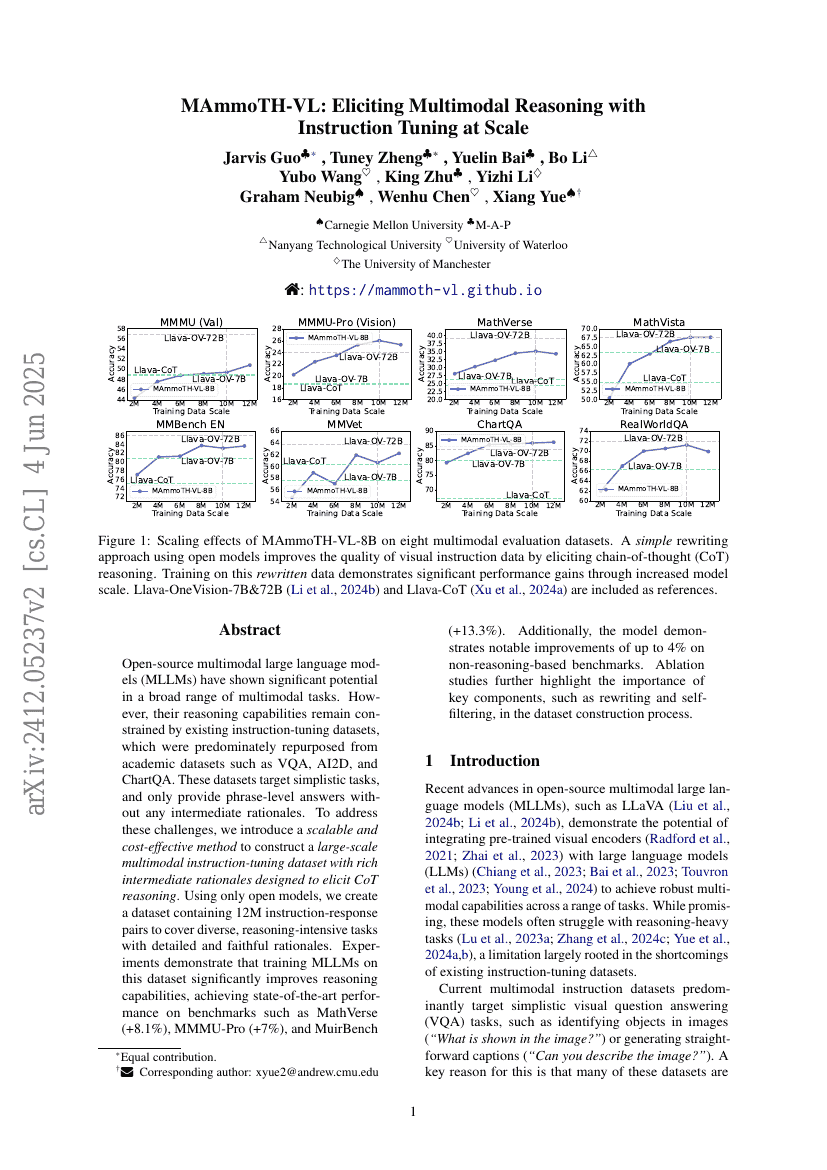

오픈 소스 다중 모드 대형 언어 모델(MLLMs)은 다양한 다중 모드 작업에서 상당한 잠재력을 보여주고 있습니다. 그러나 이들의 추론 능력은 VQA, AI2D, ChartQA와 같은 학술 데이터셋에서 주로 재활용된 기존의 지시어 조정 데이터셋으로 인해 제약을 받고 있습니다. 이러한 데이터셋은 단순한 작업을 목표로 하며, 중간 추론 과정 없이 문구 수준의 답변만 제공합니다. 이러한 문제를 해결하기 위해, 우리는 중간 추론 과정을 포함하여 CoT(Coherent Thought) 추론을 유도하도록 설계된 대규모 다중 모드 지시어 조정 데이터셋을 구축하는 확장성 있고 비용 효율적인 방법을 소개합니다. 오픈 모델만 사용하여, 우리는 1200만 개의 지시-응답 쌍으로 구성된 데이터셋을 생성하여 복잡한 추론 작업에 대한 상세하고 충실한 추론 과정을 포함하였습니다. 실험 결과, 이 데이터셋으로 MLLMs를 훈련시키면 추론 능력이 크게 향상되어 MathVerse(+8.1%), MMMU-Pro(+7%), MuirBench(+13.3%) 등의 벤치마크에서 최신 성능을 달성하였습니다. 또한, 비추론 기반 벤치마크에서도 최대 4%의 눈에 띄는 성능 향상을 보였습니다. 감소 실험(ablation studies)은 데이터셋 구축 과정에서 지시문 재작성 및 자기 필터링과 같은 핵심 구성 요소의 중요성을 더욱 강조해주었습니다.

코드 저장소

mammoth-vl/mammoth-vl

pytorch

GitHub에서 언급됨

벤치마크

| 벤치마크 | 방법론 | 지표 |

|---|---|---|

| visual-question-answering-on-mm-vet | MAmmoTH-VL-8B (SI) | GPT-4 score: 60.6 |

| visual-question-answering-on-mm-vet | MAmmoTH-VL-8B | GPT-4 score: 62.3 |