3달 전

NVILA: 효율적인 경계 시각 언어 모델

Zhijian Liu, Ligeng Zhu, Baifeng Shi, Zhuoyang Zhang, Yuming Lou, Shang Yang, Haocheng Xi, Shiyi Cao, Yuxian Gu, Dacheng Li, Xiuyu Li, Yunhao Fang, Yukang Chen, Cheng-Yu Hsieh, De-An Huang, An-Chieh Cheng, Vishwesh Nath, Jinyi Hu, Sifei Liu, Ranjay Krishna, Daguang Xu, Xiaolong Wang, Pavlo Molchanov, Jan Kautz, Hongxu Yin, Song Han, Yao Lu

초록

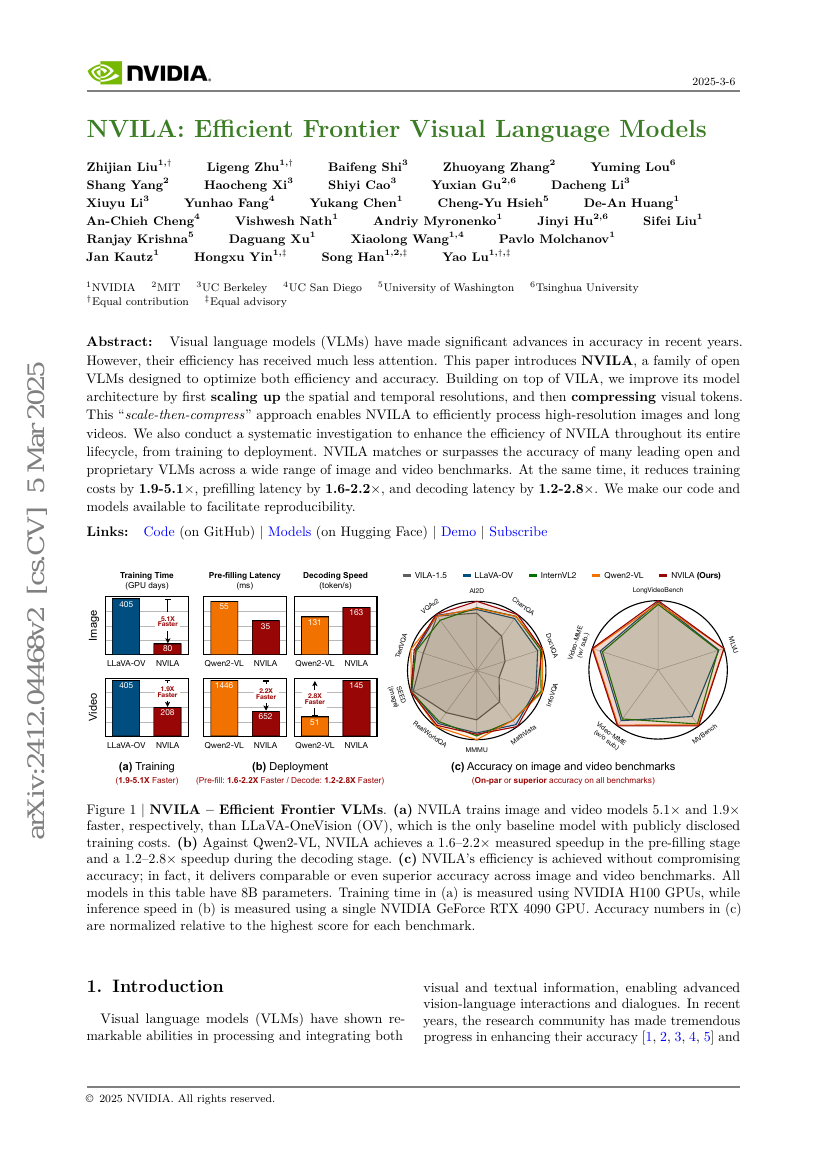

시각 언어 모델(VLMs)은 최근 몇 년간 정확도 측면에서 상당한 진전을 이루었으나, 효율성에 대한 관심은 훨씬 적었다. 본 논문에서는 정확도와 효율성을 동시에 최적화하기 위해 설계된 오픈 소스 VLM인 NVILA를 소개한다. VILA 기반으로, 먼저 공간적 및 시계적 해상도를 확장한 후, 시각 토큰을 압축하는 방식으로 모델 아키텍처를 개선하였다. 이러한 '확장 후 압축(scale-then-compress)' 접근법을 통해 NVILA는 고해상도 이미지와 긴 영상도 효율적으로 처리할 수 있다. 또한, 훈련, 미세조정(fine-tuning), 배포에 이르는 전 생애 주기 동안 NVILA의 효율성을 향상시키기 위한 체계적인 조사를 수행하였다. NVILA는 다양한 이미지 및 영상 벤치마크에서 많은 선도적인 오픈 소스 및 전용 VLM들과 비교해 정확도를 격차 없이 달성하거나 이를 초월한다. 동시에, 훈련 비용을 4.5배 감소시키고, 미세조정 시 메모리 사용량을 3.4배 줄이며, 프리필링(latency)을 1.6~2.2배, 디코딩(latency)을 1.2~2.8배 감소시켰다. 곧 코드와 모델을 공개하여 재현 가능성을 높일 예정이다.