Command Palette

Search for a command to run...

Senqiao Yang Yukang Chen Zhuotao Tian Chengyao Wang Jingyao Li Bei Yu Jiaya Jia

초록

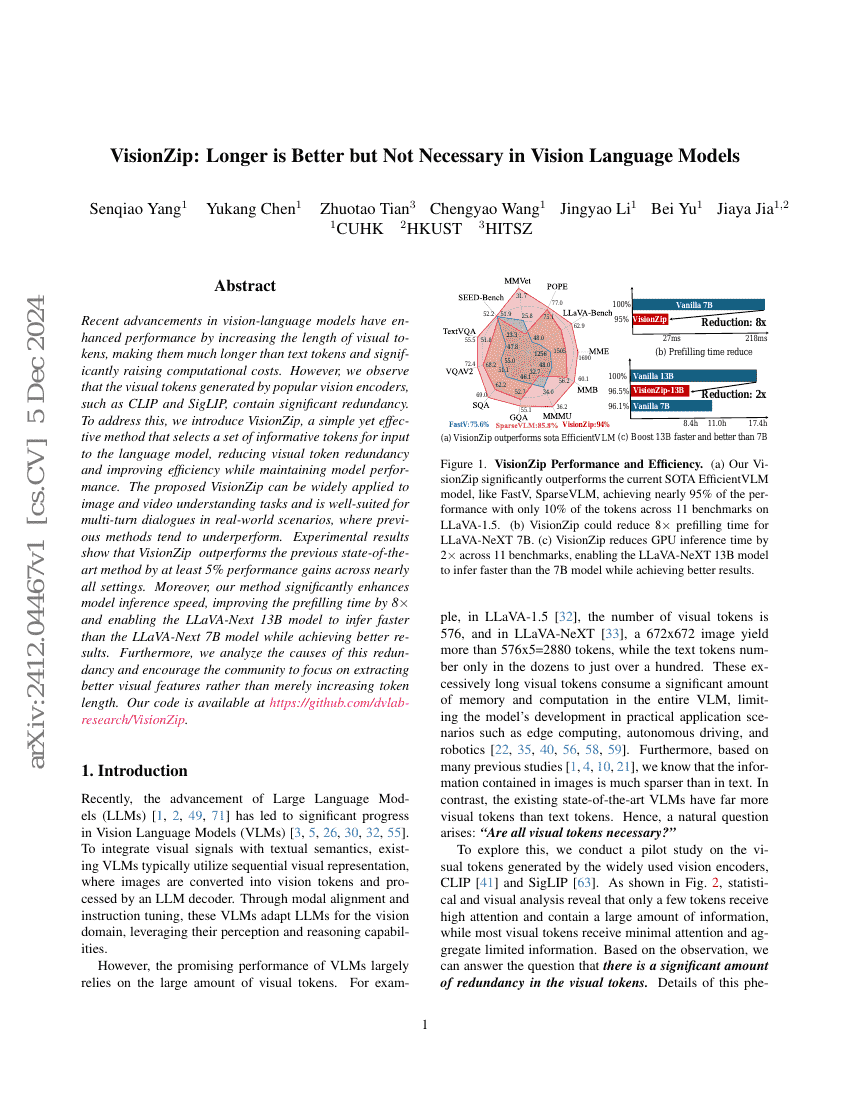

최근 비전-언어 모델의 발전은 시각 토큰의 길이를 늘림으로써 성능을 향상시켰으나, 이로 인해 시각 토큰이 텍스트 토큰보다 훨씬 길어지고 계산 비용이 급격히 증가하는 문제가 발생하고 있다. 그러나 우리는 CLIP 및 SigLIP와 같은 인기 있는 비전 인코더가 생성하는 시각 토큰에 상당한 중복성이 존재함을 관찰하였다. 이를 해결하기 위해, 언어 모델에 입력할 정보성 있는 토큰 집합을 선택하는 간단하면서도 효과적인 방법인 VisionZip을 제안한다. 이 방법은 시각 토큰의 중복성을 줄이고 효율성을 향상시키면서도 모델 성능을 유지한다. 제안된 VisionZip은 이미지 및 비디오 이해 작업에 널리 적용 가능하며, 실세계 시나리오에서 다중 회차 대화와 같은 상황에 특히 적합하다. 기존 방법들이 이러한 상황에서 성능이 저하되는 경향이 있는 반면, VisionZip은 보다 우수한 성능을 발휘한다. 실험 결과, 거의 모든 설정에서 기존 최고 성능 기법보다 최소 5% 이상의 성능 향상을 달성함을 확인하였다. 더불어 본 방법은 모델 추론 속도를 크게 향상시켜, 프리필링 시간을 8배 가량 단축하였으며, LLaVA-Next 13B 모델이 LLaVA-Next 7B 모델보다 빠른 추론 속도를 보이면서도 더 우수한 결과를 얻을 수 있도록 했다. 또한, 이러한 중복성의 원인을 분석하고, 단순히 토큰 길이를 늘리는 것에 그치지 않고, 보다 우수한 시각 특징을 추출하는 데에 주목할 것을 공동체에 권장한다. 본 연구의 코드는 https://github.com/dvlab-research/VisionZip 에 공개되어 있다.

코드 저장소

벤치마크

| 벤치마크 | 방법론 | 지표 |

|---|---|---|

| visual-question-answering-on-mm-vet | VisionZip (Retain 128 Tokens, fine-tuning) | GPT-4 score: 32.9 |

| visual-question-answering-on-mm-vet | VisionZip (Retain 64 Tokens, fine-tuning) | GPT-4 score: 30.2 |

| visual-question-answering-on-mm-vet | VisionZip (Retain 128 Tokens) | GPT-4 score: 32.6 |

| visual-question-answering-on-mm-vet | VisionZip (Retain 192 Tokens, fine-tuning) | GPT-4 score: 32.6 |

| visual-question-answering-on-mm-vet | VisionZip (Retain 192 Tokens) | GPT-4 score: 31.7 |

| visual-question-answering-on-mm-vet | VisionZip (Retain 64 Tokens) | GPT-4 score: 31.7 |