3달 전

백천 옴니 기술 보고서

Yadong Li, Haoze Sun, Mingan Lin, Tianpeng Li, Guosheng Dong, Tao Zhang, Bowen Ding, Wei Song, Zhenglin Cheng, Yuqi Huo, Song Chen, Xu Li, Da Pan, Shusen Zhang, Xin Wu, Zheng Liang, Jun Liu, Tao Zhang, Keer Lu, Yaqi Zhao, Yanjun Shen, Fan Yang, Kaicheng Yu, Tao Lin, Jianhua Xu, Zenan Zhou, Weipeng Chen

초록

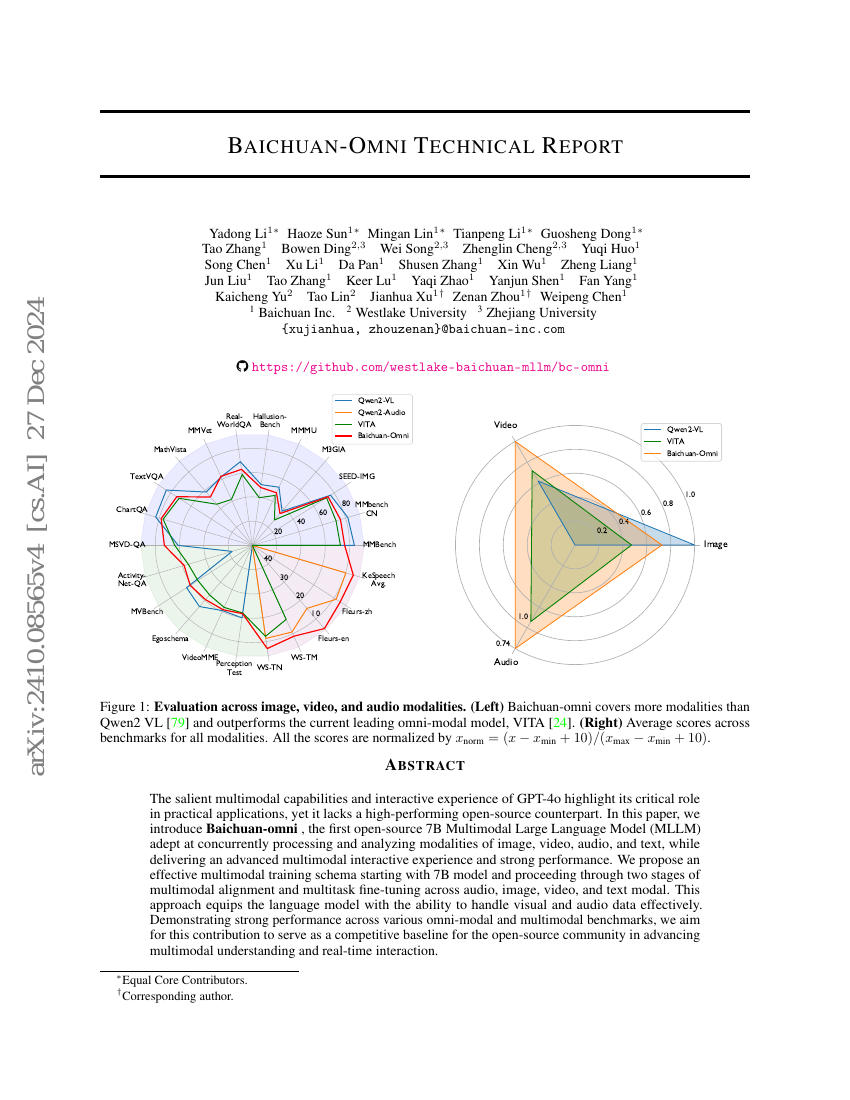

GPT-4o의 두드러진 다중모달 기능과 상호작용 경험은 실용적 응용 분야에서 그 핵심적인 역할을 부각시키고 있으나, 고성능의 오픈소스 대안이 부족한 실정이다. 본 논문에서는 이미지, 영상, 음성, 텍스트 등 다양한 모달리티를 동시에 처리하고 분석할 수 있는 7B 규모의 최초의 오픈소스 다중모달 대규모 언어 모델(Baichuan-Omni)을 소개한다. 이 모델은 고도화된 다중모달 상호작용 경험과 뛰어난 성능을 제공한다. 우리는 7B 규모의 모델을 기반으로 하여, 음성, 이미지, 영상, 텍스트 모달리티에 걸쳐 두 단계의 다중모달 정렬과 다중 작업 미세조정을 수행하는 효과적인 다중모달 훈련 체계를 제안한다. 이 방법은 언어 모델이 시각적 및 음성 데이터를 효과적으로 처리할 수 있는 능력을 부여한다. 다양한 옴니모달 및 다중모달 벤치마크에서 우수한 성능을 입증한 본 연구는 오픈소스 커뮤니티가 다중모달 이해 및 실시간 상호작용 기술을 발전시켜 나가기 위한 경쟁력 있는 기준이 되기를 기대한다.