3달 전

CogVLM2: 이미지 및 비디오 이해를 위한 시각 언어 모델

Wenyi Hong, Weihan Wang, Ming Ding, Wenmeng Yu, Qingsong Lv, Yan Wang, Yean Cheng, Shiyu Huang, Junhui Ji, Zhao Xue, Lei Zhao, Zhuoyi Yang, Xiaotao Gu, Xiaohan Zhang, Guanyu Feng, Da Yin, Zihan Wang, Ji Qi, Xixuan Song, Peng Zhang, Debing Liu, Bin Xu, Juanzi Li, Yuxiao Dong, Jie Tang

초록

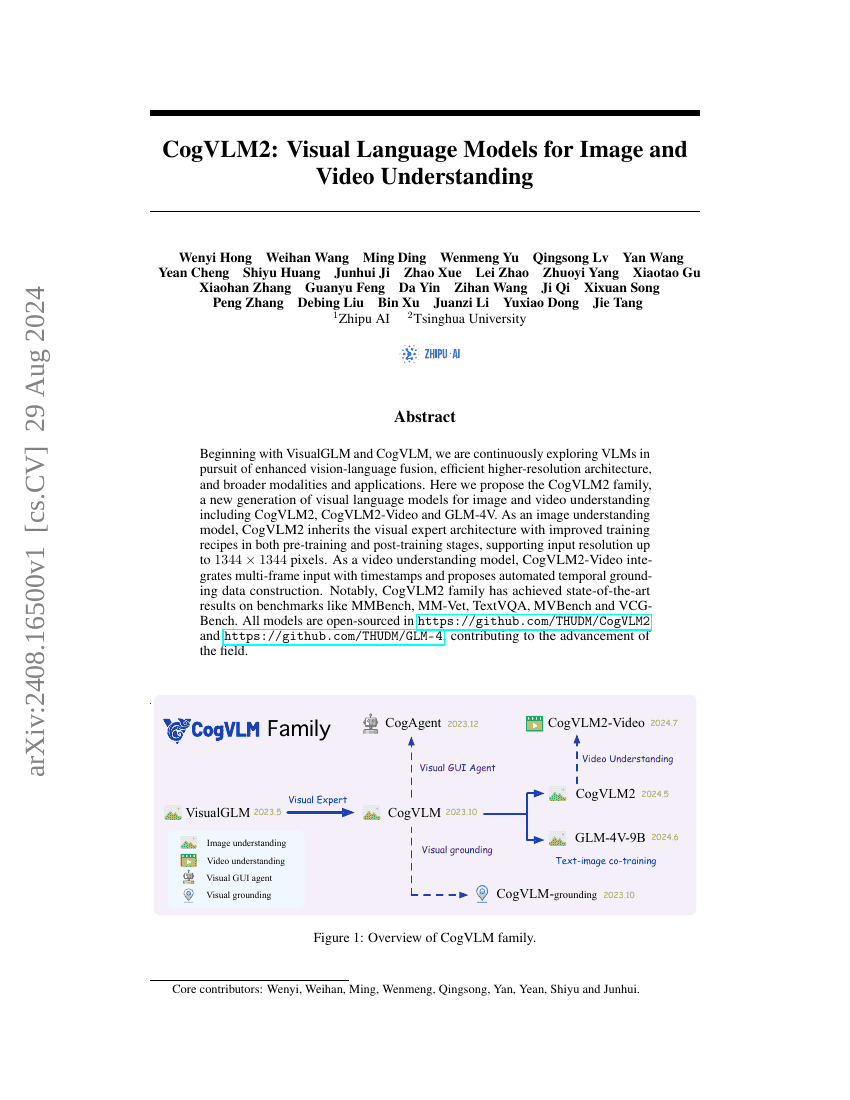

VisualGLM과 CogVLM을 시작으로, 우리는 시각-언어 융합의 향상, 고해상도 아키텍처의 효율성 향상, 그리고 더 넓은 모달리티와 응용 분야를 목표로 지속적으로 VLMs(Vision-Language Models)를 탐구해 왔습니다. 이번에는 이미지 및 영상 이해를 위한 새로운 세대의 시각-언어 모델인 CogVLM2 패밀리를 제안합니다. 이 패밀리에는 CogVLM2, CogVLM2-Video, 그리고 GLM-4V가 포함됩니다. 이미지 이해 모델로서 CogVLM2는 개선된 사전학습 및 후속학습 트레이닝 레시피를 갖춘 시각 전문가 아키텍처를 계승하며, 최대 1344×1344 픽셀의 입력 해상도를 지원합니다. 영상 이해 모델로서 CogVLM2-Video는 다중 프레임 입력과 타임스탬프를 통합하고, 자동 타임스탬프 기반 데이터 구축 기법을 제안합니다. 특히 CogVLM2 패밀리는 MMBench, MM-Vet, TextVQA, MVBench, VCGBench 등의 벤치마크에서 최고 성능을 기록하며, 현재 최고 수준의 성과를 달성하였습니다. 모든 모델는 https://github.com/THUDM/CogVLM2 및 https://github.com/THUDM/GLM-4에서 오픈소스로 공개되어, 이 분야의 기술 발전에 기여하고 있습니다.