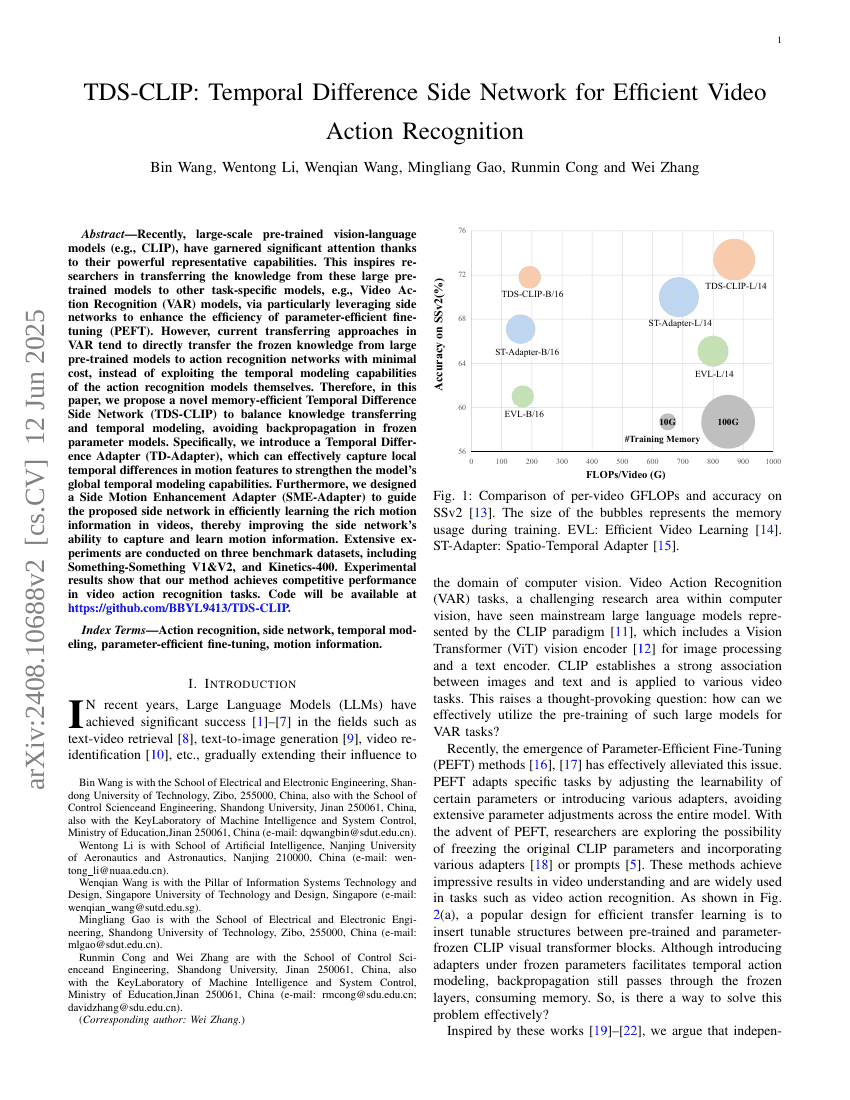

최근, 대규모 사전 학습 시각-언어 모델(예: CLIP)은 강력한 표현 능력 덕분에 많은 주목을 받고 있습니다. 이는 연구자들이 이러한 대규모 사전 학습 모델의 지식을 다른 특정 작업 모델, 예를 들어 비디오 동작 인식(VAR) 모델로 전송하는 데 영감을 주었습니다. 특히, 부가 네트워크를 활용하여 매개변수 효율적인 미세 조정(PEFT)의 효율성을 향상시키는 방법이 주목받고 있습니다. 그러나 현재 VAR에서의 전송 접근 방식은 대부분 큰 사전 학습 모델에서 동작 인식 네트워크로 직접적으로 동결된 지식을 최소 비용으로 전송하려는 경향이 있으며, 동작 인식 모델 자체의 시간적 모델링 능력을 활용하지 않는 경우가 많습니다.따라서 본 논문에서는 지식 전송과 시간적 모델링 사이의 균형을 맞추면서 동결된 매개변수 모델에서 역전파를 피할 수 있는 메모리 효율적인 시간 차이 부가 네트워크(TDS-CLIP)를 제안합니다. 구체적으로, 우리는 로컬 시간 차이를 효과적으로 포착하여 모델의 전역 시간적 모델링 능력을 강화할 수 있는 시간 차이 어댑터(TD-Adapter)를 도입하였습니다. 또한, 부가 네트워크가 비디오 내부의 풍부한 운동 정보를 효율적으로 학습하도록 안내하는 부가 운동 정보 강화 어댑터(SME-Adapter)를 설계하였습니다. 이를 통해 부가 네트워크의 운동 정보 포착 및 학습 능력을 개선하였습니다.본 연구에서는 Something-Something V1&V2와 Kinetics-400 등 세 가지 벤치마크 데이터셋에서 광범위한 실험을 수행하였으며, 실험 결과는 우리의 접근 방식이 경쟁력 있는 성능을 달성함을 입증하고 있습니다.