Step-DPO: LLM의 장쇄 추론을 위한 단계별 선호 최적화

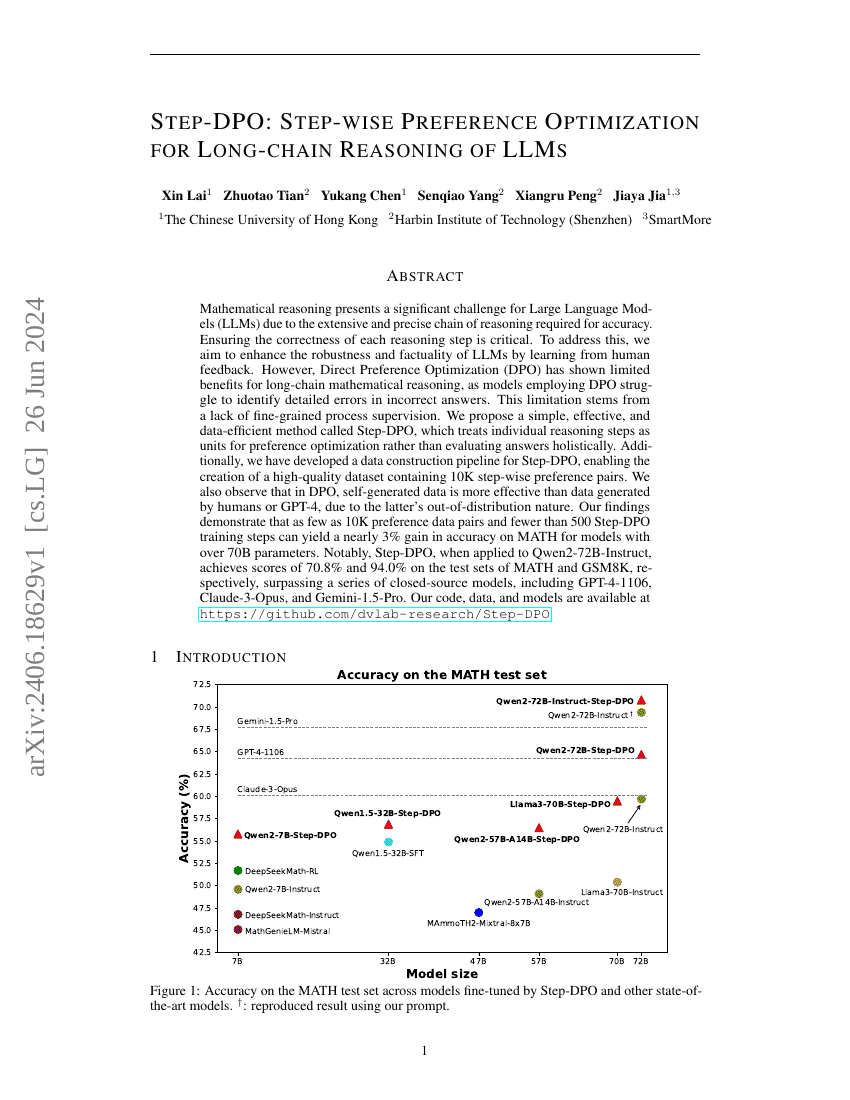

수학적 추론은 정확도를 달성하기 위해 긴 연쇄적이고 정밀한 추론 과정이 요구되기 때문에 대규모 언어 모델(Large Language Models, LLMs)에게 중요한 도전 과제입니다. 각 추론 단계의 정확성을 보장하는 것은 매우 중요합니다. 이를 해결하기 위해 우리는 인간 피드백을 통해 LLM의 견고성과 사실성 향상을 목표로 하고 있습니다. 그러나 직접적 선호 최적화(Direct Preference Optimization, DPO)는 긴 연쇄 수학 추론에 대해 제한된 효과를 보였으며, DPO를 사용하는 모델들은 잘못된 답변 속의 세부적인 오류를 식별하는 데 어려움을 겪습니다. 이 한계는 세밀한 과정 감시의 부재에서 비롯됩니다. 우리는 단계별 추론 단계를 선호 최적화의 단위로 다루는 것으로, 답변을 종합적으로 평가하는 방식이 아닌, 개별 추론 단계를 중심으로 하는 간단하면서도 효과적이고 데이터 효율적인 방법인 Step-DPO를 제안합니다. 또한 Step-DPO를 위한 데이터 구축 파이프라인을 개발하여 1만 개의 단계별 선호 쌍을 포함하는 고품질 데이터셋을 생성할 수 있도록 했습니다. 또한 DPO에서 인간이나 GPT-4가 생성한 데이터보다 모델이 자체 생성한 데이터가 더 효과적임을 관찰하였으며, 이는 후자의 데이터가 분포 외(out-of-distribution) 성향을 지니기 때문입니다. 우리의 연구 결과에 따르면, 단 1만 개의 선호 데이터 쌍과 500회 미만의 Step-DPO 학습 단계만으로도 700억 파라미터 이상의 모델에서 MATH 데이터셋에서 약 3%의 정확도 향상을 달성할 수 있습니다. 특히 Qwen2-72B-Instruct에 Step-DPO를 적용한 결과, MATH와 GSM8K의 테스트 세트에서 각각 70.8%와 94.0%의 성능을 기록하며, GPT-4-1106, Claude-3-Opus, Gemini-1.5-Pro 등 여러 폐쇄형 모델을 상회하는 성능을 보였습니다. 본 연구의 코드, 데이터 및 모델은 https://github.com/dvlab-research/Step-DPO 에서 공개되어 있습니다.