Command Palette

Search for a command to run...

Peize Sun Yi Jiang Shoufa Chen Shilong Zhang Bingyue Peng Ping Luo Zehuan Yuan

초록

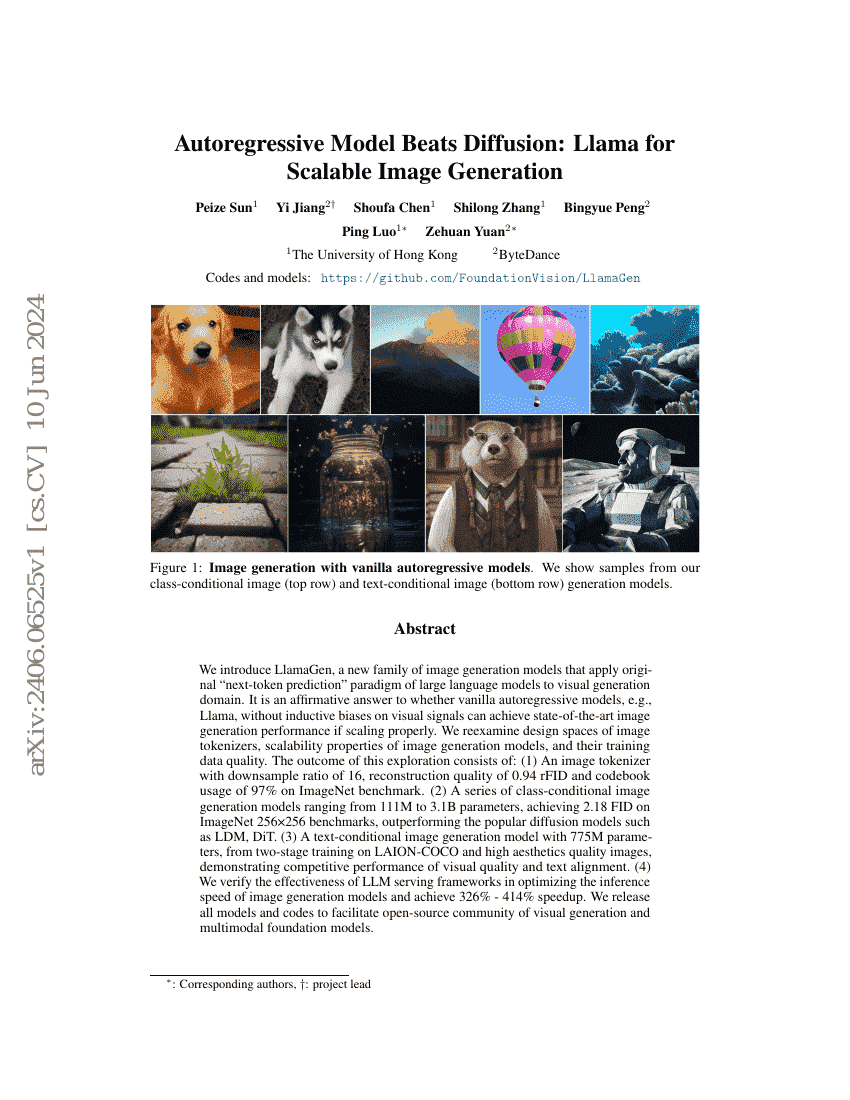

우리는 대규모 언어 모델의 원초적인 '다음 토큰 예측' 패러다임을 시각 생성 분야에 적용한 새로운 이미지 생성 모델 세트인 LlamaGen을 소개한다. 이는 시각 신호에 대한 유도적 편향(inductive biases) 없이도, 단순한 자기회귀 모델(예: Llama)이 충분히 스케일링된다면 최첨단 이미지 생성 성능을 달성할 수 있는지를 긍정적으로 입증하는 결과이다. 우리는 이미지 토크나이저의 설계 공간, 이미지 생성 모델의 확장성 특성, 그리고 학습 데이터의 품질을 재검토하였다. 이러한 탐구의 결과로 다음과 같은 성과를 도출하였다: (1) 이미지넷 기준에서 다운샘플 비율 16, 재구성 품질 0.94 rFID, 코드북 사용률 97%를 달성한 이미지 토크나이저. (2) 파라미터 수가 111M에서 3.1B에 이르는 클래스 조건부 이미지 생성 모델 시리즈로, 이미지넷 256x256 벤치마크에서 FID 점수 2.18을 기록하며, LDM, DiT 등 인기 있는 확산 모델들을 능가하였다. (3) LAION-COCO 및 고미학적 품질의 이미지에 대해 이단계 학습을 거친 775M 파라미터의 텍스트 조건부 이미지 생성 모델로, 시각 품질과 텍스트 정렬 측면에서 경쟁력 있는 성능을 보였다. (4) LLM 서빙 프레임워크가 이미지 생성 모델의 추론 속도 최적화에 효과적임을 검증하였으며, 최대 326%~414%의 속도 향상을 달성하였다. 본 연구에서는 모든 모델과 코드를 공개하여 시각 생성 및 다중모달 기초 모델 분야의 오픈소스 커뮤니티 발전을 촉진하고자 한다.

코드 저장소

벤치마크

| 벤치마크 | 방법론 | 지표 |

|---|---|---|

| image-generation-on-imagenet-256x256 | LlamaGen | FID: 2.18 |