Meta-tuning을 통한 Few-shot Generalization을 위한Sparse Interpolated Experts의 활용

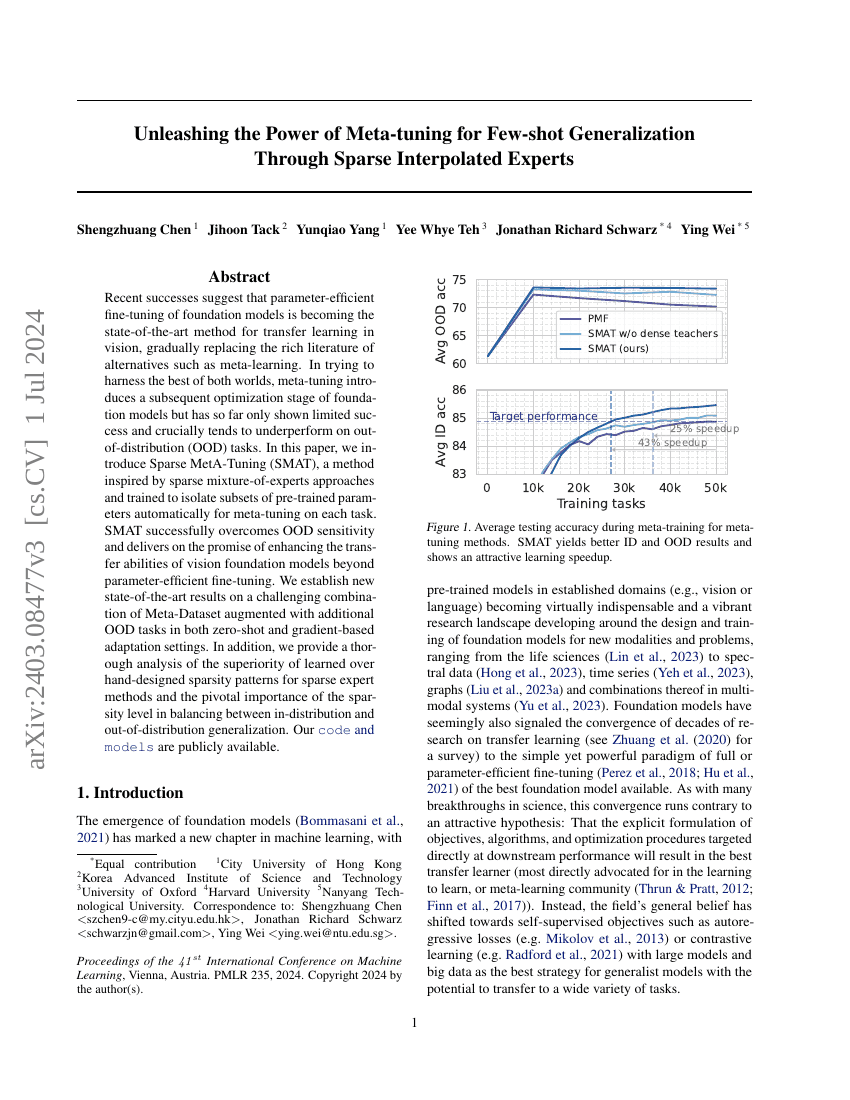

최근의 성공 사례는 비전 분야에서 전이 학습의 최신 방법으로 파라미터 효율적인 미세 조정(fine-tuning)이 기초 모델(foundation models)에 적용되는 것을 보여주며, 메타 학습(meta-learning)과 같은 다양한 대안들을 대체하고 있습니다. 두 세계의 장점을 모두 활용하려는 시도로, 메타 튜닝(meta-tuning)은 기초 모델의 후속 최적화 단계를 도입하지만, 아직까지 제한된 성공만을 보였으며 특히 분포 외(out-of-distribution, OOD) 작업에서 성능이 떨어지는 경향이 있습니다.본 논문에서는 희소 혼합 전문가(sparse mixture-of-experts) 접근 방식에서 영감을 받은 Sparse MetA-Tuning (SMAT) 방법을 소개합니다. 이 방법은 각 작업에 대한 메타 튜닝을 위해事前학습된 파라미터의 부분 집합을 자동으로 분리하도록 훈련됩니다. SMAT는 OOD 민감성을 성공적으로 극복하고, 비전 기초 모델의 전이 능력을 파라미터 효율적인 미세 조정을 넘어서 향상시키는 약속을 지킵니다. 우리는 제로샷(zero-shot) 및 그래디언트 기반 적응(gradient-based adaptation) 환경에서 추가적인 OOD 작업이 포함된 Meta-Dataset을 사용하여 새로운 최고 수준의 결과를 제시합니다.또한, 우리는 학습된 희소성 패턴과 수작업으로 설계된 희소성 패턴 간의 우수성을 철저히 분석하며, 희소 전문가 방법에서 희소성 수준(sparsity level)이 분포 내(in-distribution)와 분포 외 일반화 사이의 균형을 맞추는 데 있어 결정적인 역할을 함을 강조합니다. 우리의 코드는 공개되어 있습니다.