3달 전

DiffiT: 이미지 생성을 위한 확산 시각 변환기

Ali Hatamizadeh, Jiaming Song, Guilin Liu, Jan Kautz, Arash Vahdat

초록

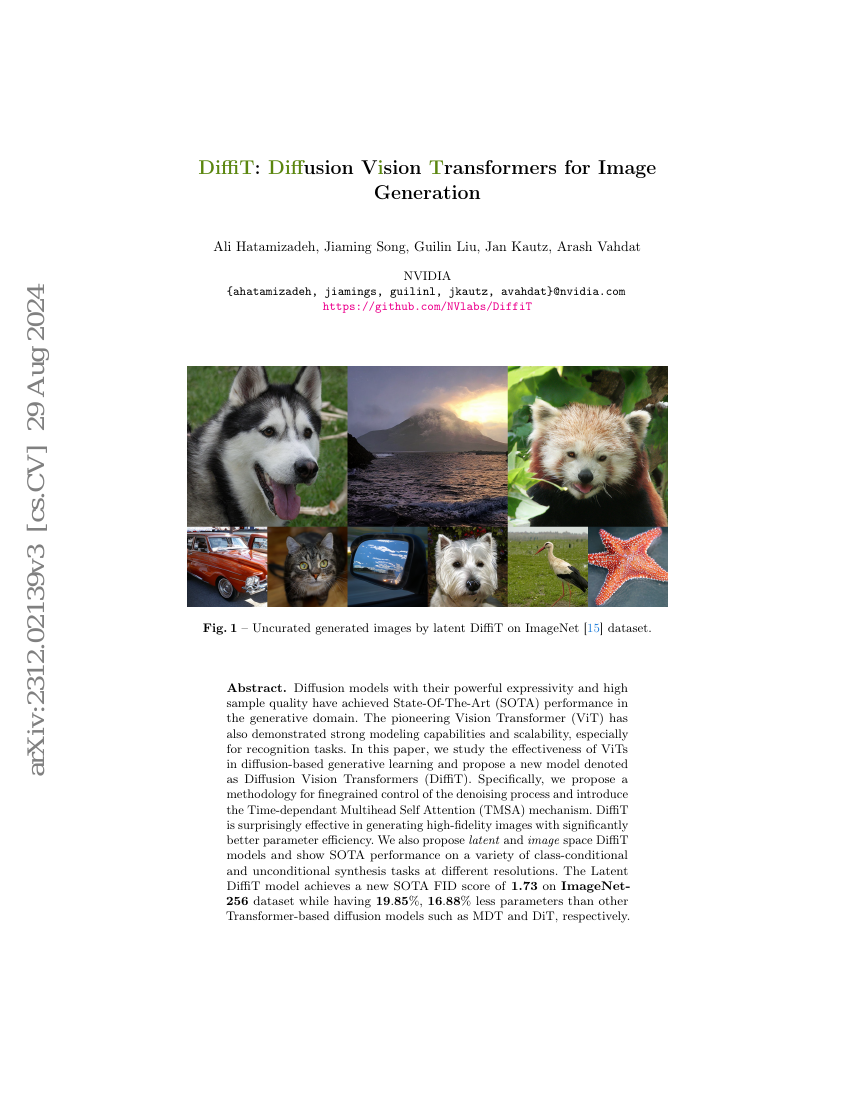

표현력이 뛰어나고 샘플 품질이 높은 특징을 지닌 확산 모델(Diffusion models)은 생성 영역에서 최첨단(SOTA) 성능을 달성하였다. 선구적인 비전 트랜스포머(Vision Transformer, ViT) 역시 인식 작업에 특히 두드러진 모델링 능력과 확장성을 보여주며 강력한 성능을 입증하였다. 본 논문에서는 ViT가 확산 기반 생성 학습에서 얼마나 효과적인지 탐구하고, 새로운 모델인 확산 비전 트랜스포머(Diffusion Vision Transformers, DiffiT)를 제안한다. 구체적으로, 노이즈 제거 과정에 대한 세밀한 제어를 위한 방법론을 제안하고, 시간에 따라 변하는 다중 헤드 자기 주의(Multihead Self Attention, TMSA) 메커니즘을 도입한다. DiffiT는 높은 정밀도의 이미지를 생성하는 데 놀라운 효과를 보이며, 파라미터 효율성 측면에서 훨씬 우수한 성능을 나타낸다. 또한 잠재 공간과 이미지 공간을 기반으로 한 DiffiT 모델을 제안하고, 다양한 클래스 조건부 및 무조건적 생성 작업에서 다양한 해상도에서 최첨단 성능을 입증한다. 잠재 공간 기반의 DiffiT 모델은 ImageNet256 데이터셋에서 기존 트랜스포머 기반 확산 모델인 MDT 및 DiT보다 각각 19.85%, 16.88% 적은 파라미터로 새로운 SOTA FID 점수 1.73을 달성하였다. 코드: https://github.com/NVlabs/DiffiT