MoCaE: 캘리브레이션된 전문가의 혼합이 객체 탐지 성능을 크게 향상시킨다

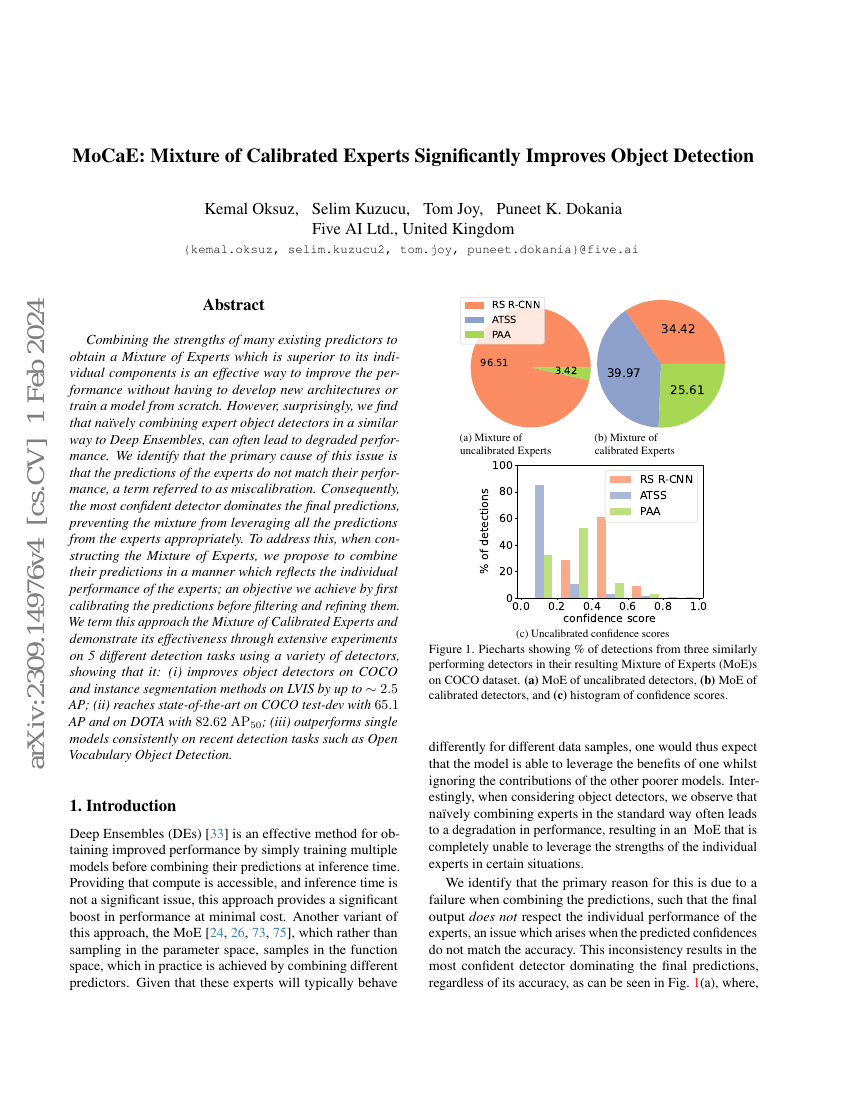

기존 예측기들의 강점을 결합하여 개별 구성 요소보다 우수한 성능을 보이는 '전문가의 혼합(Mixture of Experts)'을 구성하는 것은 새로운 아키텍처를 개발하거나 모델을 처음부터 훈련할 필요 없이 성능을 향상시키는 효과적인 방법이다. 그러나 놀랍게도, Deep Ensembles와 유사한 방식으로 전문가 객체 탐지기들을 단순히 결합할 경우 성능 저하가 자주 발생함을 발견하였다. 이 문제의 주요 원인은 전문가들의 예측이 그들의 실제 성능과 일치하지 않는다는 점, 즉 '비교정(miscalibration)' 현상에 있음을 규명하였다. 결과적으로 가장 자신감이 강한 탐지기가 최종 예측을 지배하게 되어, 전문가들의 모든 예측을 적절히 활용할 수 없게 된다. 이를 해결하기 위해, 전문가의 예측을 구성할 때 각 전문가의 개별 성능을 반영하는 방식을 제안한다. 이를 위해 예측을 필터링하고 개선하기 전에 먼저 예측을 비교정하는 과정을 거친다. 이러한 접근을 '비교정된 전문가의 혼합(Mixture of Calibrated Experts)'이라 명명하며, 다양한 탐지기와 5가지 다른 탐지 작업에 대한 광범위한 실험을 통해 그 효과를 입증하였다. 실험 결과, 본 방법은: (i) COCO에서 객체 탐지기와 LVIS에서 인스턴스 세그멘테이션 방법의 성능을 최대 약 2.5 AP 향상시켰으며, (ii) COCO test-dev에서 65.1 AP, DOTA에서는 82.62 AP₅₀로 최신 기준을 달성하였으며, (iii) 오픈 어휘 객체 탐지와 같은 최근 탐지 작업에서도 단일 모델을 일관되게 능가함을 확인하였다.