UniTR: Bird's-Eye-View 표현을 위한 통합적이고 효율적인 다중 모달 Transformer

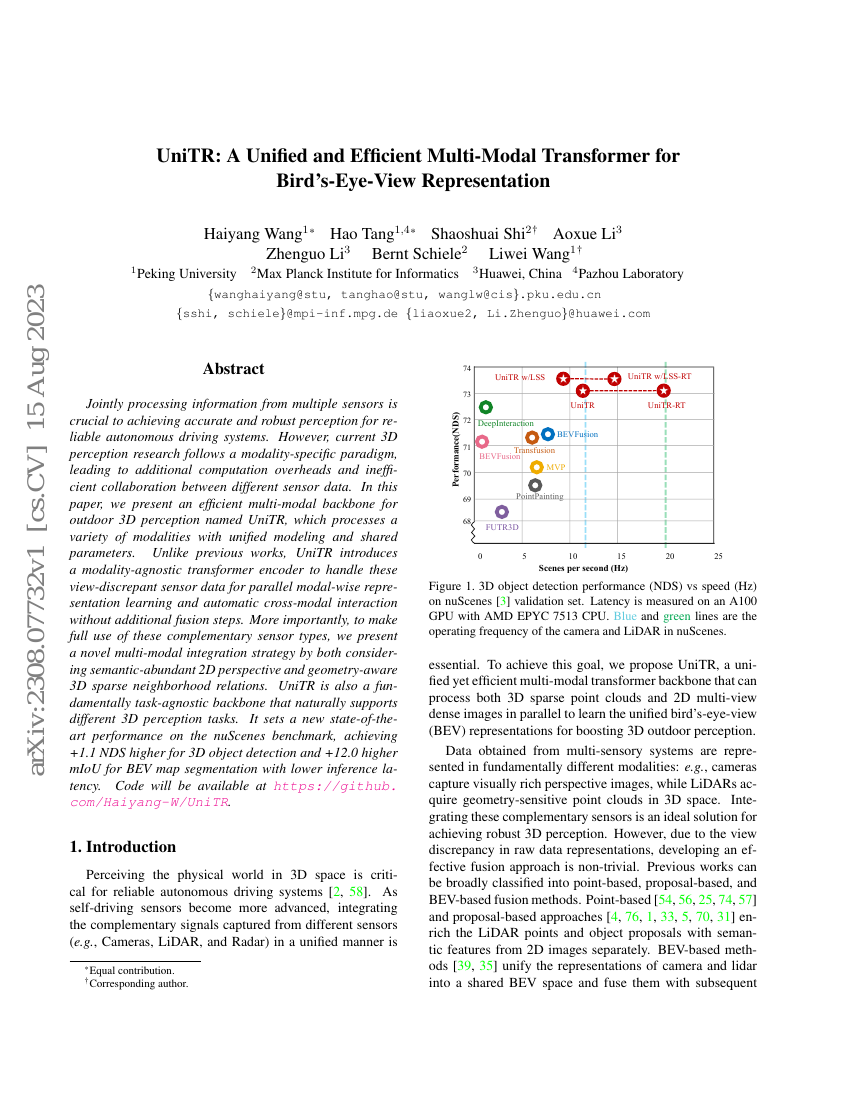

다수의 센서로부터 정보를 공동 처리하는 것은 신뢰할 수 있는 자율 주행 시스템을 위한 정확하고 견고한 인식을 달성하는 데 핵심적이다. 그러나 현재의 3차원(3D) 인식 연구는 각 모달리티에 특화된 접근 방식을 따르고 있어, 추가적인 계산 부담과 서로 다른 센서 데이터 간의 비효율적인 협업을 초래한다. 본 논문에서는 다양한 모달리티를 통합된 모델링과 공유 파라미터로 처리할 수 있는 효율적인 다중 모달 기반 구조인 UniTR를 제안한다. 기존 연구와 달리, UniTR는 추가적인 융합 단계 없이, 서로 다른 시점에서의 센서 데이터를 처리하기 위해 모달리티에 무관한(transformer) 인코더를 도입하여 병렬적인 모달별 표현 학습과 자동적인 다중 모달 상호작용을 가능하게 한다. 더욱 중요한 점은, 서로 보완적인 센서 유형의 잠재력을 극대화하기 위해, 2D 관점에서의 의미 정보가 풍부한 특징과 3D 희소 이웃 관계를 기반으로 한 기하학적 인식을 동시에 고려하는 새로운 다중 모달 통합 전략을 제안한다는 것이다. 또한 UniTR는 본질적으로 작업에 무관한 기반 구조로 설계되어, 다양한 3D 인식 작업을 자연스럽게 지원한다. 이는 nuScenes 벤치마크에서 새로운 최고 성능을 기록하며, 3D 객체 탐지에서는 NDS(Noisy Detection Score) 기준 +1.1 향상, BEV 맵 세그멘테이션에서는 mIoU 기준 +12.0 향상되면서도 추론 지연 시간이 감소하는 결과를 보였다. 코드는 https://github.com/Haiyang-W/UniTR 에 공개될 예정이다.