어떤 것을 디코딩할지, 어떤 것을 훈련할지에 초점을 맞추기: 특정 타겟을 기반으로 한 DeNoising과 비전-언어 어드바이저를 활용한 SOV 디코딩

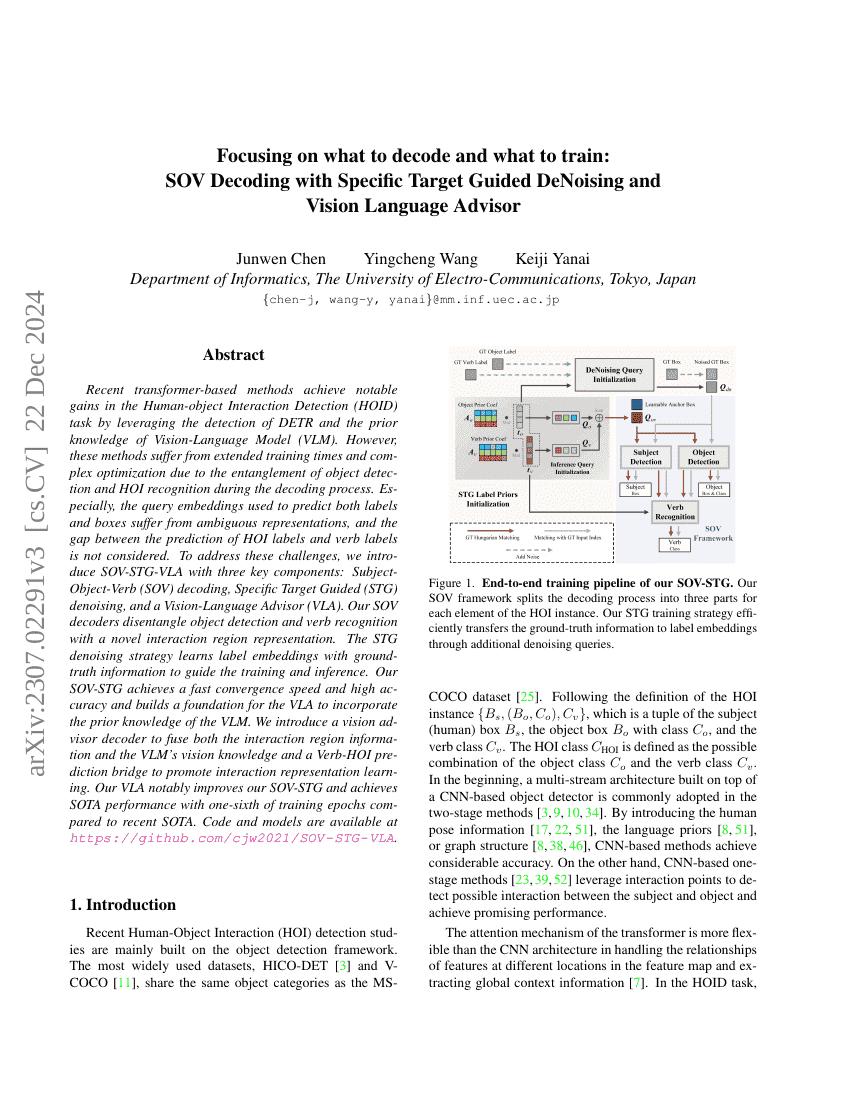

최근의 트랜스포머 기반 방법들은 DETR의 탐지 능력과 비전-언어 모델(Vision-Language Model, VLM)의 사전 지식을 활용함으로써 인간-객체 상호작용 탐지(Human-object Interaction Detection, HOID) 작업에서 두드러진 성과를 달성하고 있다. 그러나 이러한 방법들은 디코딩 과정에서 객체 탐지와 HOI 인식이 얽혀 있어 학습 시간이 길어지고 최적화 과정이 복잡해지는 문제가 있다. 특히, 라벨과 박스를 동시에 예측하기 위해 사용되는 쿼리 임베딩은 표현이 모호해지고, HOI 라벨 예측과 동사 라벨 예측 간의 격차를 고려하지 못하는 문제가 존재한다. 이러한 문제를 해결하기 위해, 우리는 세 가지 핵심 구성 요소를 갖춘 SOV-STG-VLA를 제안한다: 주어-목적어-동사(SOV) 디코딩, 특정 대상 유도(Denoising, STG), 그리고 비전-언어 어드바이저(Vision-Language Advisor, VLA). 우리의 SOV 디코더는 새로운 상호작용 영역 표현 방식을 통해 객체 탐지와 동사 인식을 분리한다. STG 디노이징 전략은 정답 정보를 기반으로 라벨 임베딩을 학습하여 학습 및 추론을 안내한다. SOV-STG는 빠른 수렴 속도와 높은 정확도를 달성하며, VLA가 VLM의 사전 지식을 통합할 수 있는 기반을 마련한다. 또한, 상호작용 영역 정보와 VLM의 비전 지식을 융합하기 위한 비전 어드바이저 디코더와, 상호작용 표현 학습을 촉진하는 동사-HOI 예측 브리지(bridge)를 도입한다. 제안한 VLA는 SOV-STG의 성능을 크게 향상시키며, 최근 SOTA(SoTA) 모델보다 학습 에포크 수의 1/6만으로도 SOTA 성능을 달성한다. 코드와 모델은 https://github.com/cjw2021/SOV-STG-VLA 에서 공개되어 있다.