3달 전

메이크-애니메이션: 대규모 텍스트 조건부 3D 인간 운동 생성

Samaneh Azadi, Akbar Shah, Thomas Hayes, Devi Parikh, Sonal Gupta

초록

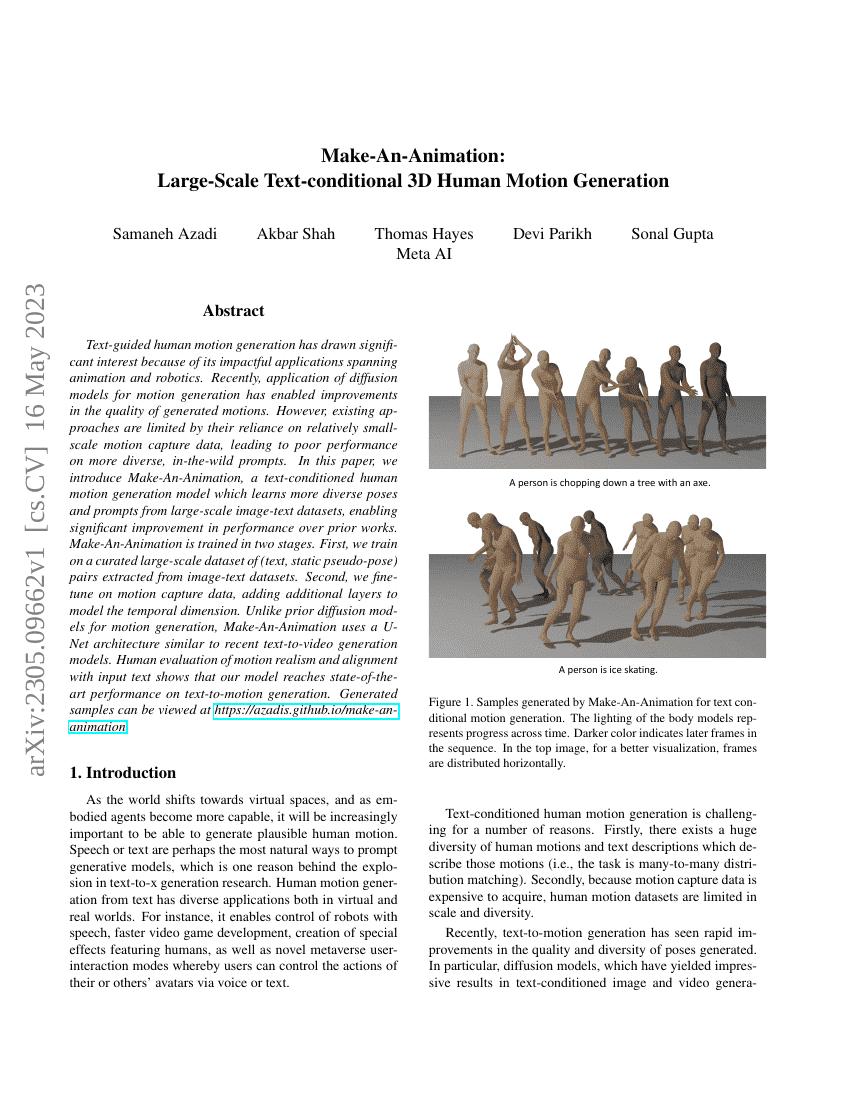

텍스트 지도형 인간 동작 생성은 애니메이션 및 로봇 공학 등 다양한 분야에서의 응용 가능성으로 인해 주목받고 있다. 최근, 동작 생성에 확산 모델(diffusion model)을 적용한 연구들이 동작 품질의 향상을 가능하게 하였다. 그러나 기존 방법들은 비교적 규모가 작은 모션 캡처 데이터에 의존함으로써, 더 다양한 실내외 환경의 프롬프트에 대해 성능이 떨어지는 한계를 가지고 있다. 본 논문에서는 대규모 이미지-텍스트 데이터셋에서 추출한 다양한 자세와 프롬프트를 학습함으로써, 기존 기법에 비해 훨씬 우수한 성능을 달성하는 텍스트 조건부 인간 동작 생성 모델인 Make-An-Animation을 제안한다. Make-An-Animation은 두 단계에 걸쳐 학습된다. 첫 번째 단계에서는 이미지-텍스트 데이터셋에서 추출한 (텍스트, 정적 가상 자세) 쌍으로 구성된 체계화된 대규모 데이터셋을 기반으로 학습한다. 두 번째 단계에서는 모션 캡처 데이터를 사용하여 시간 차원을 모델링할 수 있도록 추가적인 레이어를 적용해 세부 조정(fine-tuning)을 수행한다. 기존의 동작 생성을 위한 확산 모델과 달리, Make-An-Animation은 최근의 텍스트-비디오 생성 모델들과 유사한 U-Net 아키텍처를 사용한다. 인간 평가를 통해 동작의 사실성과 입력 텍스트와의 일치도를 검증한 결과, 본 모델은 텍스트-동작 생성 분야에서 최신 기준(SOTA, state-of-the-art) 수준의 성능을 달성함을 입증하였다.