텍스트-이미지 확산 모델을 활용한 시각 인지 기능의 해방

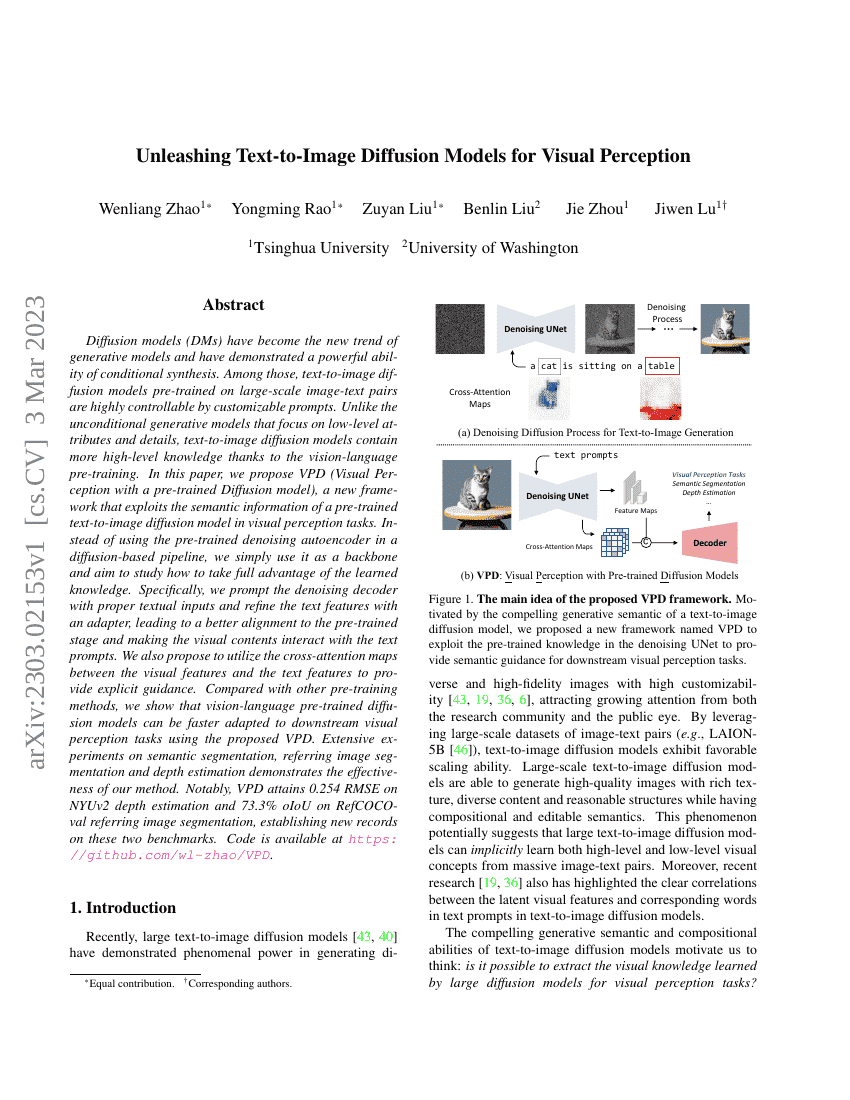

확산 모델(Diffusion Models, DMs)은 생성 모델의 새로운 트렌드로 부상하며 조건부 합성 능력에서 강력한 성능을 보여주고 있다. 특히 대규모 이미지-텍스트 쌍으로 사전 훈련된 텍스트-이미지 확산 모델은 사용자 정의 프롬프트를 통해 높은 제어력을 갖추고 있다. 무조건적 생성 모델이 저수준 속성과 세부 사항에 집중하는 반면, 텍스트-이미지 확산 모델은 시각-언어 사전 훈련을 통해 보다 고수준의 지식을 내포하고 있다. 본 논문에서는 사전 훈련된 텍스트-이미지 확산 모델의 의미 정보를 시각 인지 작업에 활용하는 새로운 프레임워크인 VPD(Visual Perception with a pre-trained Diffusion model)를 제안한다. 확산 기반 파이프라인에서 사용되는 사전 훈련된 노이즈 제거 오토인코더를 그대로 사용하는 대신, 이를 기반 구조(backbone)로 활용하고, 학습된 지식을 최대한 활용할 수 있는 방법을 탐구한다. 구체적으로, 적절한 텍스트 입력을 노이즈 제거 디코더에 프롬프트로 제공하고, 어댑터를 통해 텍스트 특징을 보정함으로써 사전 훈련 단계와의 정렬을 개선하며, 시각적 콘텐츠와 텍스트 프롬프트 간의 상호작용을 강화한다. 또한, 시각적 특징과 텍스트 특징 간의 크로스 어텐션 맵을 활용하여 명시적인 안내를 제공하는 방안을 제안한다. 다른 사전 훈련 방법과 비교하여, 제안하는 VPD를 통해 시각-언어 사전 훈련된 확산 모델이 하류 시각 인지 작업에 더 빠르게 적응할 수 있음을 입증한다. 세분화, 참조 이미지 세분화, 깊이 추정 등 다양한 실험을 통해 제안 방법의 효과성을 입증하였으며, 특히 NYUv2 깊이 추정에서 0.254의 RMSE, RefCOCO-val 참조 이미지 세분화에서 73.3%의 oIoU를 달성하여 각각의 벤치마크에서 새로운 기록을 수립하였다. 코드는 https://github.com/wl-zhao/VPD 에 공개되어 있다.