3달 전

SgVA-CLIP: 소수 샘플 이미지 분류를 위한 의미 지도형 시각 적응 시각-언어 모델

Fang Peng, Xiaoshan Yang, Linhui Xiao, Yaowei Wang, Changsheng Xu

초록

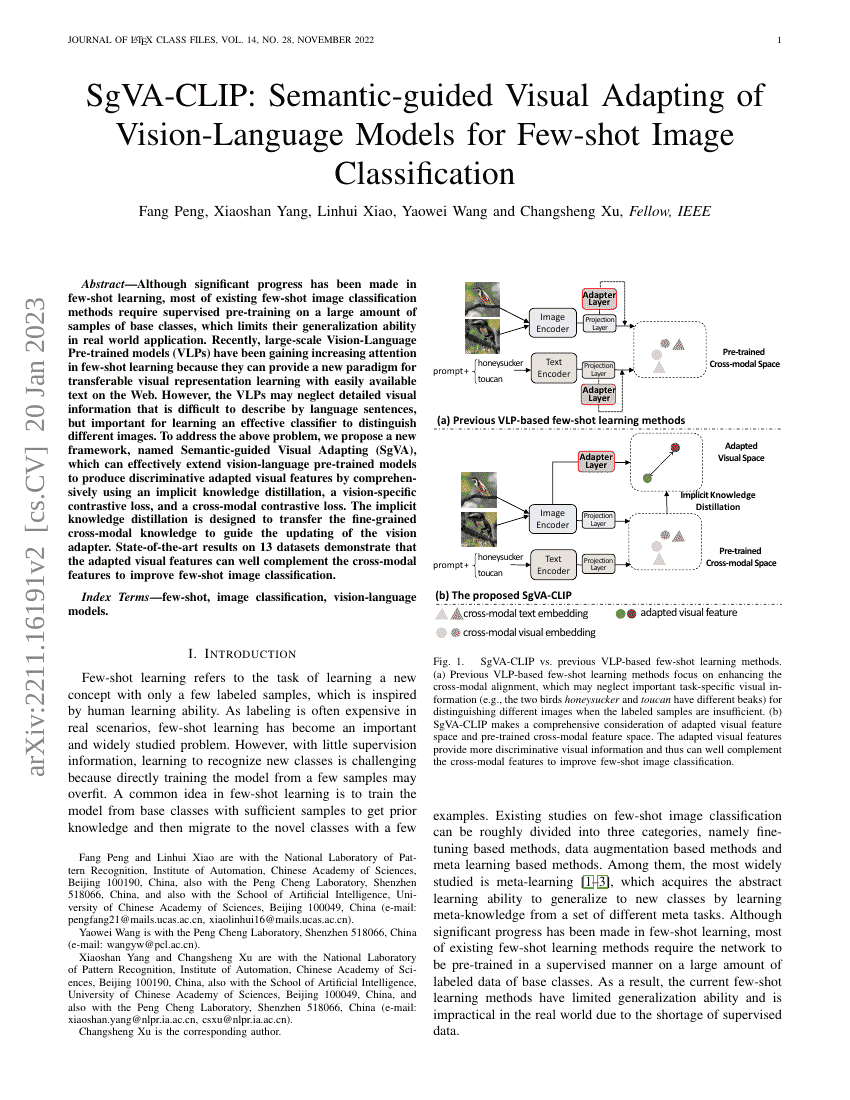

소수 샘플 학습 분야에서 상당한 진전이 이루어졌음에도 불구하고, 기존의 대부분의 소수 샘플 이미지 분류 방법은 베이스 클래스의 방대한 양의 샘플을 기반으로 한 감독식 사전 학습을 필요로 하여, 실제 응용 환경에서의 일반화 능력에 한계가 있다. 최근 대규모 시각-언어 사전 학습 모델(Vision-Language Pre-trained models, VLPs)은 웹에서 쉽게 확보할 수 있는 텍스트 정보를 활용하여 이식 가능한 시각 표현 학습의 새로운 패러다임을 제공할 수 있다는 점에서 소수 샘플 학습 분야에서 점점 더 주목받고 있다. 그러나 VLPs는 언어 문장으로 설명하기 어려우나 이미지 간 구분에 있어 중요한 세부 시각 정보를 간과할 수 있다는 문제점이 있다. 이러한 문제를 해결하기 위해, 본 연구에서는 암묵적 지식 전이, 시각 특화형 대조 손실, 다모달 대조 손실을 종합적으로 활용하여 시각-언어 사전 학습 모델을 효과적으로 확장하여 구분력 있는 적응형 시각 특징을 생성할 수 있는 새로운 프레임워크인 의미 지도형 시각 적응(Semantic-guided Visual Adapting, SgVA)을 제안한다. 암묵적 지식 전이는 세부적인 다모달 지식을 시각 어댑터의 업데이트를 안내하는 데 활용하도록 설계되었다. 13개 데이터셋에서의 최신 기술 성능 평가 결과에 따르면, 적응형 시각 특징은 다모달 특징과 잘 보완되어 소수 샘플 이미지 분류 성능을 향상시킴을 입증하였다.