초록

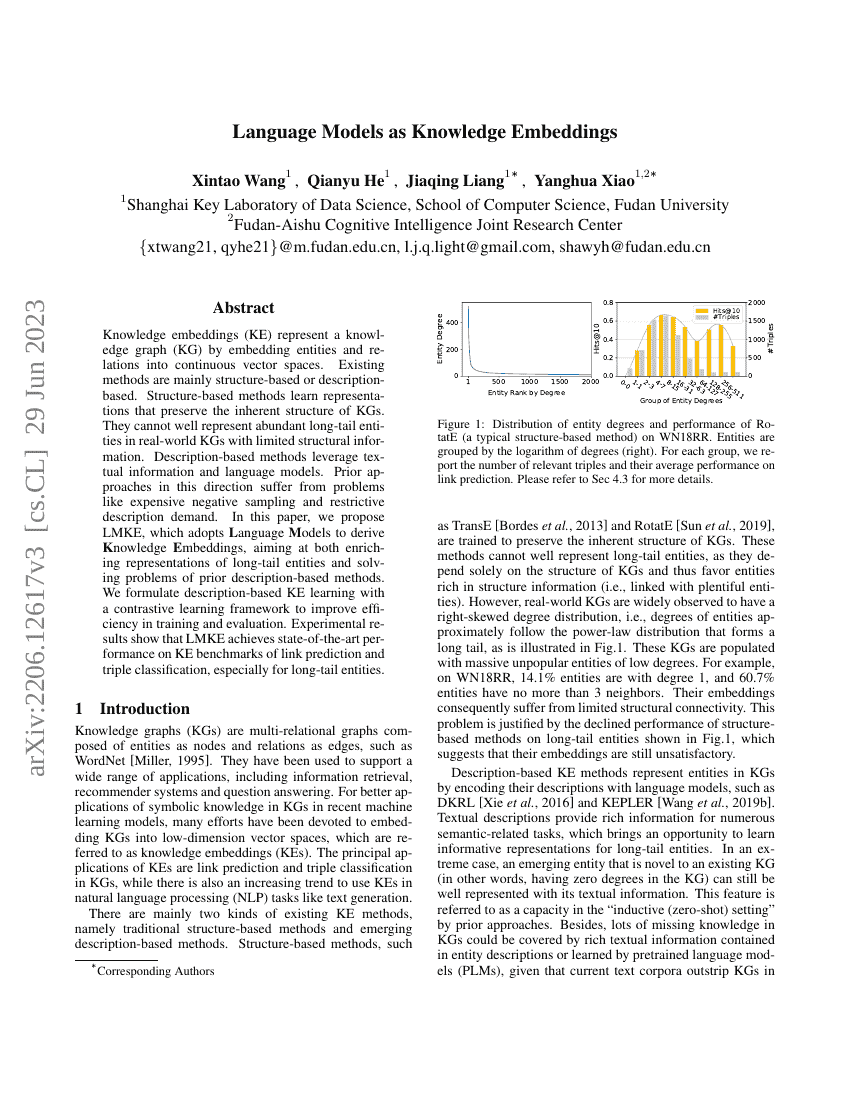

지식 임베딩(Knowledge Embeddings, KE)은 지식 그래프(Knowledge Graph, KG)의 엔티티와 관계를 연속 벡터 공간에 임베딩하여 표현하는 기법입니다. 기존 방법들은 주로 구조 기반 또는 설명 기반으로 나뉩니다. 구조 기반 방법은 KG의 고유한 구조를 보존하는 표현을 학습합니다. 그러나 이러한 방법들은 실제 세계의 KG에서 제한된 구조 정보만을 가진 풍부한 장미 꼬리 엔티티(long-tail entities)를 잘 표현하지 못합니다. 설명 기반 방법은 텍스트 정보와 언어 모델을 활용합니다. 이 방향으로 이루어진 이전 접근법들은 구조 기반 방법보다 거의 우수하지 않았으며, 비용이 많이 드는 부정 샘플링과 제한적인 설명 요구 등의 문제를 겪었습니다.본 논문에서는 언어 모델을 사용하여 지식 임베딩을 도출하는 LMKE(Language Model-based Knowledge Embeddings)를 제안합니다. 이는 장미 꼬리 엔티티의 표현을 풍부하게 하고, 이전 설명 기반 방법들의 문제를 해결하기 위한 목표를 가지고 있습니다. 우리는 대조 학습(contrastive learning) 프레임워크를 사용하여 설명 기반 KE 학습을 공식화하여 학습 및 평가 효율성을 개선하였습니다. 실험 결과, LMKE는 링크 예측과 트리플 분류의 KE 벤치마크에서 최신 성능을 달성하였으며, 특히 장미 꼬리 엔티티에 대해 뛰어난 성능을 보였습니다.