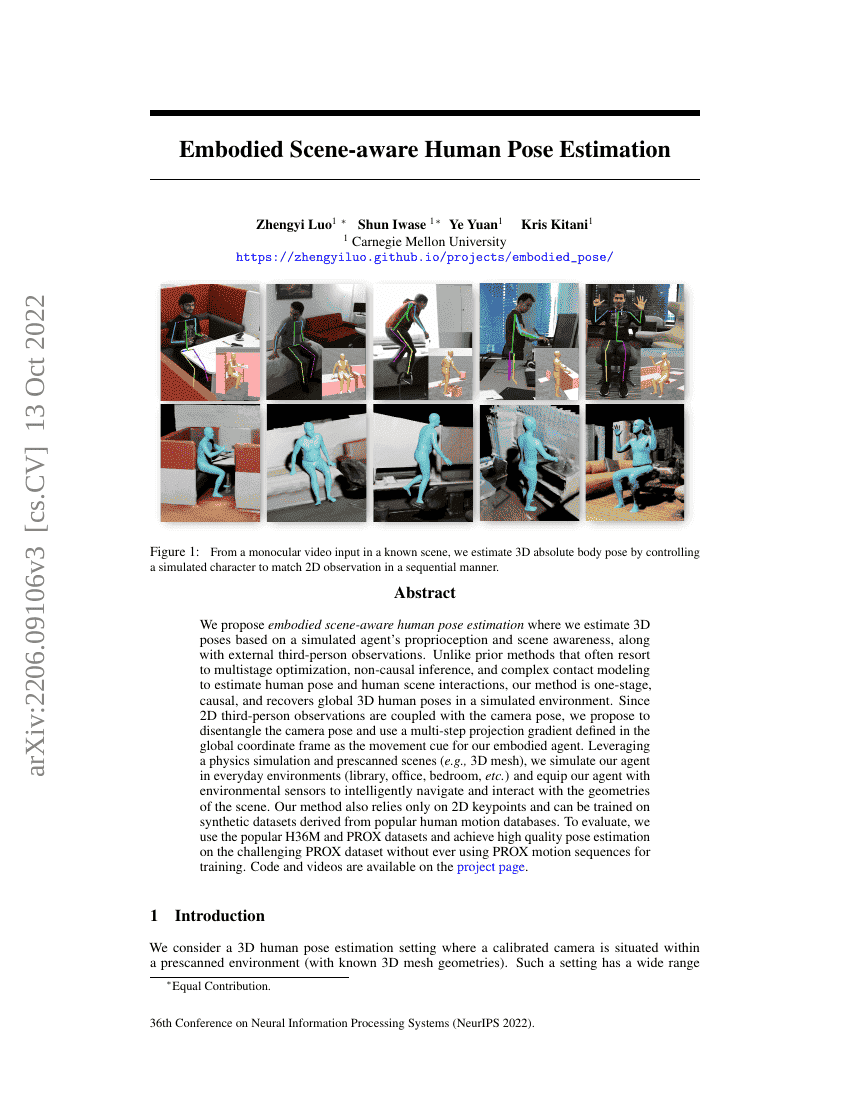

우리는 시뮬레이션된 에이전트의 본체 감각(프로피오셉션)과 장면 인지 능력, 그리고 외부의 제3자 시점 관측을 기반으로 3D 자세를 추정하는 ' embodiment된 장면 인지형 인간 자세 추정(embodied scene-aware human pose estimation)'을 제안한다. 기존의 방법들이 인간 자세와 인간-장면 상호작용을 추정하기 위해 다단계 최적화, 비인과적 추론, 복잡한 접촉 모델링에 의존하는 반면, 우리의 방법은 단일 단계(staged)이며 인과적(causal)이며, 시뮬레이션 환경 내에서 전역적인 3D 인간 자세를 복원할 수 있다. 2D 제3자 시점 관측은 카메라 자세와 결합되어 있기 때문에, 카메라 자세를 분리하고 전역 좌표계에서 정의된 다단계 투영 기울기(projection gradient)를 에이전트의 움직임 단서로 사용하는 방법을 제안한다. 물리 기반 시뮬레이션과 사전 스캔된 장면(예: 3D 메시)을 활용하여 일상 환경(도서관, 사무실, 침실 등)에서 에이전트를 시뮬레이션하고, 환경 센서를 장착하여 장면의 기하학적 구조를 지능적으로 탐색하고 상호작용할 수 있도록 한다. 본 방법은 2D 키포인트만을 사용하며, 인기 있는 인간 운동 데이터베이스에서 유도된 합성 데이터셋을 통해 학습할 수 있다. 평가를 위해 일반적으로 사용되는 H36M 및 PROX 데이터셋을 활용하여, PROX 운동 시퀀스를 학습에 전혀 사용하지 않고도 도전적인 PROX 데이터셋에서 높은 품질의 자세 추정 성능을 달성하였다. 코드와 영상은 프로젝트 페이지에서 확인할 수 있다.