3달 전

BEVFusion: 통합 Birds-Eye View 표현을 통한 다중 작업 다중 센서 융합

Zhijian Liu, Haotian Tang, Alexander Amini, Xinyu Yang, Huizi Mao, Daniela Rus, Song Han

초록

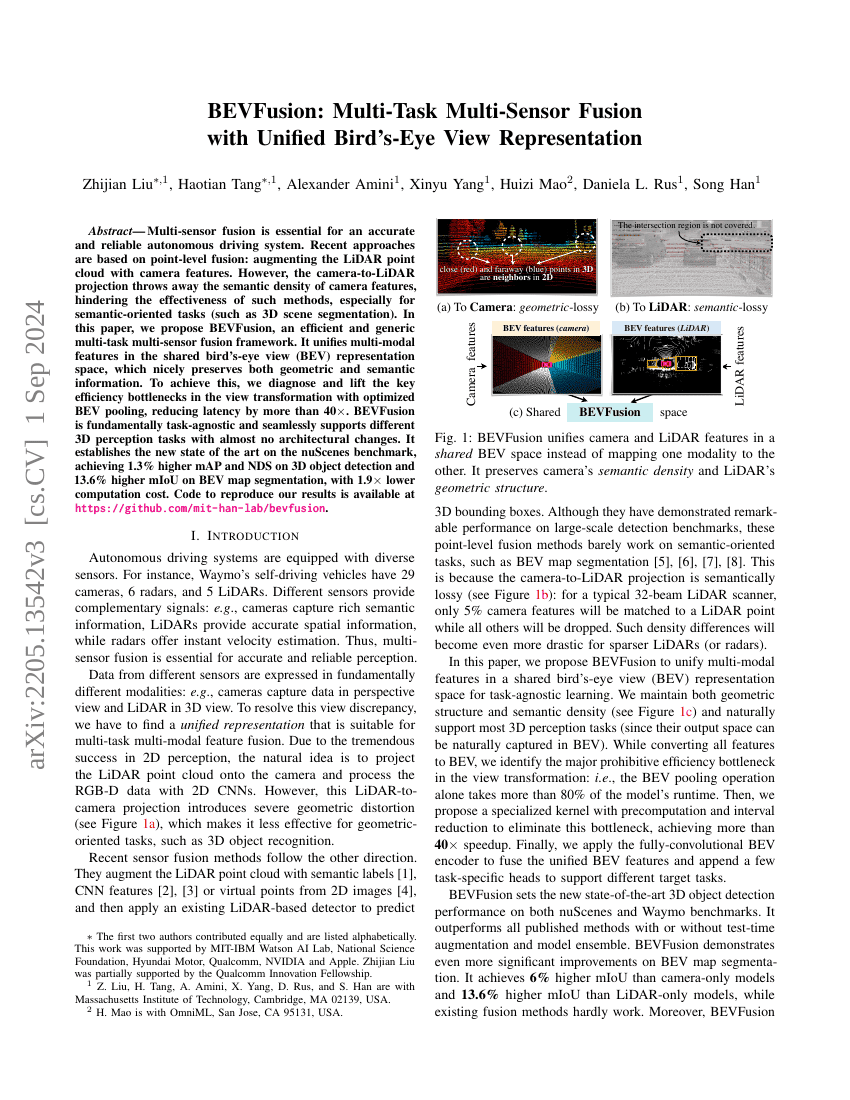

다중 센서 융합은 정확하고 신뢰할 수 있는 자율주행 시스템을 구현하는 데 필수적이다. 최근의 접근 방식은 점 수준의 융합에 기반하고 있다: 카메라 특징을 LiDAR 포인트 클라우드에 보완하는 방식이다. 그러나 카메라에서 LiDAR로의 투영 과정은 카메라 특징의 의미론적 밀도를 손실하게 되어, 특히 의미론적 작업(예: 3차원 장면 분할)에 있어서 이러한 방법의 효과를 제한한다. 본 논문에서는 BEVFusion이라는 효율적이고 일반적인 다중 작업 다중 센서 융합 프레임워크를 제안함으로써 이러한 오랜 관행을 탈피한다. BEVFusion은 공유된 벌새 시점(Bird's-Eye View, BEV) 표현 공간에서 다중 모달 특징을 통합하여 기하학적 정보와 의미론적 정보를 모두 효과적으로 보존한다. 이를 실현하기 위해, 최적화된 BEV 풀링을 통해 시점 변환 과정의 핵심 효율성 저하 요인을 진단하고 개선하여 지연 시간을 40배 이상 감소시켰다. BEVFusion은 본질적으로 작업에 독립적이며, 거의 아키텍처적 변경 없이 다양한 3차원 인식 작업을 원활하게 지원할 수 있다. nuScenes 데이터셋에서 새로운 최고 성능을 달성하며, 3차원 객체 탐지에서 mAP와 NDS가 각각 1.3% 향상되었고, BEV 맵 분할에서는 mIoU가 13.6% 향상되었으며, 계산 비용은 1.9배 감소하였다. 본 연구 결과를 재현할 수 있는 코드는 https://github.com/mit-han-lab/bevfusion 에서 제공된다.