3달 전

Relphormer: 지식 그래프 표현을 위한 관계형 그래프 트랜스포머

Zhen Bi, Siyuan Cheng, Jing Chen, Xiaozhuan Liang, Feiyu Xiong, Ningyu Zhang

초록

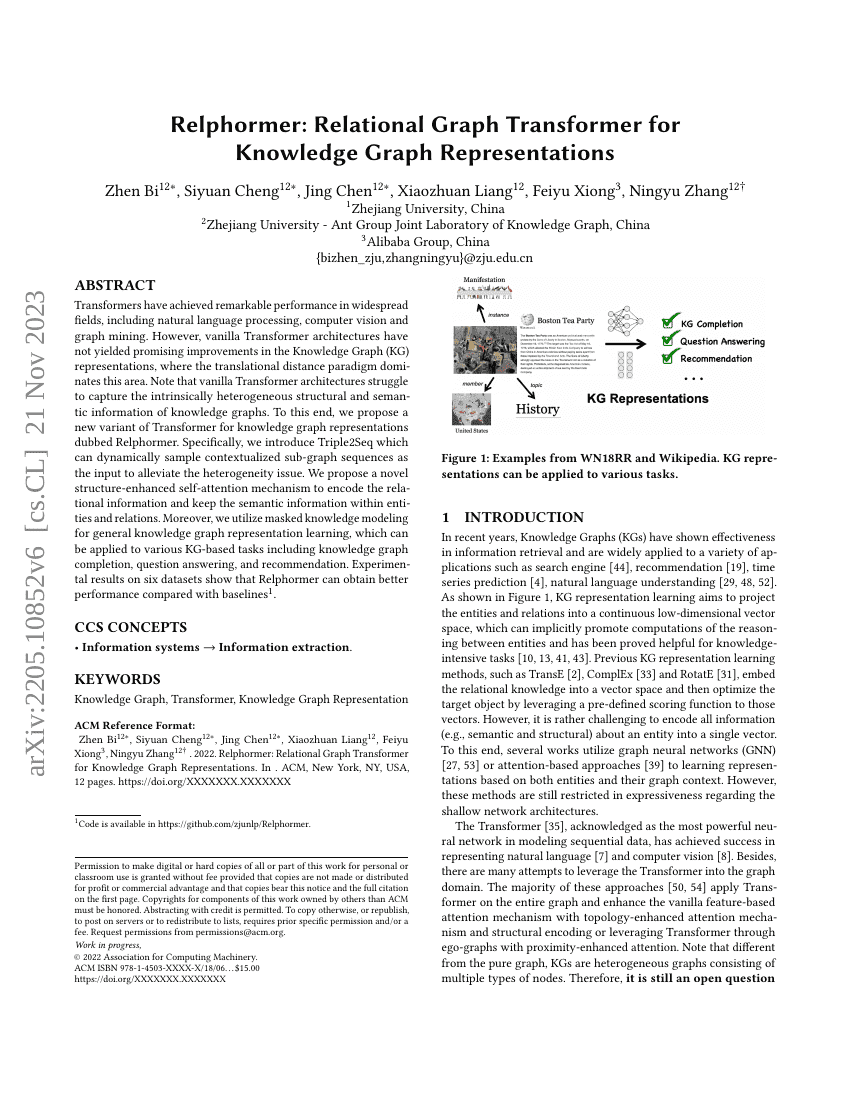

Transformers는 자연어 처리, 컴퓨터 비전, 그래프 마이닝 등 광범위한 분야에서 뛰어난 성능을 달성해왔다. 그러나 기존의 Vanilla Transformer 아키텍처는 지식 그래프(KG) 표현 학습 분야에서는 유의미한 성능 향상을 이루지 못하고 있으며, 이 분야에서는 주로 이동 거리(paradigm) 기반의 접근 방식이 지배적이다. 특히, 기존 Transformer 아키텍처는 지식 그래프가 내재적으로 지닌 다형성 있는 구조적 정보와 의미적 정보를 효과적으로 포착하는 데 어려움을 겪는다. 이를 해결하기 위해 우리는 지식 그래프 표현을 위한 새로운 Transformer 변형 모델인 Relphormer를 제안한다. 구체적으로, 맥락 기반의 하위 그래프 시퀀스를 동적으로 샘플링할 수 있는 Triple2Seq를 도입하여 지식 그래프의 다형성 문제를 완화한다. 또한 관계 정보를 효과적으로 인코딩하고 엔티티 및 관계 내의 의미 정보를 유지하기 위해 새로운 구조 강화형 자기주의(self-attention) 메커니즘을 제안한다. 더불어, 다양한 지식 그래프 기반 작업(지식 그래프 완성, 질의 응답, 추천 등)에 적용 가능한 마스킹된 지식 모델링을 활용하여 일반적인 지식 그래프 표현 학습을 수행한다. 여섯 개의 데이터셋에 대한 실험 결과, Relphormer는 기존의 베이스라인 모델들에 비해 우수한 성능을 보였다. 코드는 https://github.com/zjunlp/Relphormer 에서 공개되어 있다.