컨텍스트 오토인코더를 활용한 자기지도 학습을 위한 표현 학습

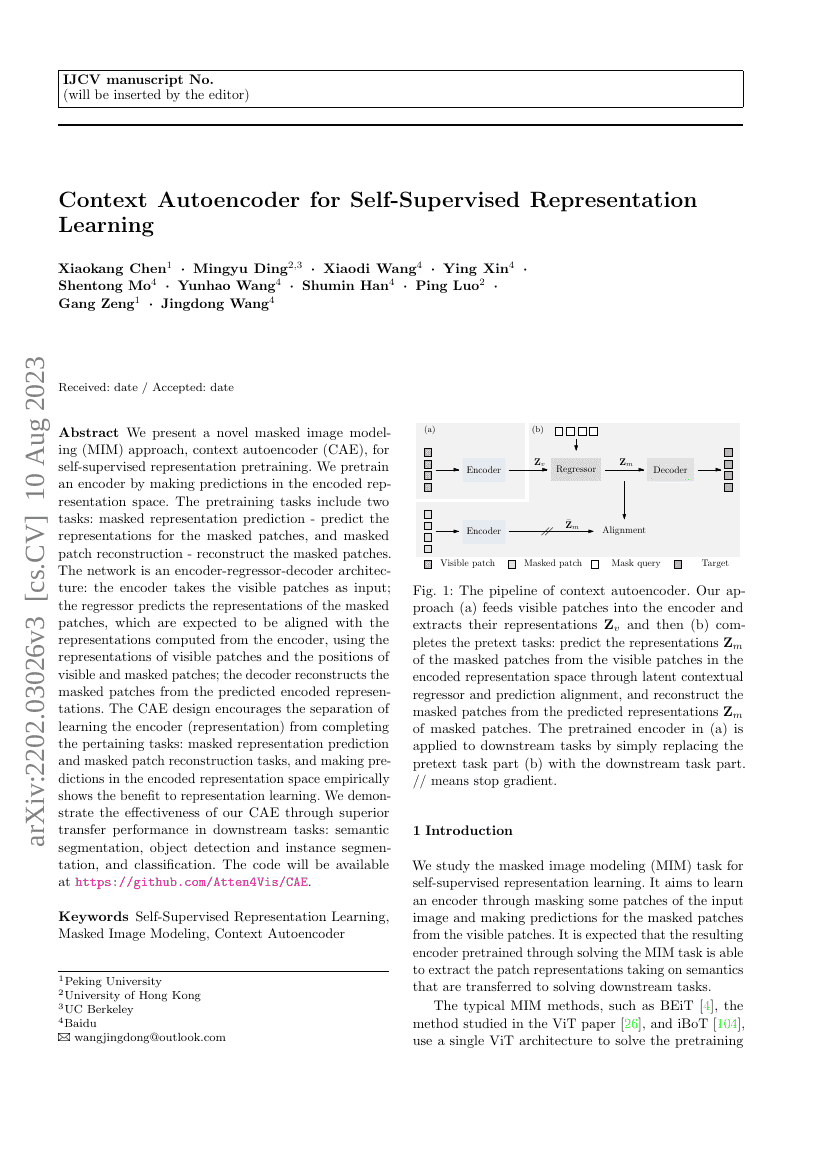

우리는 자기지도 학습을 위한 표현 사전 훈련을 위해 새로운 마스킹 이미지 모델링(MIM, Masked Image Modeling) 방법인 컨텍스트 오토인코더(Context Autoencoder, CAE)를 제안한다. 본 방법은 인코더를 인코딩된 표현 공간에서의 예측을 통해 사전 훈련한다. 사전 훈련 과제는 두 가지로 구성된다: 마스킹된 표현 예측(Masked Representation Prediction) – 마스킹된 패치들의 표현을 예측하는 작업과, 마스킹된 패치 재구성(Masked Patch Reconstruction) – 마스킹된 패치를 재구성하는 작업이다. 제안하는 네트워크는 인코더-리그레서-디코더 아키텍처로 구성되어 있다. 인코더는 가시 패치를 입력으로 받으며, 리그레서는 가시 패치의 표현과 가시 및 마스킹된 패치의 위치 정보를 활용하여 마스킹된 패치의 표현을 예측한다. 이 예측된 표현은 인코더에 의해 계산된 표현과 일치할 것으로 기대된다. 이후 디코더는 예측된 인코딩된 표현을 기반으로 마스킹된 패치를 재구성한다. CAE의 설계는 인코더(표현) 학습과 마스킹된 표현 예측 및 마스킹된 패치 재구성과 같은 특정 과제 수행을 분리하도록 유도한다. 실제로 인코딩된 표현 공간에서의 예측을 수행하는 것은 표현 학습에 긍정적인 영향을 미친다는 것이 실험적으로 입증되었다. 제안한 CAE의 효과는 하류 작업에서 뛰어난 전이 성능을 통해 입증되었다. 구체적으로는 세분류(semantic segmentation), 물체 탐지(object detection), 인스턴스 세분류(instance segmentation), 분류(classification) 등의 작업에서 우수한 성능을 보였다. 코드는 https://github.com/Atten4Vis/CAE 에 공개될 예정이다.