로윈 트랜스포머: 대규모 윈도우 어텐션을 통한 다중 스케일 표현을 이용한 세그멘테이션 트랜스포머 개선

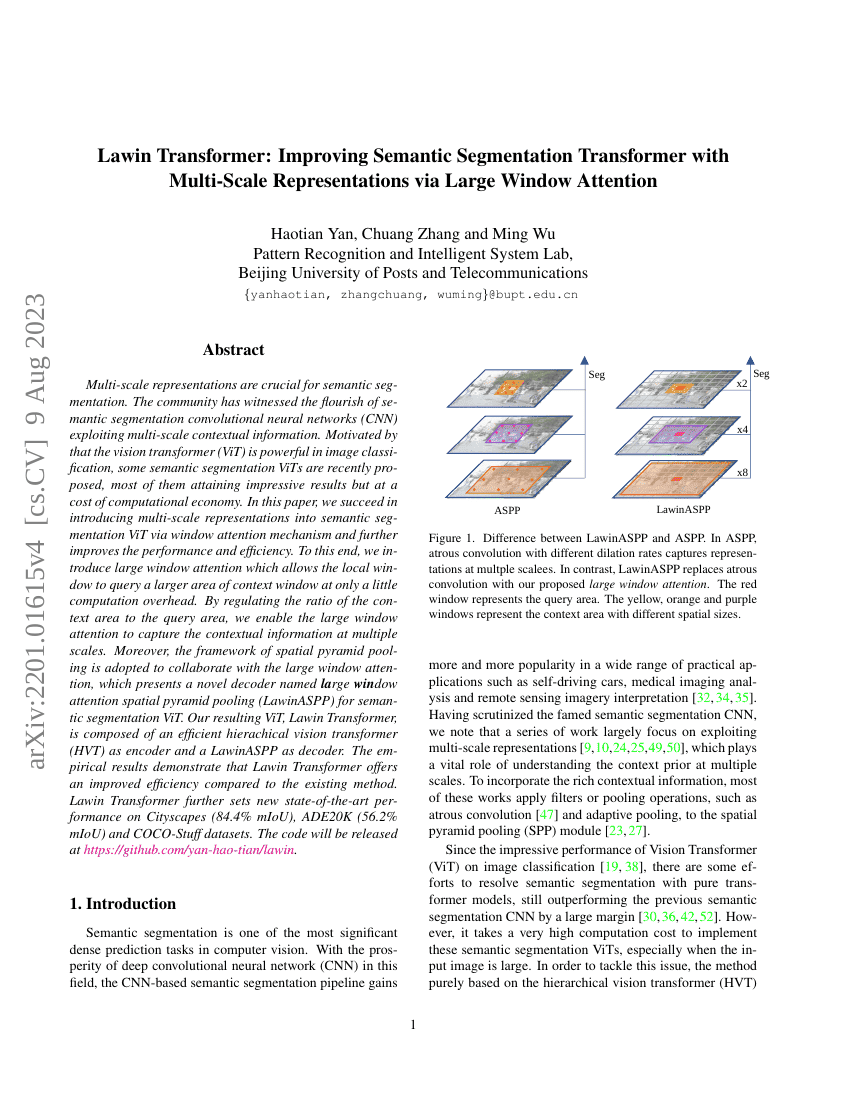

다중 규모 표현은 의미 분할(semantic segmentation)에 있어 핵심적인 요소이다. 다중 규모의 문맥 정보를 활용하는 의미 분할 컨볼루션 신경망(CNN)의 발전은 최근 기술적 혁신을 이끌어왔다. 특히, 비전 트랜스포머(ViT)가 이미지 분류에서 뛰어난 성능을 보여주고 있음에 착안하여, 최근 의미 분할을 위한 ViT 모델들이 제안되었으며, 대부분 높은 성능을 달성하고 있으나 계산 효율성 측면에서 비용이 큰 문제가 있다. 본 논문에서는 윈도우 어텐션(window attention) 기반의 기법을 통해 의미 분할을 위한 ViT에 다중 규모 표현을 성공적으로 도입하였으며, 성능과 효율성을 동시에 향상시켰다. 이를 위해, 지역 윈도우가 소규모의 쿼리 영역을 기반으로 더 큰 영역의 문맥 정보를 탐색할 수 있도록 하는 대규모 윈도우 어텐션(large window attention)을 제안한다. 이 기법은 계산 부담을 거의 증가시키지 않으면서도, 쿼리 영역과 문맥 영역의 비율을 조절함으로써 다양한 규모의 문맥 정보를 효과적으로 포착할 수 있도록 한다. 또한, 공간 피라미드 풀링(spatial pyramid pooling) 구조를 대규모 윈도우 어텐션과 결합하여, 의미 분할을 위한 새로운 디코더인 Large Window attention Spatial Pyramid Pooling (LawinASPP)을 제안한다. 본 연구에서 제안한 ViT 모델인 Lawin Transformer는 효율적인 계층적 비전 트랜스포머(HVT)를 인코더로, LawinASPP를 디코더로 구성한다. 실험 결과, 기존 방법 대비 뛰어난 계산 효율성을 보이며, Cityscapes(84.4% mIoU), ADE20K(56.2% mIoU), COCO-Stuff 데이터셋에서 각각 새로운 최고 성능을 달성하였다. 코드는 https://github.com/yan-hao-tian/lawin 에 공개될 예정이다.