3달 전

PeCo: 비전 트랜스포머의 BERT 사전 훈련을 위한 지각 코드북

Xiaoyi Dong, Jianmin Bao, Ting Zhang, Dongdong Chen, Weiming Zhang, Lu Yuan, Dong Chen, Fang Wen, Nenghai Yu, Baining Guo

초록

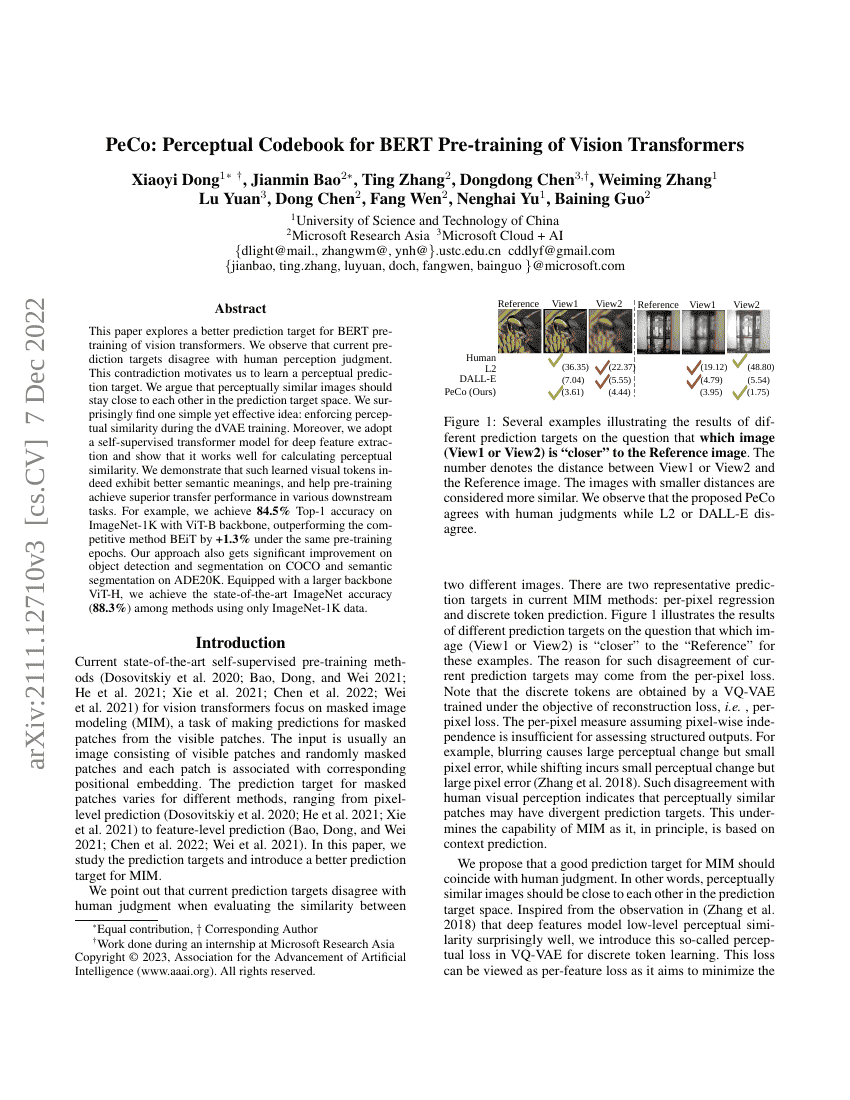

이 논문은 비전 트랜스포머(Vision Transformers)의 BERT 형식 사전 훈련을 위한 더 나은 예측 타겟을 탐구한다. 현재의 예측 타겟이 인간의 인지 판단과 일치하지 않는다는 점을 관찰함으로써, 이 모순은 인지적 예측 타겟을 학습할 필요성을 제기한다. 우리는 인지적으로 유사한 이미지들이 예측 타겟 공간 내에서 서로 가까이 위치해야 한다고 주장한다. 놀랍게도, 단순하지만 효과적인 아이디어를 발견하였다: dVAE 훈련 과정에서 인지적 유사성을 강제하는 것이다. 또한 깊은 특징 추출을 위해 자기지도 학습(self-supervised) 기반의 트랜스포머 모델을 도입하여, 인지적 유사도를 효과적으로 계산할 수 있음을 보였다. 실험을 통해 학습된 이러한 시각적 토큰이 실제로 더 풍부한 의미적 표현을 가지며, 다양한 하류 작업에서 사전 훈련의 전이 성능을 향상시킨다는 점을 입증하였다. 예를 들어, ViT-B 백본을 사용할 때 ImageNet-1K에서 Top-1 정확도 84.5%를 달성하여, 동일한 사전 훈련 에포크 수에서 경쟁 기법인 BEiT보다 +1.3% 높은 성능을 기록하였다. 또한 COCO에서 객체 탐지 및 세그멘테이션, ADE20K에서 세분화 세그멘테이션 작업에서도 상당한 성능 향상을 보였다. 더 큰 백본인 ViT-H를 사용할 경우, 단지 ImageNet-1K 데이터만을 활용한 방법 중에서 최고의 ImageNet 정확도(88.3%)를 달성하여 최신 기준을 확립하였다.