Mix3D: 3D 장면을 위한 맥락 외 데이터 증강

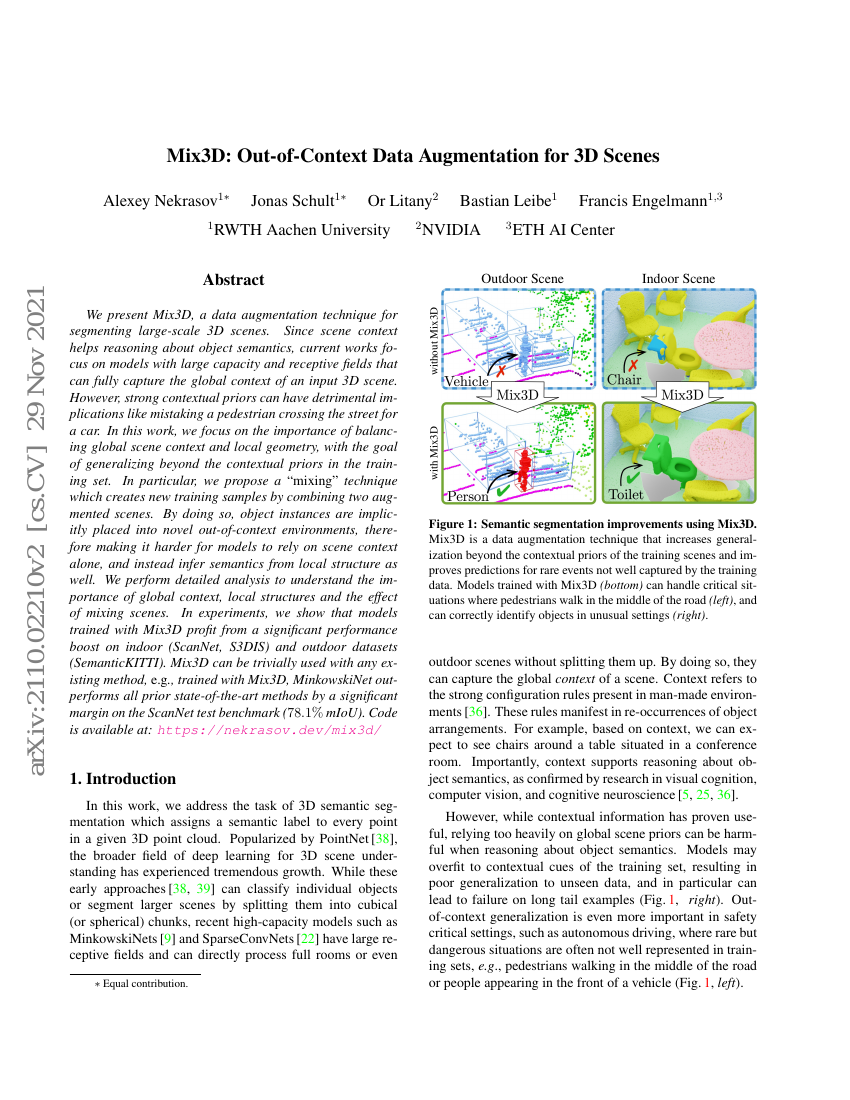

우리는 대규모 3D 장면의 세분화를 위한 데이터 증강 기법인 Mix3D를 제안한다. 장면의 맥락은 객체의 의미를 추론하는 데 도움이 되므로, 현재의 연구들은 입력 3D 장면의 전역 맥락을 완전히 포착할 수 있는 대용량 및 넓은 수용 영역을 가진 모델에 주목하고 있다. 그러나 강력한 맥락 사전 지식은 보행자가 도로를 건너는 것을 자동차로 오해하는 등의 부정적인 영향을 초래할 수 있다. 본 연구에서는 훈련 데이터셋 내 맥락 사전 지식을 넘어서 일반화할 수 있도록 전역 장면 맥락과 국부적 기하 구조 사이의 균형을 중요시한다. 특히, 두 개의 증강된 장면을 조합하여 새로운 훈련 샘플을 생성하는 '믹싱(mixing)' 기법을 제안한다. 이를 통해 객체 인스턴스는 익숙하지 않은 비맥락적 환경에 암묵적으로 배치되며, 모델이 장면 맥락에만 의존하기 어려워지고, 대신 국부적 구조를 통해 의미를 추론하도록 유도하게 된다. 본 연구에서는 전역 맥락, 국부적 구조, 그리고 장면 믹싱의 효과에 대한 심층적인 분석을 수행하였다. 실험을 통해 Mix3D를 사용해 훈련된 모델이 실내(ScanNet, S3DIS) 및 실외(SemanticKITTI) 데이터셋에서 의미 있는 성능 향상을 보임을 입증하였다. Mix3D는 기존의 어떤 방법과도 간단히 통합 가능하며, 예를 들어 Mix3D로 훈련된 MinkowskiNet은 ScanNet 테스트 벤치마크에서 78.1 mIoU로 기존 최고 성능을 크게 상회한다. 코드는 다음 링크에서 확인할 수 있다: https://nekrasov.dev/mix3d/