개체 수준의 공간-시간 패턴 학습을 통한 사람 재식별

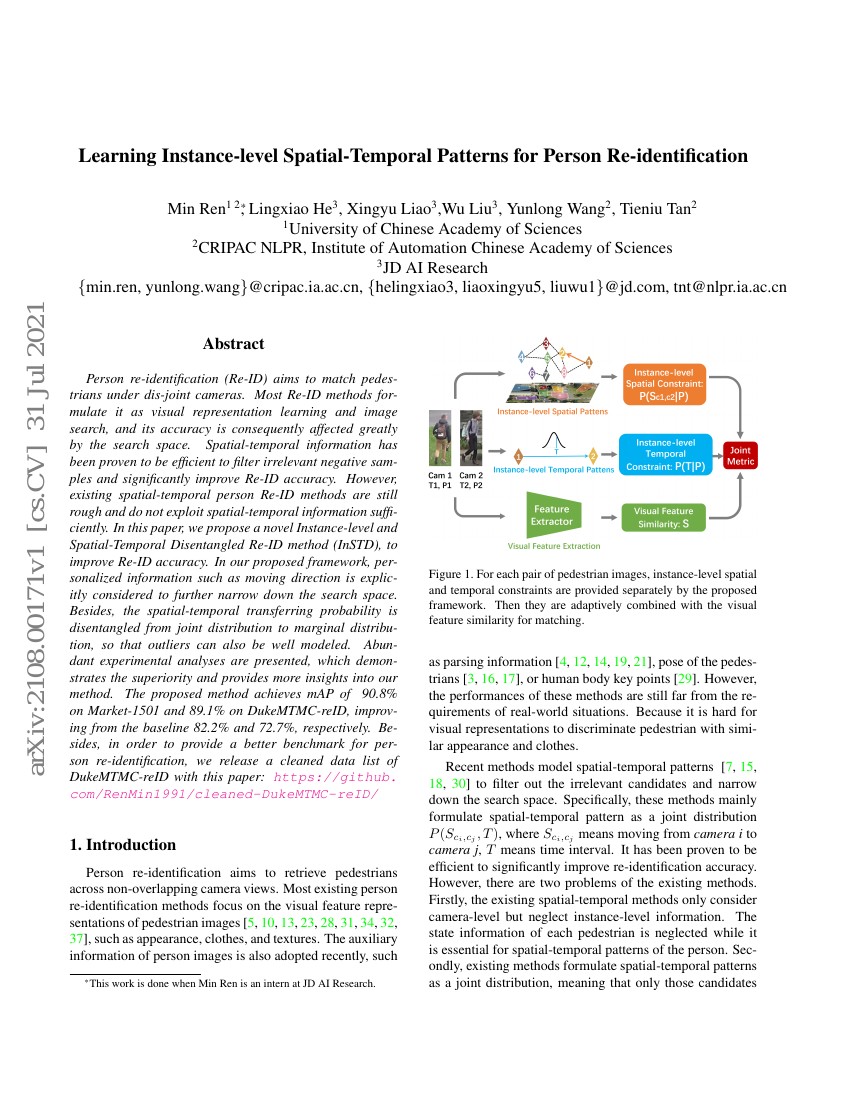

사람 재식별(Person re-identification, Re-ID)은 분리된 카메라 간의 보행자를 매칭하는 것을 목표로 한다. 대부분의 Re-ID 방법은 시각적 표현 학습과 이미지 검색 문제로 공식화하며, 이로 인해 정확도는 검색 공간의 크기에 크게 영향을 받는다. 공간-시간 정보는 관련 없는 음성 샘플을 효과적으로 필터링하고 Re-ID 정확도를 크게 향상시킬 수 있음이 입증되었다. 그러나 기존의 공간-시간 기반 사람 Re-ID 방법들은 여전히 대략적이며, 공간-시간 정보를 충분히 활용하지 못하고 있다. 본 논문에서는 사람 재식별 정확도를 향상시키기 위해 새로운 인스턴스 수준의 공간-시간 분리형 재식별 방법(InSTD: Instance-level and Spatial-Temporal Disentangled Re-ID)을 제안한다. 제안된 프레임워크에서는 이동 방향과 같은 개인화된 정보를 명시적으로 고려함으로써 검색 공간을 더욱 좁힐 수 있다. 또한, 공간-시간 전이 확률을 결합 분포에서 주변 분포로 분리하여 이상치(outlier)에 대한 모델링도 효과적으로 수행할 수 있다. 다양한 실험 분석을 통해 제안된 방법의 우수성을 입증하고, 그 메커니즘에 대한 심층적인 통찰을 제공한다. 제안된 방법은 Market-1501에서 mAP 90.8%, DukeMTMC-reID에서 89.1%의 성능을 달성하여 각각 기준 모델(Baseline)의 82.2%와 72.7%보다 향상되었다. 더불어, 사람 재식별 연구를 위한 보다 우수한 벤치마크 제공을 위해 본 논문과 함께 DukeMTMC-reID 데이터셋의 정제된 데이터 리스트를 공개한다. 자세한 내용은 다음 링크에서 확인할 수 있다: https://github.com/RenMin1991/cleaned-DukeMTMC-reID/