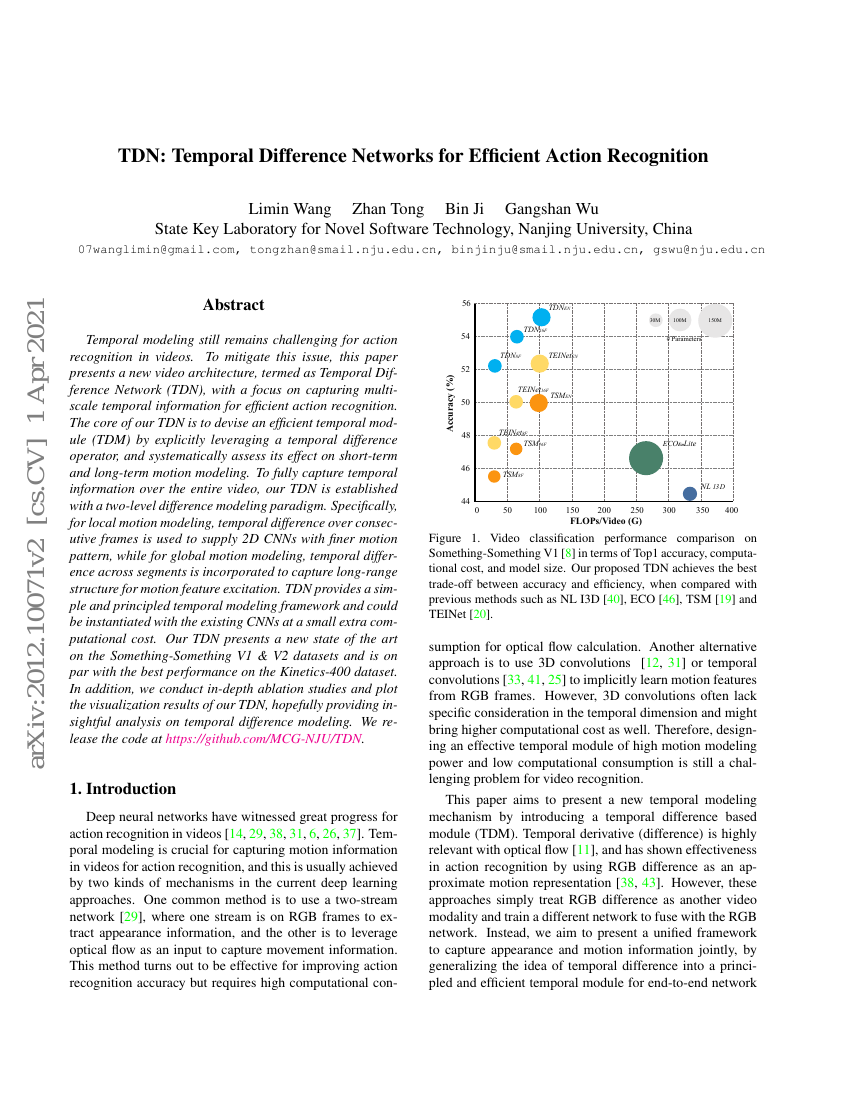

비디오에서 행동 인식에 있어 시간적 모델링은 여전히 도전 과제로 남아 있다. 이 문제를 완화하기 위해 본 논문은 효율적인 행동 인식을 위해 다중 스케일 시간 정보를 포착하는 데 중점을 둔 새로운 비디오 아키텍처인 시간 차분 네트워크(Temporal Difference Network, TDN)를 제안한다. TDN의 핵심은 시간 차분 연산자(temporal difference operator)를 명시적으로 활용하여 효율적인 시간 모듈(Temporal Difference Module, TDM)을 설계하고, 이를 통해 단기 및 장기 운동 모델링에 미치는 영향을 체계적으로 평가하는 것이다. 전체 비디오에 걸쳐 시간 정보를 충분히 포착하기 위해, TDN은 이중 수준의 차분 모델링 패러다임을 기반으로 설계되었다. 구체적으로, 국소적 운동 모델링에서는 연속 프레임 간의 시간 차분을 사용하여 2차원 CNN에 더 정교한 운동 패턴을 제공하고, 글로벌 운동 모델링에서는 세그먼트 간의 시간 차분을 도입하여 장거리 구조를 포착하고 운동 특징을 강화한다. TDN은 간단하면서도 체계적인 시간 모델링 프레임워크를 제공하며, 기존의 CNN 아키텍처에 작은 추가 계산 비용으로 쉽게 적용할 수 있다. 제안한 TDN은 Something-Something V1 및 V2 데이터셋에서 새로운 최고 성능을 달성하였으며, Kinetics-400 데이터셋에서도 최고 성능과 동등한 결과를 보였다. 또한, TDN의 성능을 깊이 있게 분석하기 위해 철저한 아블레이션 스터디를 수행하고, 시간 차분 모델링의 시각화 결과를 제시하였다. 이를 통해 시간 차분 모델링에 대한 통찰력 있는 분석을 제공하고자 한다. 코드는 https://github.com/MCG-NJU/TDN에서 공개된다.