Transformer 학습의 어려움 이해

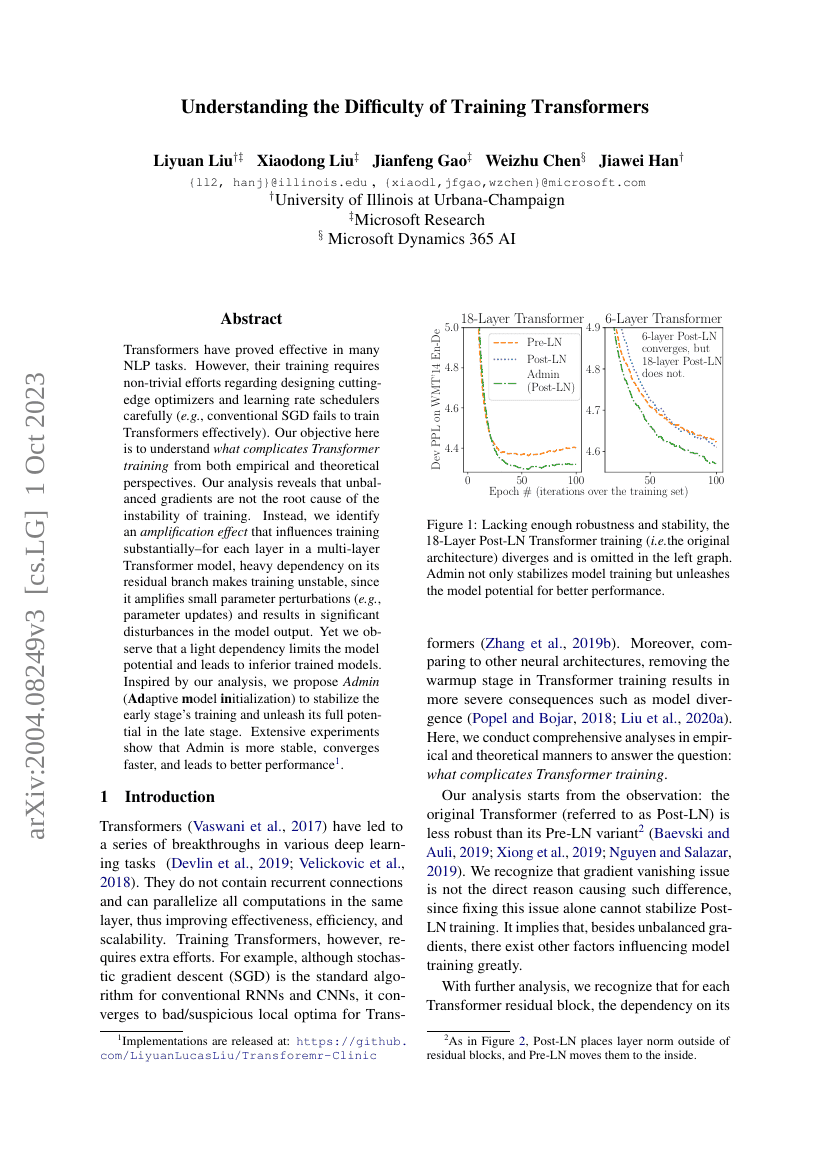

Transformers는 여러 자연어 처리(NLP) 작업에서 효과적임이 입증되었다. 그러나 Transformer 모델을 훈련시키기 위해서는 최첨단 최적화 알고리즘과 학습률 스케줄링 전략을 신중하게 설계하는 데 상당한 노력이 필요하다(예: 전통적인 SGD는 Transformer를 효과적으로 훈련시키지 못한다). 본 연구의 목적은 경험적·이론적 관점에서 ‘Transformers 훈련이 왜 복잡한가’를 이해하는 것이다. 분석 결과, 불균형한 기울기(gradient imbalance)는 훈련 불안정성의 근본 원인이 아님을 확인하였다. 대신, 훈련에 상당한 영향을 미치는 증폭 효과(amplification effect)를 발견하였다. 다층 Transformer 모델의 각 층에서, 잔차(branch)에 과도하게 의존하게 되면 훈련이 불안정해지는데, 이는 미세한 파라미터 변동(예: 파라미터 업데이트)을 증폭시켜 모델 출력에 큰 왜곡을 초래하기 때문이다. 그러나 동시에, 잔차에 대한 의존도가 너무 낮을 경우 모델의 잠재력이 제한되며, 결과적으로 성능이 떨어지는 모델이 얻어진다. 이러한 분석을 바탕으로, 초기 훈련 단계에서는 안정성을 높이고, 후기 단계에서는 모델의 전체 잠재력을 발휘할 수 있도록 하는 새로운 방법인 Admin(Adaptive Model Initialization)을 제안한다. 광범위한 실험 결과, Admin은 더 안정적이며 빠르게 수렴하고, 최종 성능도 우수함을 입증하였다. 관련 구현 코드는 다음 링크에서 공개되었다: https://github.com/LiyuanLucasLiu/Transforemr-Clinic.