자율주행 응용을 위한 계층적 자기지도 학습 단안 절대 깊이 추정 방향

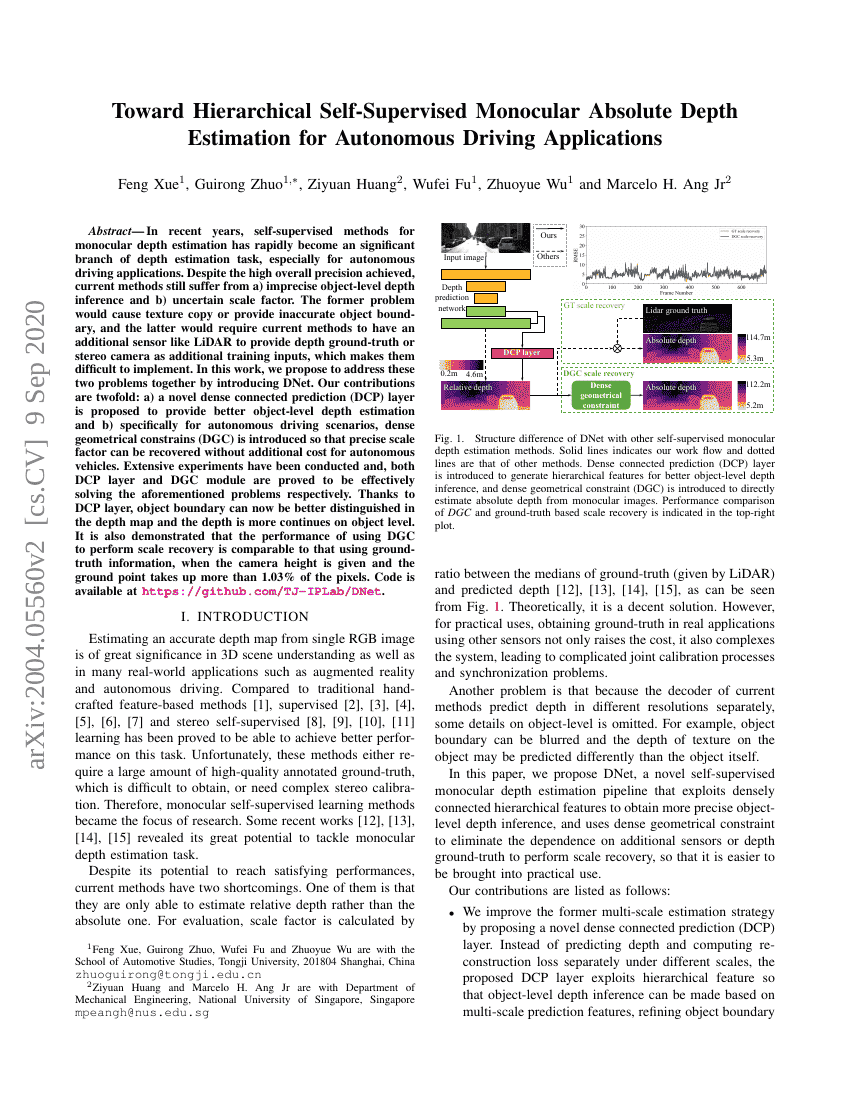

최근 몇 년간 단안(depth) 추정을 위한 자기지도 학습(self-supervised) 방법은 깊이 추정 작업의 중요한 분야로 급성장하고 있으며, 특히 자율주행 응용 분야에서 두드러진 성과를 보이고 있다. 현재의 방법들은 전반적인 정확도는 높게 달성하고 있으나, a) 객체 수준의 깊이 추정이 부정확하고, b) 스케일 인자(scale factor)가 불확실하다는 두 가지 문제를 여전히 겪고 있다. 첫 번째 문제는 텍스처 복사(texture copy) 현상을 유발하거나 객체 경계를 정확히 표현하지 못하게 하며, 두 번째 문제는 현재의 방법들이 깊이 지표(ground-truth)를 제공하기 위해 추가 센서(LiDAR)를 사용하거나, 스테레오 카메라를 추가 학습 입력으로 활용해야 한다는 점에서 구현이 어려워진다. 본 연구에서는 이러한 두 가지 문제를 동시에 해결하기 위해 DNet을 제안한다. 본 연구의 기여는 두 가지이다. a) 객체 수준의 깊이 추정을 향상시키기 위해 새로운 밀집 연결 예측(Dense Connected Prediction, DCP) 레이어를 제안하였으며, b) 자율주행 환경에 특화하여 밀집 기하학적 제약(Dense Geometrical Constraints, DGC)를 도입함으로써, 자율주행 차량에 추가 비용 없이 정확한 스케일 인자를 회복할 수 있도록 하였다. 광범위한 실험을 수행한 결과, DCP 레이어와 DGC 모듈이 각각 제시된 문제를 효과적으로 해결함이 입증되었다. DCP 레이어 덕분에 깊이 맵에서 객체 경계가 보다 명확하게 구분되며, 객체 수준에서 깊이 값이 더욱 연속적으로 표현된다. 또한 카메라 높이가 주어지고, 지표면 점이 전체 픽셀의 1.03% 이상을 차지할 경우, DGC를 이용한 스케일 회복 성능이 지표 정보를 사용한 경우와 유사한 수준임이 입증되었다. 코드는 https://github.com/TJ-IPLab/DNet 에 공개되어 있다.