3달 전

비디오 유도 시각 불변성의 자기지도 학습

Michael Tschannen, Josip Djolonga, Marvin Ritter, Aravindh Mahendran, Xiaohua Zhai, Neil Houlsby, Sylvain Gelly, Mario Lucic

초록

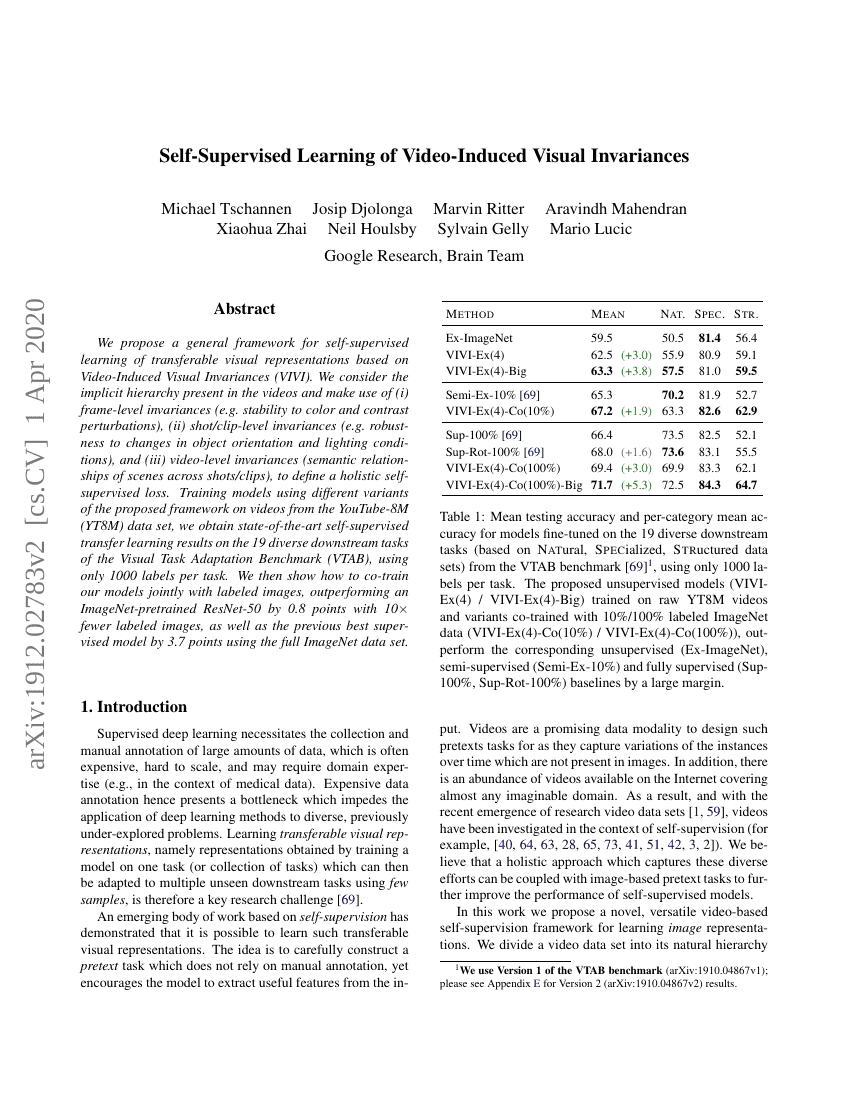

우리는 비디오 유도 시각 불변성(Video-Induced Visual Invariances, VIVI)을 기반으로 이식 가능한 시각 표현을 위한 자기지도 학습의 일반적인 프레임워크를 제안한다. 본 연구에서는 비디오 내에 내재된 계층적 구조를 고려하여, (i) 프레임 수준의 불변성(예: 색상 및 대비 변화에 대한 안정성), (ii) 샷/클립 수준의 불변성(예: 객체 방향 및 조명 조건 변화에 대한 내성), 그리고 (iii) 비디오 수준의 불변성(샷/클립 간 장면 간 의미적 관계)을 활용하여 통합적인 자기지도 학습 손실을 정의한다. 제안한 프레임워크의 다양한 변형을 YouTube-8M(YT8M) 데이터셋의 비디오를 이용해 학습시킨 결과, 시각 작업 적응 벤치마크(VTAB)의 19개 다양한 하류 작업에서 각 작업당 단지 1,000개의 레이블만을 사용하여 최신 기준의 자기지도 전이 학습 성과를 달성하였다. 또한, 레이블이 부여된 이미지와 본 모델을 함께 학습시키는 방법을 제시하며, ImageNet으로 사전 훈련된 ResNet-50보다 레이블 데이터를 10배 적게 사용했음에도 0.8점 높은 성능을 기록하였고, 전체 ImageNet 데이터셋을 사용한 이전 최고의 지도 학습 모델보다도 3.7점 높은 성능을 달성하였다.