초록

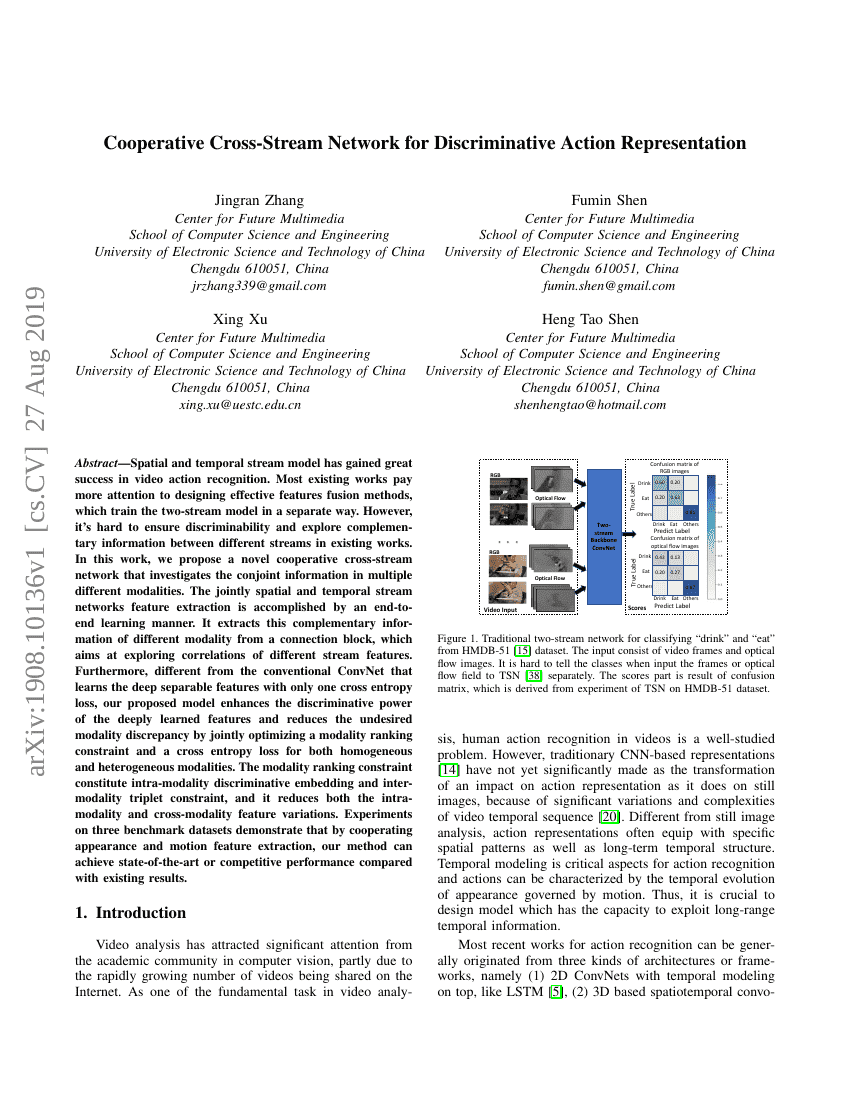

공간-시간 스트림 모델은 비디오 동작 인식 분야에서 큰 성공을 거두었습니다. 기존의 대부분 연구는 효과적인 특성 결합 방법에 더 많은 주목을 기울이며, 두 스트림 모델을 별도로 훈련시키는 방식을 채택하고 있습니다. 그러나 이러한 접근법으로는 다른 스트림 간의 차별화와 보완적 정보를 탐색하는 것이 어렵습니다. 본 연구에서는 여러 다른 모달리티에서 공동 정보를 조사하는 혁신적인 협력 크로스-스트림 네트워크를 제안합니다. 공간-시간 스트림 네트워크의 특성 추출은 엔드투엔드 학습 방식으로 이루어집니다. 이는 서로 다른 모달리티 간의 상관관계를 탐색하는 연결 블록에서 보완적 정보를 추출합니다. 또한, 기존의 컨브넷이 단일 크로스 엔트로피 손실만으로 깊게 분리된 특성을 학습하는 것과 달리, 제안된 모델은 동질적 및 이질적 모달리티 모두에 대해 모달리티 순위 제약과 크로스 엔트로피 손실을 동시에 최적화하여 깊게 학습된 특성의 차별화 능력을 강화하고 원하지 않는 모달리티 차이를 줄입니다. 모달리티 순위 제약은 동일한 모달리티 내에서의 차별적 임베딩과 서로 다른 모달리티 간의 트립렛 제약을 구성하며, 이는 동일한 모달리티 내와 서로 다른 모달리티 간의 특성 변동성을 모두 감소시킵니다. 세 가지 벤치마크 데이터셋에서 수행한 실험 결과, 외모와 운동 특성 추출을 협력적으로 수행함으로써 본 방법론은 기존 결과와 비교해 최고 수준 또는 경쟁력 있는 성능을 달성할 수 있음을 입증하였습니다.