초록

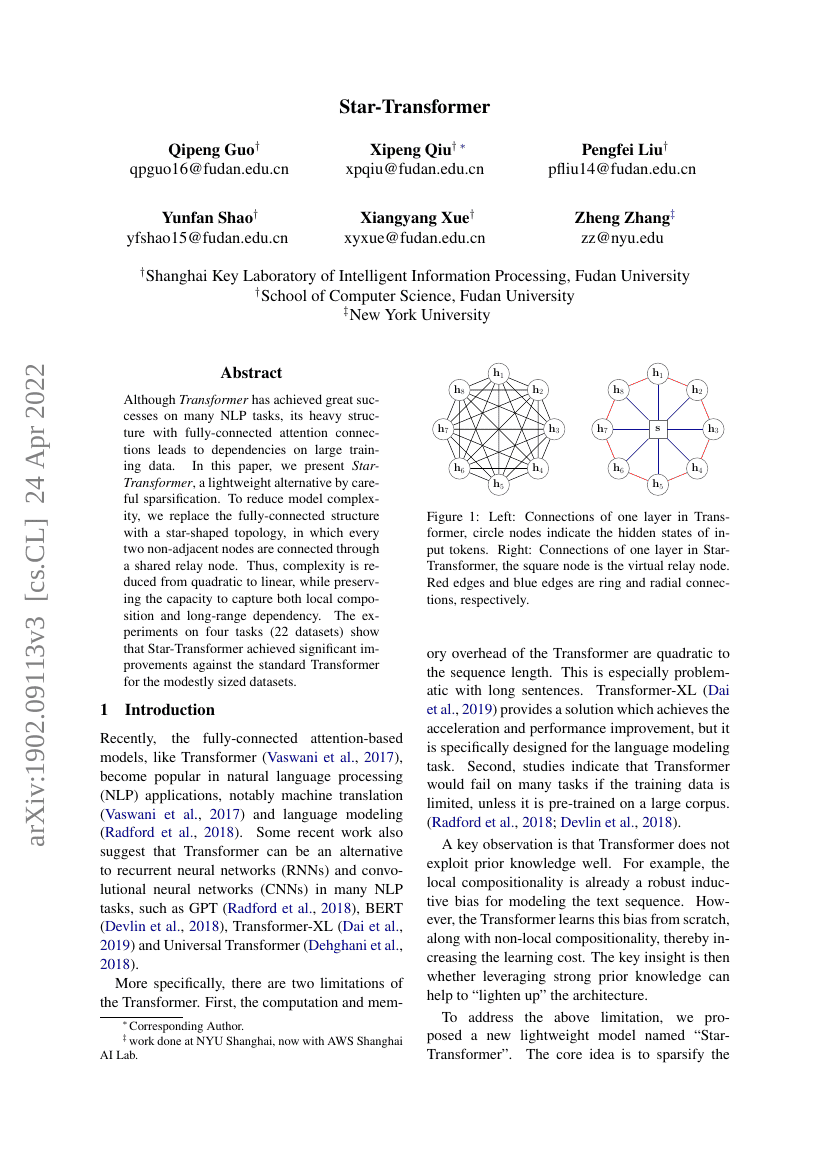

트랜스포머는 많은 자연어 처리(NLP) 작업에서 큰 성공을 거두었지만, 완전 연결된 주의 메커니즘으로 인해 복잡한 구조를 가지고 있어 대규모 학습 데이터에 의존하고 있습니다. 본 논문에서는 이러한 문제점을 해결하기 위해 신중한 희소화를 통해 제안하는 경량화된 대안인 스타 트랜스포머(Star-Transformer)를 소개합니다. 모델의 복잡성을 줄이기 위해, 완전 연결 구조를 공유 중계 노드를 통해 모든 비연속적인 두 노드가 연결되는 별 모양 위상으로 대체하였습니다. 이로 인해 복잡성이 이차적에서 선형으로 감소하였으며, 지역 구성과 장거리 의존성을 포착할 수 있는 능력은 유지되었습니다. 네 가지 작업(22개 데이터셋)에 대한 실험 결과, 스타 트랜스포머는 규모가 작은 데이터셋에서 표준 트랜스포머보다 유의미한 개선을 보였습니다.