Command Palette

Search for a command to run...

뇌-컴퓨터 인터페이스 분야의 새로운 이정표: 생각이 말하고 기계가 해석한다

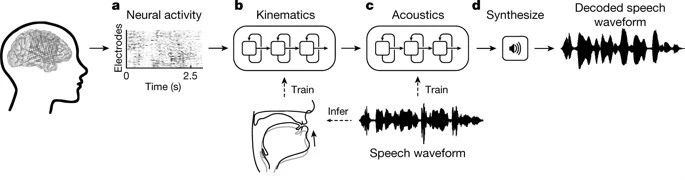

사람들이 말할 때 해당 뇌 영역의 신경 신호를 디코딩하기 위해 신경망을 사용하고, 그 다음 순환 신경망을 사용하여 신호를 음성으로 합성하면 언어 장애가 있는 환자가 언어 의사소통 문제를 해결하는 데 도움이 될 수 있습니다.

'마음 읽기'가 실제로 현실이 될 수도 있다.

대부분의 사람들에게 말하는 것은 매우 흔한 일입니다. 그러나 이 세상에는 아직도 뇌졸중, 외상성 뇌손상, 파킨슨병, 다발성경화증, 근위축성 측색경화증(ALS 또는 루게릭병) 등의 신경퇴행성 질환으로 고통받는 사람들이 많이 있으며, 이들은 종종 다음과 같은 질병을 앓습니다.말할 수 있는 능력을 돌이킬 수 없게 상실함.

과학자들은 인간의 기능을 회복하고 신경을 복구하기 위해 노력해 왔으며, 뇌-컴퓨터 인터페이스(BCI)가 그 핵심 분야입니다.

뇌-컴퓨터 인터페이스는 인간이나 동물의 뇌와 외부 장치 사이에 정보 교환을 가능하게 하기 위해 만들어진 직접적인 연결을 말합니다.

하지만 뇌-컴퓨터 인터페이스는 언제나 먼 개념이었던 것 같습니다. 오늘, 세계 최고 학술지인 네이처에 게재된 논문말한 문장의 신경 디코딩을 통한 음성 합성”(말한 문장의 신경 디코딩을 통한 음성 합성)은 뇌-컴퓨터 인터페이스 분야 연구가 큰 진전을 이루었다는 것을 보여줍니다.

언어 장애가 있는 사람들의 곤경

사실, 뇌-컴퓨터 인터페이스에 대한 연구는 40년 이상 진행되어 왔습니다. 그러나 지금까지 가장 성공적이고 임상적으로 널리 퍼진 기술은 인공 달팽이 이식과 같은 감각 회복 기술뿐입니다.

오늘날에도 언어 장애가 심각한 일부 사람들은 보조 기구를 사용해서 생각을 단어 하나하나로만 표현할 수 있습니다.

이러한 보조 장치는 매우 미묘한 눈이나 얼굴 근육의 움직임을 추적하고 환자의 몸짓에 따라 단어를 표현할 수 있습니다.

물리학자 스티븐 호킹은 한때 자신의 휠체어에 이런 장치를 설치한 적이 있습니다.

당시 호킹은 적외선으로 감지된 근육 움직임을 이용해 명령을 내리고, 컴퓨터 커서로 스캔한 문자를 확인하고, 원하는 단어를 적었습니다. 그런 다음 텍스트 음성 변환 장치를 사용하여 단어를 "말하세요". 우리가 그의 책 "시간의 간략한 역사"를 읽을 수 있는 것은 바로 이러한 검은 기술의 도움 덕분입니다.

그러나 그러한 장비로는텍스트나 합성 음성을 생성하는 일은 노력이 많이 들고, 오류가 발생하기 쉬우며, 매우 느립니다.일반적으로 1분에 최대 10단어가 허용됩니다. 당시 호킹은 이미 매우 빠른 언어력을 가지고 있었지만, 그가 철자할 수 있는 단어는 15~20개 정도뿐이었습니다. 자연스러운 말은 분당 100~150단어에 달할 수 있습니다.

게다가 이 방법은 작업자 자신의 신체 움직임 능력에 의해 크게 제한됩니다.

이러한 문제를 해결하기 위해 뇌-컴퓨터 인터페이스 분야에서는 대뇌 피질의 해당 전기 신호를 직접 해석하여 음성으로 변환하는 방법을 연구해 왔습니다.

신경망은 뇌 신호를 해석하여 음성을 합성합니다.

이제 이 어려운 문제를 해결하는 데 획기적인 진전이 있었습니다.

캘리포니아 대학교 샌프란시스코 캠퍼스의 신경외과 교수인 Edward Chang과 그의 동료들은 "말하는 문장의 신경 디코딩을 통한 음성 합성"이라는 논문에서 다음과 같이 제안했습니다.개발된 뇌-컴퓨터 인터페이스는 사람이 말할 때 생성되는 신경 신호를 디코딩하고 이를 음성으로 합성할 수 있습니다.이 시스템은 분당 150개의 단어를 생성할 수 있는데, 이는 일반적인 사람의 말하는 속도와 비슷합니다.

연구팀은 치료를 받고 있는 간질 환자 5명을 모집하여 수백 개의 문장을 큰 소리로 말하게 한 뒤 고밀도 뇌파(ECoG) 신호를 기록하고 뇌의 언어 생성 센터인 복측 감각운동 피질의 신경 활동을 추적했습니다.

사용순환 신경망(RNN)연구자들은 수집된 신경 신호를 두 단계로 디코딩했습니다.

첫째, 그들은신경 신호를 음성 기관의 움직임을 나타내는 신호로 변환합니다.턱, 목, 입술, 혀의 움직임과 관련된 뇌 신호가 포함됩니다.

두 번째 단계는 음성 기관의 움직임으로 디코딩된 신호를 말로 변환하는 것입니다.

디코딩 과정에서 연구진은 먼저 환자가 말할 때 뇌의 세 영역 표면에서 나오는 연속적인 전기도 신호를 디코딩했습니다. 이러한 전기도 신호는 침습적 전극을 통해 기록되었습니다.

디코딩을 통해 33가지 유형의 음성 기관 운동 특성 지표를 얻고, 이를 다시 32가지 음성 매개변수(음높이, 발성 등)로 디코딩하고, 최종적으로 이러한 매개변수를 기반으로 음성 음파를 합성합니다.

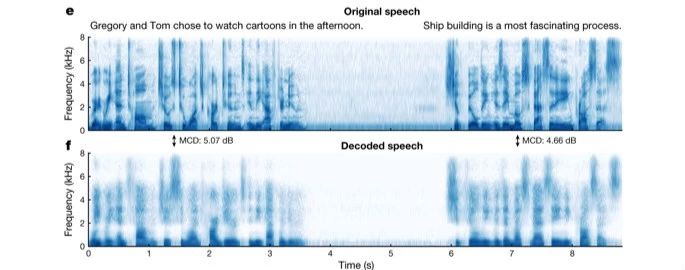

연구진은 합성 음성이 실제 음성을 재현하는 데 얼마나 정확한지 분석하기 위해 원본 음성의 음향적 특징과 합성 음성을 비교한 결과, 신경망으로 디코딩한 음성은 환자가 말한 원본 문장의 개별 음소를 매우 완벽하게 재현했을 뿐만 아니라 음소 간의 자연스러운 연결과 멈춤도 재현했다는 것을 발견했습니다.

그 후, 연구진은 크라우드소싱을 이용해 네티즌들에게 디코더가 합성한 음성을 식별해 달라고 요청했습니다. 최종 결과는 청취자가 합성된 음성의 내용을 반복한다는 것입니다.성공률은 70%에 가깝습니다.

또한 연구진은 무언의 음성을 합성하는 디코더의 능력을 테스트했습니다. 시험자는 먼저 문장을 말하고, 그런 다음 같은 문장을 소리 내지 않고 낭송합니다(움직임은 있지만 소리는 내지 않습니다). 연구 결과에 따르면, 디코더가 무음 음성의 움직임을 합성한 음성 스펙트럼은 같은 문장의 음성 스펙트럼과 유사한 것으로 나타났습니다.

이정표: 도전과 기대가 공존합니다

창 박사는 "이 연구는 개인의 뇌 활동을 기반으로 완전한 구두 문장을 생성할 수 있다는 것을 처음으로 보여줍니다."라고 말했습니다. "흥미롭네요. 이 기술은 이미 상용화되어 있고, 언어 장애 환자를 위해 임상적으로 실현 가능한 장치를 개발할 수 있을 겁니다."

논문의 제1 저자인 고팔라 아누만치팔리는 "신경 과학, 언어학, 머신 러닝 분야의 전문 지식을 모아 신경 장애가 있는 사람들을 돕는 이 중요한 이정표에 참여하게 되어 자랑스럽습니다."라고 덧붙였습니다.

물론, 뇌-컴퓨터 인터페이스 음성 상호작용에서 100% 음성 합성을 실제로 달성하기 위해서는 환자가 전극을 설치하는 침습적 수술을 받아들일 수 있을지, 실험에 사용된 뇌파가 실제 환자의 뇌파와 동일한지 등 많은 과제가 여전히 남아 있습니다.

그러나 이 연구에서 우리는음성 합성 뇌-컴퓨터 인터페이스는 더 이상 단순한 개념이 아닙니다.

우리는 언젠가 언어 장애가 있는 사람들이 가능한 한 빨리 "말"하고 자신의 생각을 표현할 수 있는 능력을 되찾을 수 있기를 바랍니다.