Command Palette

Search for a command to run...

온라인 튜토리얼: 필름 품질의 비디오 생성 모델인 Wan2.2-S2V-14B는 정적 이미지와 오디오만을 사용하여 1분 길이의 디지털 인간 비디오를 생성합니다.

HyperAI는 최근 알리바바의 통이완샹 랩(Tongyi Wanxiang Lab)에서 개발한 오픈소스 AI 비디오 생성 모델인 Wan2.2에 대한 온라인 튜토리얼을 공개했습니다. 세계 최초의 MoE 기반 비디오 모델인 Wan2.2는 영화 같은 화질과 높은 연산 효율성으로 깊은 인상을 남겼습니다. Wan2.2를 사용해 보시는 건 어떠신가요? 댓글로 여러분의 생각을 공유해 주세요.

올해 8월, 통이완샹(Tongyi Wanxiang) 팀은 새로운 진전을 이루었습니다. Wan2.2 텍스트-비디오 변환 기본 모델을 기반으로 Wan-14B를 개발했습니다.이를 기반으로 오디오 기반 비디오 생성 오픈소스 모델인 Wan2.2-S2V-14B가 출시되었습니다.이 모델에는 정적 이미지와 오디오 클립만 필요합니다.최대 몇 분 길이의 영화 수준의 텍스처를 갖춘 디지털 휴먼 비디오를 생성할 수 있으며, 다양한 이미지 유형과 프레임을 지원합니다.연구팀은 기존 최첨단 모델과 비교하는 실험을 진행한 결과, Wan2.2-S2V-14B는 표현력과 생성된 콘텐츠의 진정성 면에서 모두 상당한 향상을 보였다는 것을 확인했습니다.

연구팀은 복잡한 시나리오에서 모델 생성 품질을 지원하기 위해 두 가지 전략을 채택하여 보다 포괄적인 교육 데이터 세트를 컴파일했습니다.한편, 연구팀은 OpenHumanViD와 같은 대규모 오픈소스 데이터셋에서 데이터를 자동으로 선별했습니다. 다른 한편, 연구진은 고품질 샘플 데이터를 수동으로 선택하고 맞춤 설정했습니다. 두 데이터셋 모두 자세 추적, 선명도 및 심미성 평가, 시청각 동기화 감지 등 다양한 방법을 통해 균일하게 필터링하여 최종적으로 대화형 헤드 데이터셋을 구축했습니다. 하이브리드 병렬 학습 전략을 사용하여 효율적인 모델 성능 마이닝을 달성했습니다.

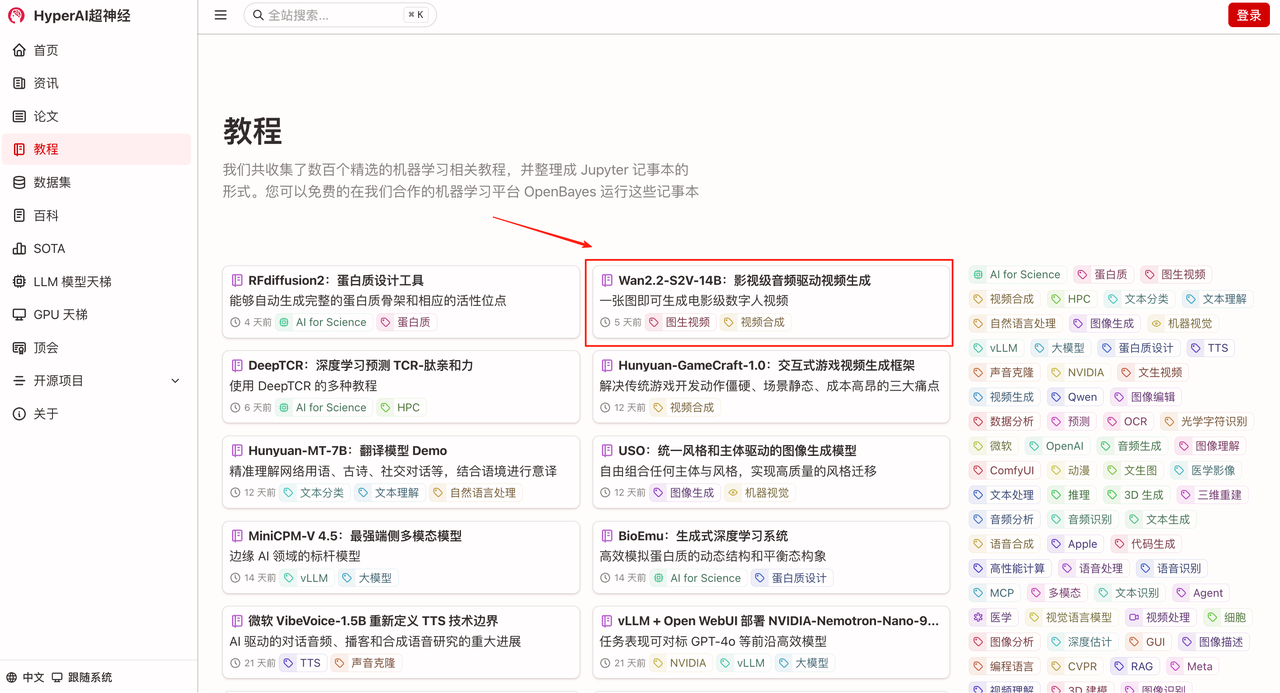

HyperAI 공식 웹사이트(hyper.ai)의 "튜토리얼" 섹션에서 "Wan2.2-S2V-14B: 시네마틱 오디오 기반 비디오 생성"을 확인해 보세요. 직접 디지털 휴먼을 만들어 보세요!

튜토리얼 링크:

데모 실행

1. hyper.ai 홈페이지에서 튜토리얼 페이지를 선택하고 Wan2.2-S2V-14B: 필름 품질의 오디오 기반 비디오 생성을 선택한 후 이 튜토리얼을 온라인으로 실행을 클릭합니다.

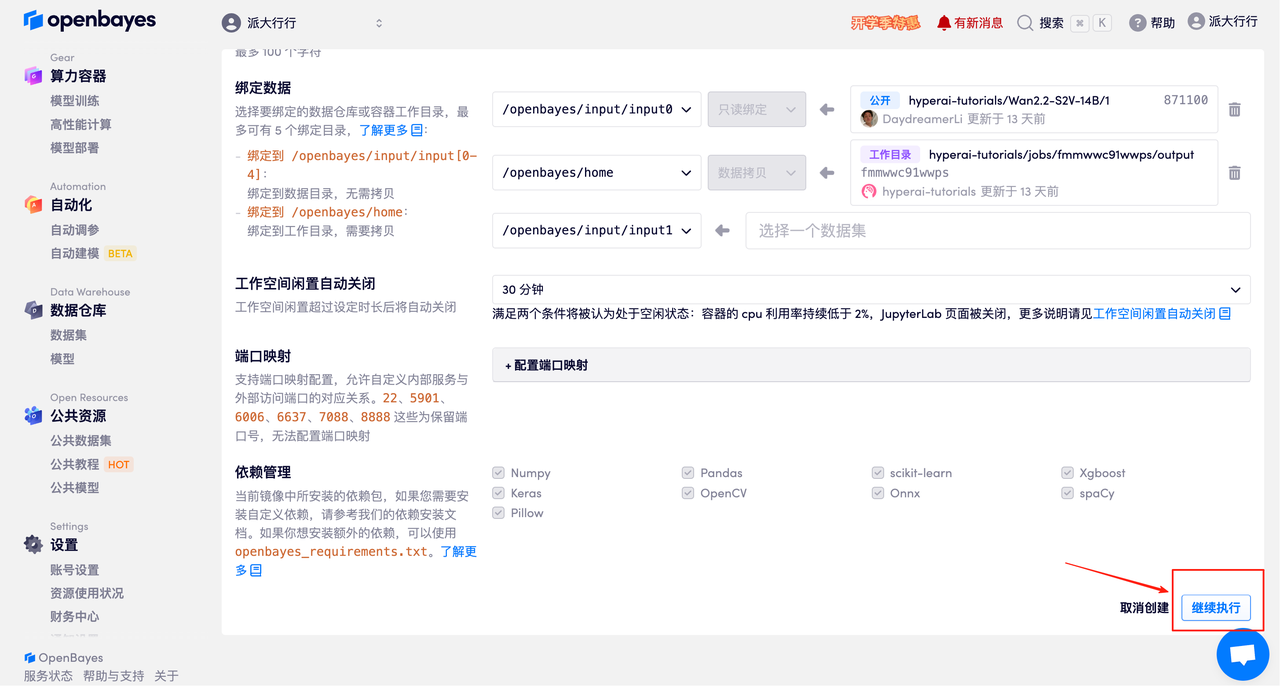

2. 페이지가 이동한 후 오른쪽 상단의 "복제"를 클릭하여 튜토리얼을 자신의 컨테이너로 복제합니다.

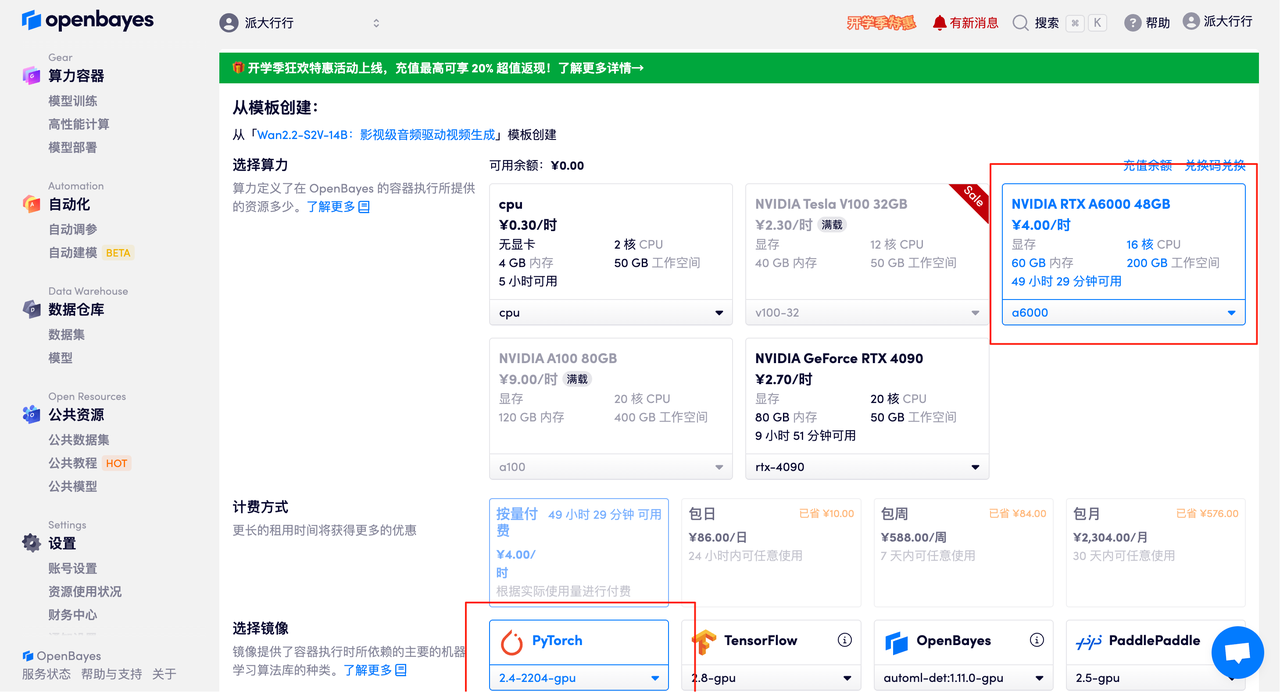

3. NVIDIA RTX A6000 48GB 및 PyTorch 이미지를 선택하고 "계속"을 클릭하세요. OpenBayes 플랫폼은 사용량 기반 요금제 또는 일일/주간/월간 요금제 등 네 가지 결제 옵션을 제공합니다. 신규 사용자는 아래 초대 링크를 통해 등록하시면 RTX 4090 4시간과 CPU 5시간 무료 이용권을 받으실 수 있습니다!

HyperAI 독점 초대 링크(복사하여 브라우저에서 열기):

https://openbayes.com/console/signup?r=Ada0322_NR0n

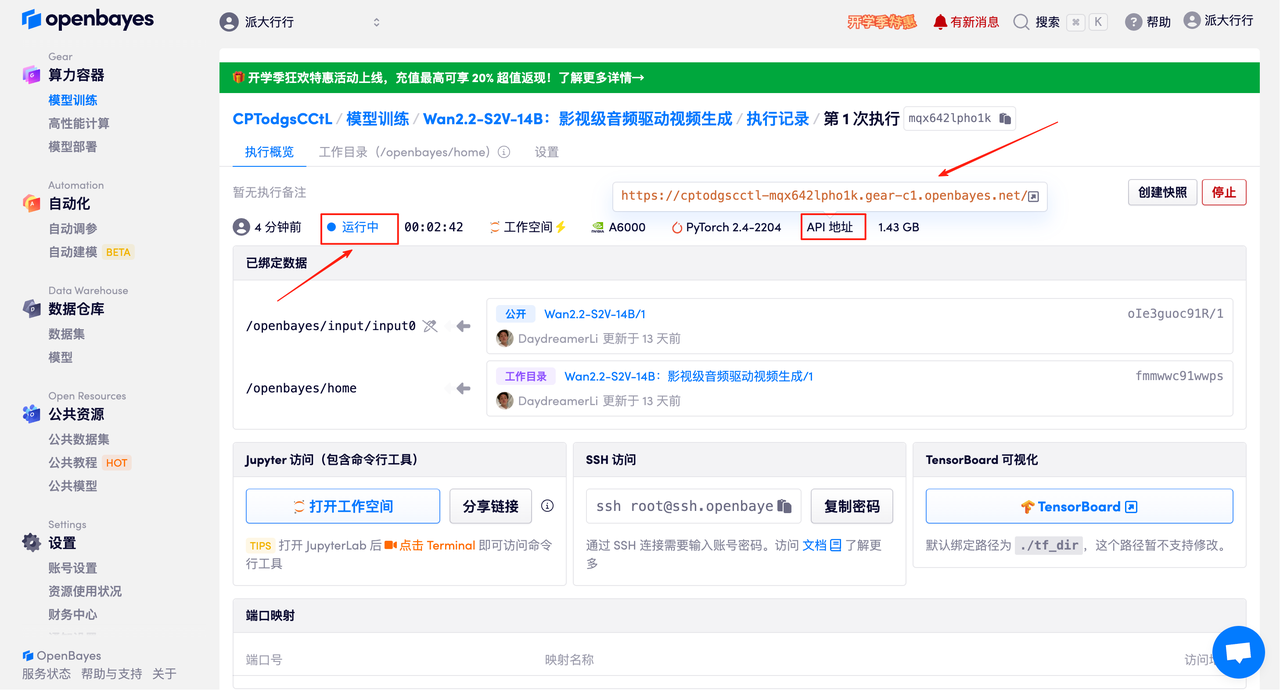

4. 리소스가 할당될 때까지 기다리세요. 첫 번째 복제 프로세스는 약 3분 정도 소요됩니다. 상태가 "실행 중"으로 변경되면 "API 주소" 옆의 화살표를 클릭하여 데모 페이지로 이동하세요. API 주소를 사용하려면 실명 인증을 완료해야 합니다.

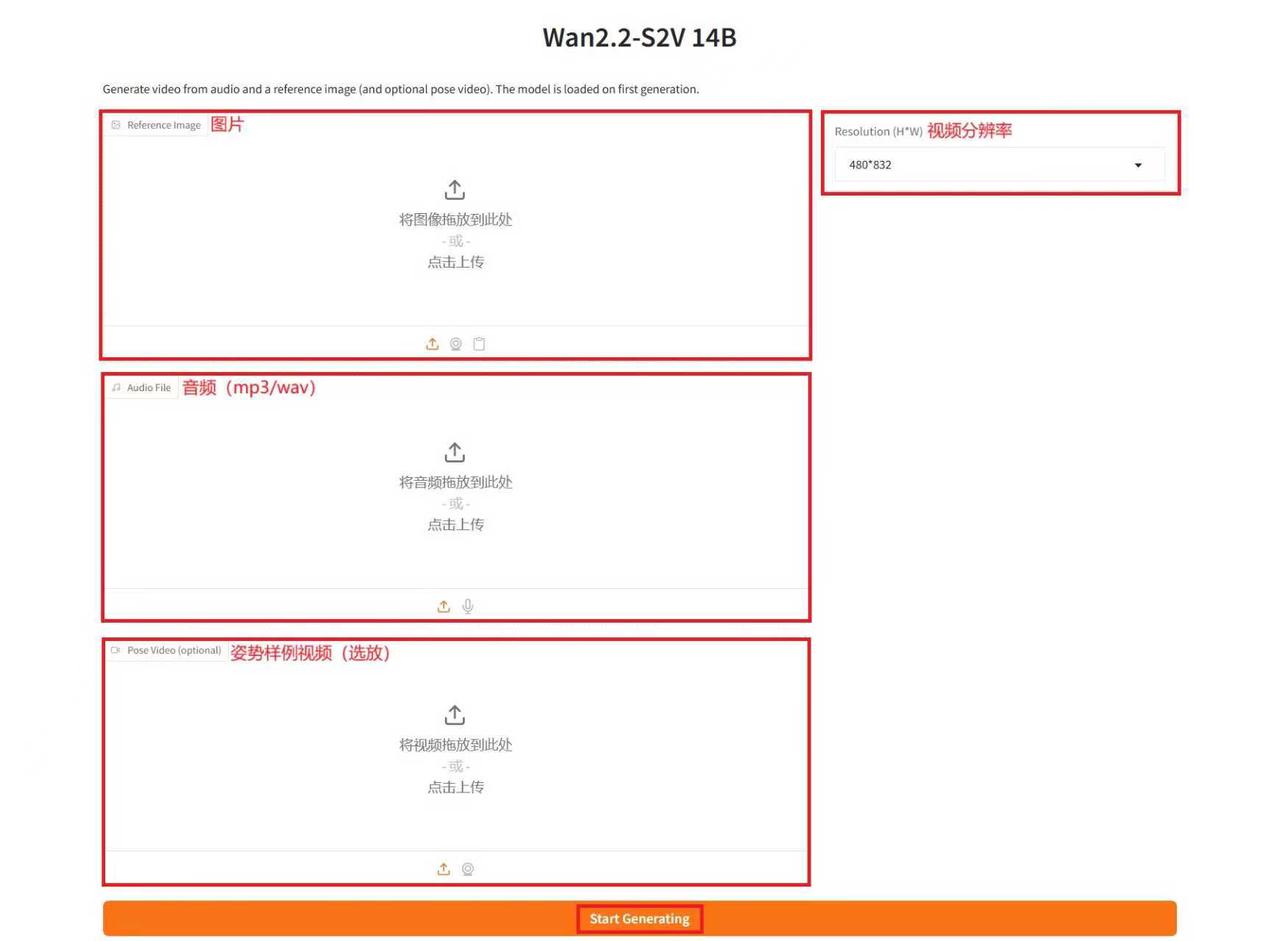

효과 시연

데모 실행 페이지에 접속한 후 텍스트 상자에 설명을 입력하고, 이미지와 오디오를 업로드하고, 필요에 따라 매개변수를 조정한 후 "생성 시작"을 클릭하면 비디오가 생성됩니다. (참고: 추론 단계 수가 많을수록 결과는 더 좋지만, 생성 시간이 더 오래 걸립니다. 추론 단계 수를 적절하게 설정해야 합니다. 예를 들어, 추론 단계가 10개일 경우 비디오 생성에 약 15분이 소요됩니다.)

예를 생성하세요

위는 HyperAI가 이번에 추천하는 튜토리얼입니다. 누구나 와서 체험해 보세요!

튜토리얼 링크: