Command Palette

Search for a command to run...

Qwen3-Max는 1조 개가 넘는 매개변수를 자랑하며, 여러 벤치마크에서 SOTA를 달성했고, 예측 추론 강화 버전은 수학 올림피아드에서 완벽한 점수를 달성했습니다.

오늘(9월 24일) 윈치(Yunqi) 연례 컨퍼런스가 공식 개막했습니다. 알리바바 클라우드가 그 강점을 뽐내는 이 무대에서 AI는 단연 주인공입니다. 오픈소스 모델부터 에이전트 애플리케이션, 서버 및 개발자 생태계와 같은 인프라까지, 알리바바 클라우드는 이번 AI 경연 대회에서 기술 경쟁력을 유감없이 발휘했습니다.허깅페이스 리스트에 따르면, 통이첸문을 기반으로 개발된 파생모델의 수는 17만개에 달해 미국 라마 시리즈를 제치고 세계 1위를 차지했습니다.

알리바바를 관심 있게 지켜보시는 독자라면 윈치(Yunqi) 컨퍼런스 개막 하루 전, 알리바바의 통이 빅 모델(Tongyi Big Model) 팀이 네이티브 옴니모달 빅 모델인 Qwen3-Omni, 음성 생성 모델인 Qwen3-TTS, 이미지 편집 모델인 Qwen-Image-Edit-2509 등 세 가지 고성능 모델을 오픈소스로 공개했음을 알고 계실 것입니다. 이 모델들은 모두 해당 분야에서 주류 모델이나 심지어 SOTA(Syntax Talent Analysis) 수준의 성능을 달성했습니다.

이제 이것들은 단지 에피타이저일 뿐인 것 같습니다. 방금 마무리된 Yunqi 컨퍼런스 개막식에서 Qwen3-Max가 공식 공개되었습니다. 이 모델은 현재까지 출시된 모델 중 가장 크고 강력한 모델로 알려져 있습니다. 총 모델 매개변수가 1T에 달하여 여러 평가 기준을 휩쓸었습니다. 또한,또한 이 컨퍼런스에서는 Qwen3-VL, Qwen3-Coder와 같은 모델이 소개되었습니다.

Qwen3-Max: 지금까지 가장 크고 강력한

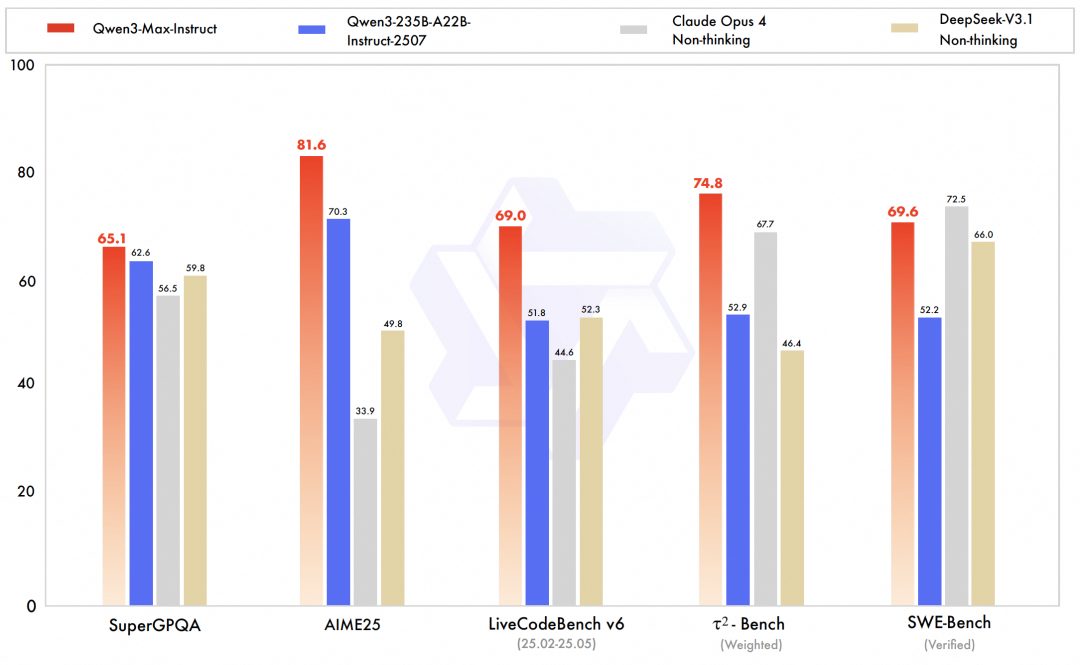

Qwen3-Max는 이번 릴리스의 단연 하이라이트입니다. 팀 역사상 가장 크고 강력한 모델인 Qwen3-Max-Instruct의 프리뷰 버전은 LMArena 텍스트 리더보드에서 GPT-5-Chat을 제치고 3위를 차지했습니다.공식 버전은 코드 기능과 에이전트 기능을 더욱 개선하여 지식, 추론, 프로그래밍, 지시 따르기, 인간 선호도 정렬, 지능형 에이전트 작업 및 다국어 이해를 포괄하는 포괄적인 벤치마크 테스트에서 SOTA 수준에 도달했습니다.예를 들어, 실제 프로그래밍 문제 해결에 중점을 둔 SWE-Bench Verified 벤치마크에서 Qwen3-Max-Instruct는 69.6점이라는 뛰어난 점수를 기록했습니다. 지능형 에이전트의 도구 호출 성능을 평가하는 Tau2-Bench 벤치마크에서 Qwen3-Max-Instruct는 Claude Opus 4와 DeepSeek-V3.1을 74.8점으로 제치고 1위를 차지했습니다.

구체적으로, Qwen3-Max 모델의 총 매개변수는 1T를 초과하며, 36T 토큰이 사전 학습에 사용됩니다.모델 아키텍처는 Qwen3 시리즈의 MoE 모델 설계를 따르며, 글로벌 배치 부하 분산 손실을 활용하여 안정적이고 원활한 사전 학습 손실을 보장합니다. 학습 롤백이나 데이터 분포 변경과 같은 손실 급증이나 조정 없이 원활하게 학습이 진행됩니다.

공식 발표에 따르면, PAI-FlashMoE의 효율적인 다단계 파이프라인 병렬 전략 최적화를 통해 Qwen3-Max-Base의 학습 효율이 크게 향상되었으며, MFU는 Qwen2.5-Max-Base 대비 30%만큼 향상되었습니다. 긴 시퀀스 학습 시나리오에서 연구팀은 ChunkFlow 전략을 활용하여 시퀀스 병렬 솔루션보다 3배 높은 처리량 이점을 얻었으며, 1M 길이의 Qwen3-Max 학습을 지원했습니다. 동시에, SanityCheck, EasyCheckpoint, 스케줄링 링크 최적화 등 다양한 방법을 통해대규모 클러스터에서 Qwen3-Max의 하드웨어 오류로 인한 시간 손실은 Qwen2.5-Max의 1/5로 줄었습니다.

Qwen3-Max의 추론 기능이 강화된 버전인 Qwen3-Max-Thinking이 공식적으로 발표되지는 않았지만, 개발팀이 공개한 자료에 따르면 심층 추론 능력이 새로운 최고 수준에 도달하여, 매우 어려운 수학적 추론 벤치마크인 AIME 25와 HMMT에서 만점을 받았고, 심지어 올림픽 수학 경시대회에서도 만점을 받았습니다.

Qwen3-VL-235B: SOTA를 새롭게 하고 세계 1위를 차지하다

Qwen3-VL은 Qwen3 제품군 내의 다중 모드 시각-언어 모델(VLM)입니다. 시각적 이해와 텍스트 생성 기능 간의 균형과 혁신을 달성하는 것을 목표로 합니다. 연구팀은 이 모델이 현재까지 Qwen 제품군에서 가장 강력한 시각-언어 모델이라고 자부합니다. Qwen3-VL은 순수 텍스트 이해 및 생성, 시각적 콘텐츠 인식 및 추론, 맥락 길이 지원, 공간 관계 및 동적 비디오 이해, 심지어 에이전트 상호작용 성능까지 크게 향상되었습니다.

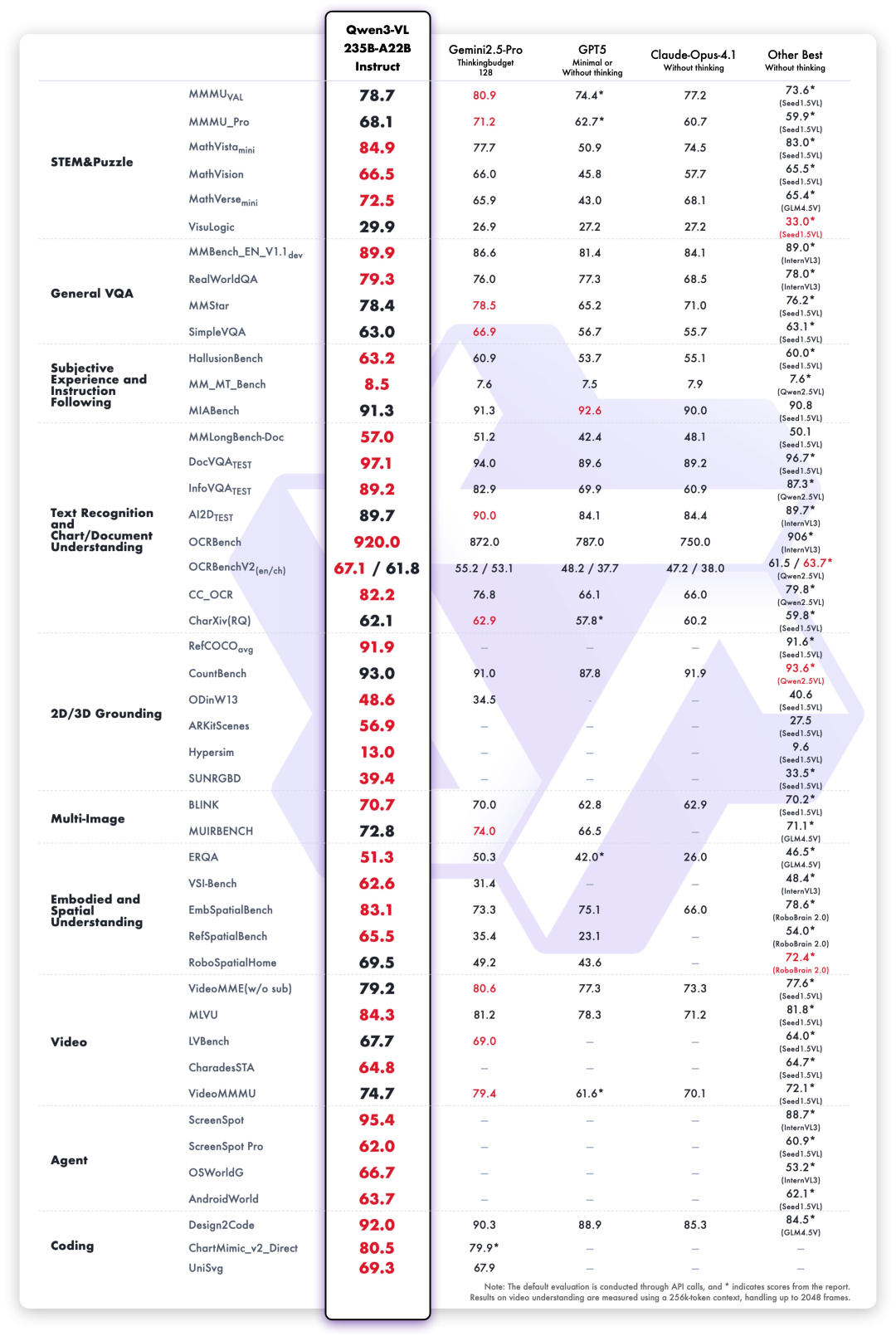

이번에 출시된 새로운 오픈소스 플래그십 모델 Qwen3-VL-235B는 전체 성능 면에서 세계 1위를 차지했으며, 고화질 복합 이미지와 미세한 인식 장면에서 성능이 크게 향상되었습니다.여기에는 Instruct 버전과 Thinking 버전이 모두 포함되어 있습니다.

종합적인 대학 문제, 수학적 및 과학적 추론, 논리 퍼즐, 일반적인 시각적 질문 답변, 주관적 경험 및 지시 따르기, 다국어 텍스트 인식 및 차트 문서 구문 분석을 포함한 10가지 차원의 평가에 따라,Qwen3-VL-235B-A22B-Instruct는 비추론 모델 중 대부분 지표에서 가장 좋은 성능을 보입니다.이 모델은 Gemini 2.5 Pro 및 GPT-5와 같은 폐쇄형 소스 모델을 크게 능가하는 동시에 오픈 소스 멀티모달 모델의 가장 좋은 결과를 새롭게 하여 강력한 일반화 능력과 복잡한 시각 작업에서의 포괄적인 성능을 입증합니다.

특히, Qwen3-VL은 여러 가지 핵심 기능 측면에서 체계적인 업그레이드를 거쳤습니다.

비주얼 에이전트:Qwen3-VL은 컴퓨터 및 휴대폰 인터페이스를 조작하고, GUI 요소를 식별하고, 버튼 기능을 이해하고, 도구를 호출하고, 작업을 실행할 수 있습니다. OS World와 같은 벤치마크에서 세계 최고 수준에 도달했으며, 도구를 호출하여 세밀한 인식 작업에서 성능을 효과적으로 향상시킬 수 있습니다.

일반 텍스트 기능은 최고 언어 모델과 동등합니다.Qwen3-VL은 사전 학습 초기 단계에서 텍스트와 시각적 모달리티를 혼합하여 협력 학습을 수행함으로써 텍스트 처리 능력을 지속적으로 강화합니다. 궁극적으로 순수 텍스트 과제에서의 성능은 주력 순수 텍스트 모델인 Qwen3-235B-A22B-2507과 유사합니다. 탄탄한 텍스트 기반과 다중 모달 기능을 갖춘 진정한 차세대 시각적 언어 모델입니다.

시각적 코딩 기능이 크게 개선되었습니다.이미지 생성 코드와 비디오 생성 코드를 구현하세요. 예를 들어, 디자인 도면을 보면 Draw.io/HTML/CSS/JS 코드가 생성되어 "보이는 대로 얻는다"는 시각적 프로그래밍을 구현합니다.

공간 지각 능력이 크게 향상되었습니다.2D 접지는 절대 좌표에서 상대 좌표로 변환되어 객체 방향, 원근법 변화, 그리고 가림 관계 판단을 지원합니다. 3D 접지를 구현하고 복잡한 시나리오에서 공간 추론 및 구현된 장면의 기반을 마련할 수 있습니다.

긴 컨텍스트 지원 및 긴 비디오 이해:전체 모델 패밀리는 기본적으로 256,000 토큰의 컨텍스트 길이를 지원하며, 최대 100만 토큰까지 확장 가능합니다. 즉, 수백 페이지 분량의 기술 문서, 전체 교과서, 또는 2시간 분량의 비디오 등 어떤 내용이든 완벽하게 입력, 기억, 검색하여 초 단위까지 정확한 비디오 위치 파악을 지원합니다.

다중 모드 사고 능력이 크게 향상되었습니다.Thinking 모델은 STEM 및 수학적 추론 능력을 우선시합니다. 전문 과목 문제에 직면했을 때, 이 모델은 세부 사항을 포착하고, 복잡성을 해소하며, 인과 관계를 분석하고, 논리적이고 근거 있는 답변을 제공합니다. MathVision, MMMU, MathVista와 같은 권위 있는 평가에서 최고의 성과를 거두었습니다.

시각적 인식 및 인지 기능이 전면적으로 업그레이드되었습니다. 사전 학습 데이터의 품질과 폭을 최적화함으로써 이 모델은 이제 유명인, 애니메이션 캐릭터, 상품, 랜드마크부터 식물과 동물까지 더욱 다양한 객체 범주를 인식할 수 있어 일상생활과 전문 분야에서 필요한 모든 것을 인식할 수 있습니다.

OCR은 더 많은 언어와 복잡한 시나리오를 지원합니다.중국어와 영어 이외의 지원 언어 수가 10개에서 32개로 확대되어 더 많은 국가와 지역을 포괄합니다. 복잡한 조명, 흐림, 기울기 등 까다로운 실제 촬영 시나리오에서도 성능이 더욱 안정적입니다. 희귀 문자, 고대 문자, 전문 용어의 인식 정확도도 크게 향상되었습니다. 매우 긴 문서를 이해하고 미세 구조를 복원하는 기능이 더욱 향상되었습니다.

Qwen3 코더 플러스:프로그래밍 효율성더 높고 더 정확함

Qwen3 시리즈의 독점적인 코딩 모델인 Qwen3 Coder는 이전 세대 Coder의 포괄적인 업그레이드 버전입니다. 더욱 향상된 프로그래밍 효율성과 정확성을 제공하기 위해 폐쇄형 소스 API를 채택했습니다. 전 세계에서 가장 인기 있는 프로그래밍 모델 중 하나로 자리매김했으며, 개발자들의 폭넓은 사랑을 받고 있습니다.

이번에 출시된 Qwen3 Coder Plus는 알리바바의 오픈소스 Qwen3 Coder 480B A35B의 자체 개발 버전입니다.강력한 코딩 에이전트 모델로서, 도구 호출과 환경 상호작용을 통한 자율 프로그래밍에 탁월하며, 코딩 기능과 다양한 일반 기능을 결합합니다.

기술적 주요 내용:

* Qwen Code 및 Claude Code 시스템을 사용한 공동 훈련으로 CLI 애플리케이션 성능이 크게 향상되었습니다.

* 더 빠른 추론 속도와 더 효율적인 작업 실행 * 향상된 코드 보안, 책임 있는 AI로의 전환

HyperAI Hyperneural 공식 웹사이트(hyper.ai)에서 Tongyi Qianwen 팀을 기반으로 한 고품질 오픈소스 모델 튜토리얼을 다수 공개했습니다. 원클릭 배포 튜토리얼 링크는 https://hyper.ai/tutorials 에서 확인하실 수 있습니다.