Command Palette

Search for a command to run...

gpt-oss-20b의 원클릭 배포, o3‑mini에 근접하는 최첨단 성능으로 오픈 소스 추론 모델 테스트

GPT-2 이후 6년 만에 OpenAI가 마침내 또 다른 오픈소스 대형 모델을 출시했습니다. gpt-oss-120b와 gpt-oss-20b가 출시되었습니다.전자는 수천억 개의 매개변수를 사용하는 복잡한 추론 및 지식 집약적 시나리오를 위해 설계된 반면, 후자는 노트북이나 엣지 기기와 같은 소비자용 하드웨어에서 원활하게 실행되는 저지연, 로컬 또는 특수 수직 애플리케이션에 더 적합합니다. "대형 모델의 다양성 + 소형 모델의 전문성"을 결합한 이 두 가지 버전은 차별화된 포지셔닝 및 배포 유연성을 제공하여 사용자의 다양한 요구를 효과적으로 충족합니다.

기술적인 측면에서 gpt-oss는 MoE 아키텍처를 사용하여 컴퓨팅 및 메모리 요구 사항을 크게 줄이는 동시에 강력한 성능을 보장합니다.그 중 gpt-oss-120b는 80GB GPU 하나에서 효율적으로 실행될 수 있고, gpt-oss-20b는 16GB 메모리만 있는 엣지 디바이스에서 실행될 수 있습니다.

실제 작업 평가에서 gpt-oss-120b는 Codeforces, MMLU, HLE 및 도구 호출 TauBench에서 o3-mini보다 우수한 성능을 보였으며 o4-mini와 동등하거나 심지어 능가했습니다.또한 HealthBench와 AIME 2024 및 2025에서 o4-mini보다 우수한 성능을 보였습니다. 모델 매개변수 크기가 더 작음에도 불구하고 gpt-oss-20b는 동일한 평가에서 o3‑mini와 거의 같은 성능을 보였습니다.

모든 분들이 보다 원활하게 gpt-oss를 경험하실 수 있도록,"Llama.cpp+open-webui를 이용한 Gpt-oss-20b 배포" 튜토리얼이 이제 HyperAI 공식 웹사이트(hyper.ai)의 "튜토리얼" 섹션에서 제공됩니다.한 번의 클릭으로 시작하여 단일 NVIDIA RTX 4090 카드 기반의 오픈 소스 SOTA 모델의 강력한 성능을 경험해 보세요.

게다가,gpt-oss-120b에 대한 튜토리얼도 한창 제작 중이며, 기대가 큽니다!

튜토리얼 링크:

데모 실행

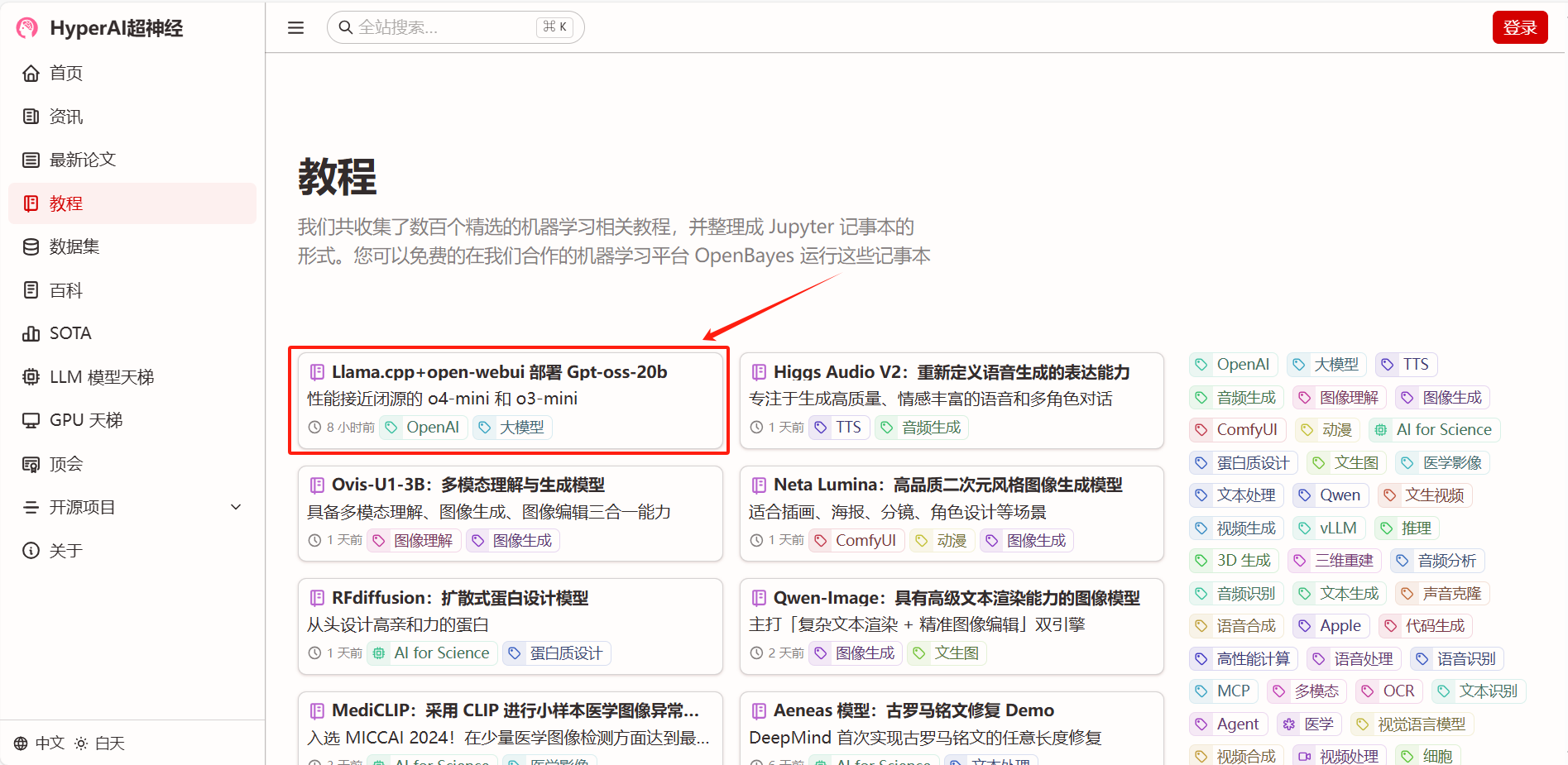

1. hyper.ai 홈페이지에서 튜토리얼 페이지를 선택하고, Llama.cpp+open-webui를 선택하여 gpt-oss-20b를 배포하고, 이 튜토리얼을 온라인으로 실행을 클릭합니다.

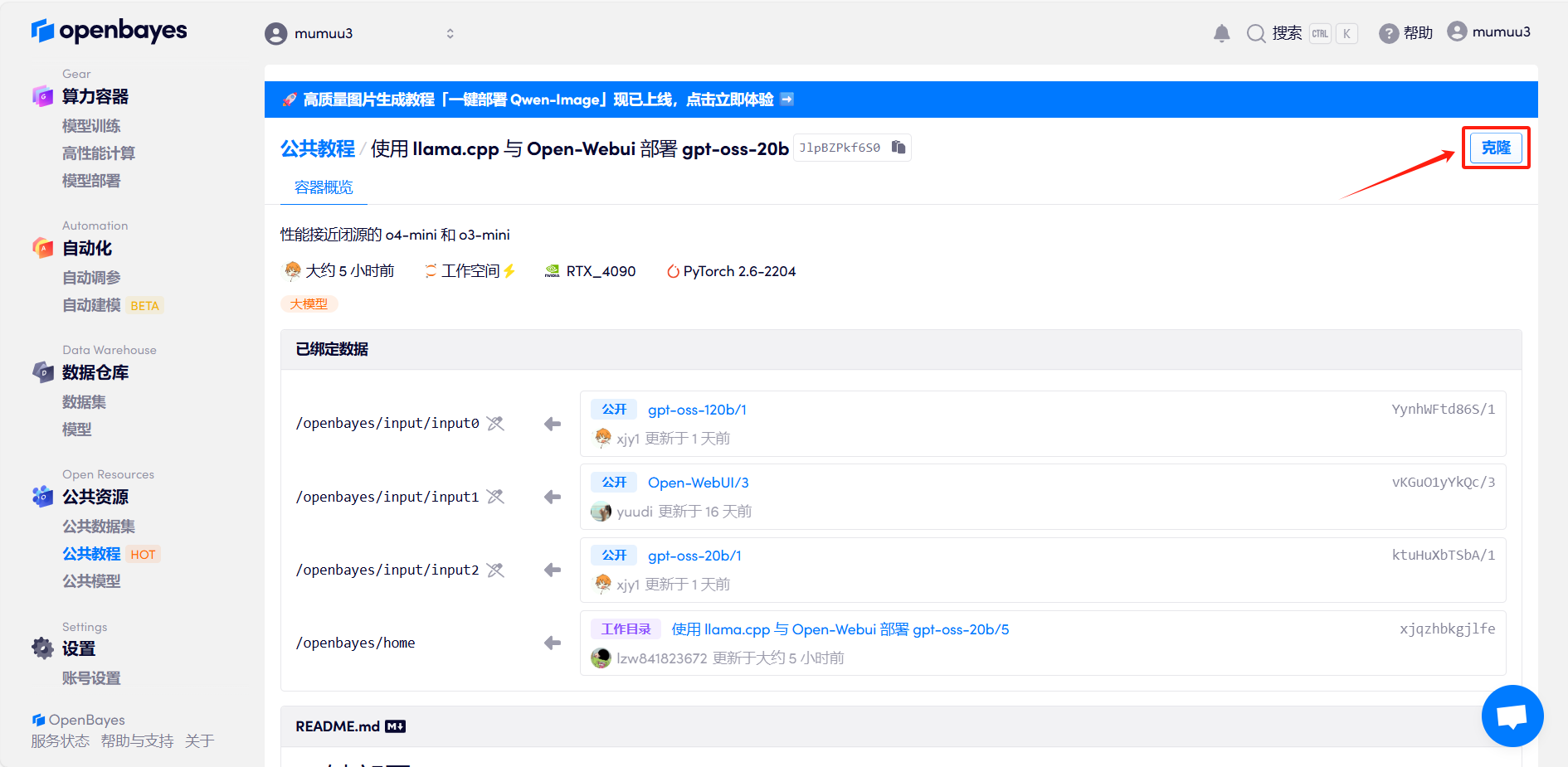

2. 페이지가 이동한 후 오른쪽 상단의 "복제"를 클릭하여 튜토리얼을 자신의 컨테이너로 복제합니다.

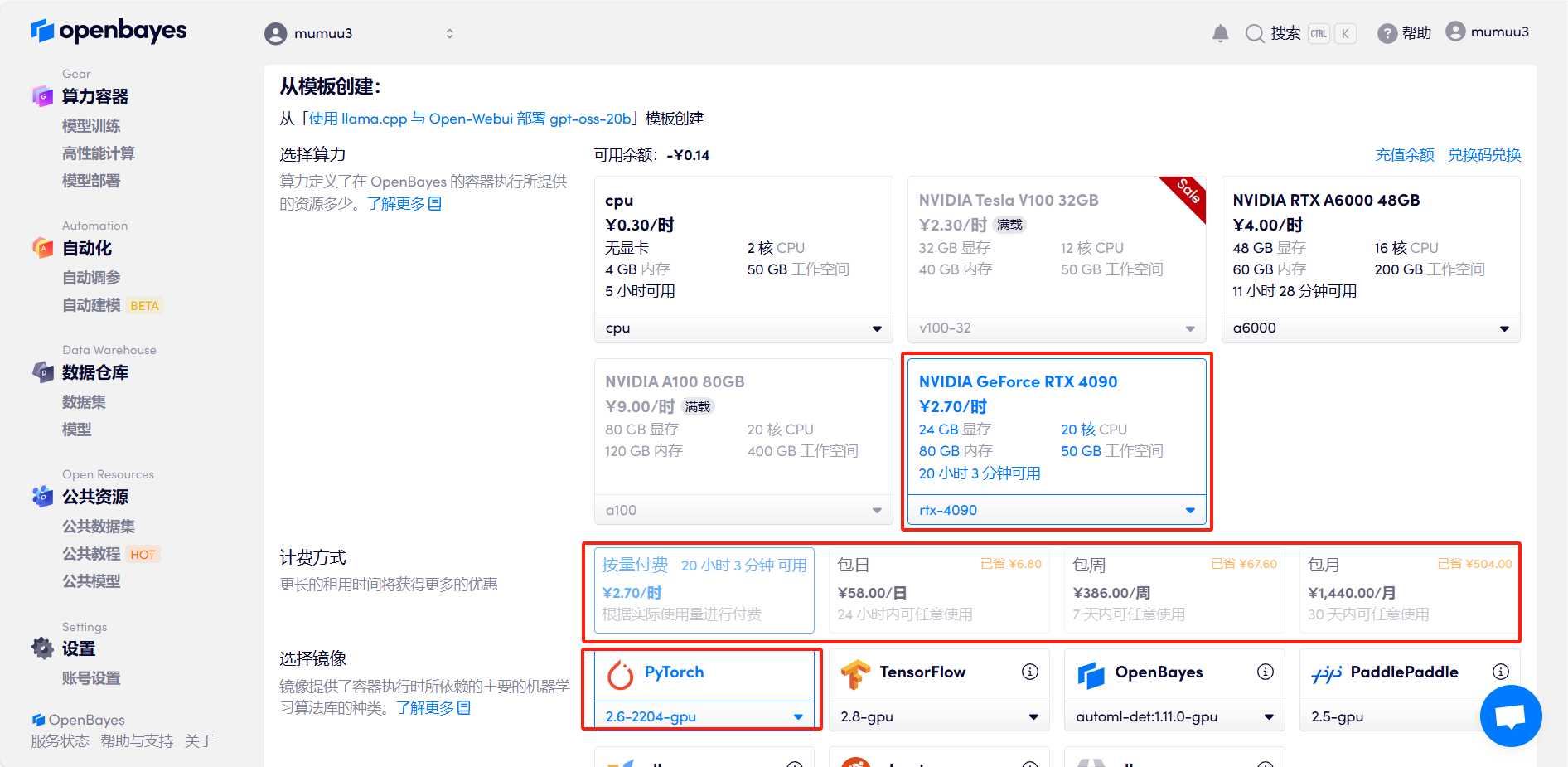

3. "NVIDIA GeForce RTX 4090" 및 "PyTorch" 이미지를 선택하고 필요에 따라 "Pay as you go" 또는 "Daily/Weekly/Monthly Package"를 선택한 후 "Continue"를 클릭하세요. 신규 사용자는 아래 초대 링크를 통해 등록하시면 RTX 4090 4시간 + CPU 무료 사용 시간 5시간을 받으실 수 있습니다!

HyperAI 독점 초대 링크(복사하여 브라우저에서 열기):

https://openbayes.com/console/signup?r=Ada0322_NR0n

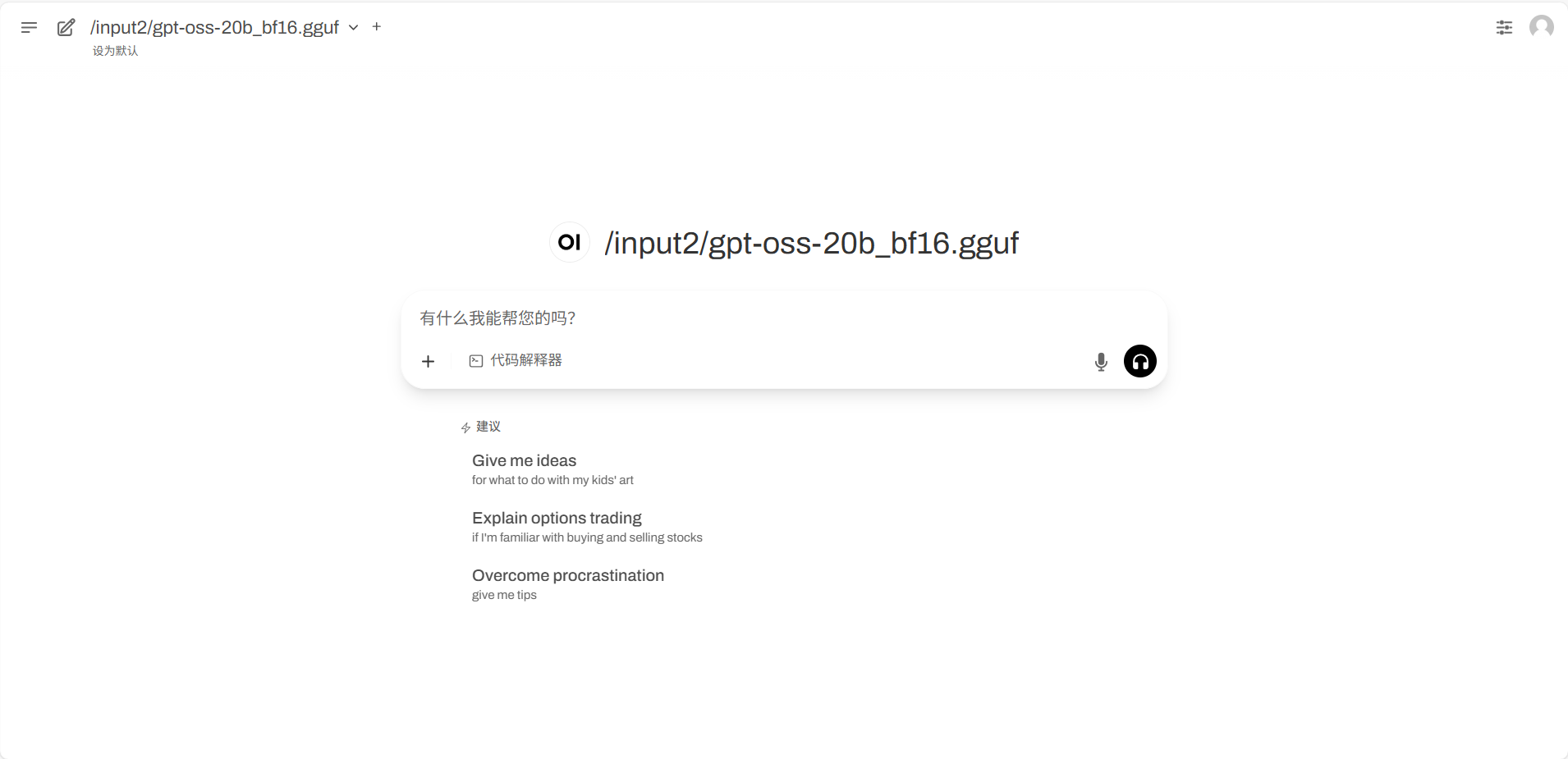

4. 리소스가 할당될 때까지 기다리세요. 첫 번째 복제 프로세스는 약 3분 정도 소요됩니다. 상태가 "실행 중"으로 변경되면 "API 주소" 옆의 화살표를 클릭하여 데모 페이지로 이동하세요. API 주소를 사용하려면 실명 인증을 완료해야 합니다.

효과 시연

데모 실행 페이지에 들어간 후 대화 상자에 Prompt를 입력하고 실행을 클릭합니다.

저자는 모델의 콘텐츠 생성, 수학적 문제 해결, 추론 능력에 대한 간단한 테스트를 실시하였고, gpt-oss의 답변은 모두 매우 좋았습니다.

프롬프트: KFC의 Crazy Thursdays에 대한 코미디 대본을 약 300단어로 작성해 주세요.

프롬프트: (제곱근 2 + 제곱근 3)의 2006 제곱의 소수점 이하 첫째 자리와 둘째 자리는 몇입니까?

프롬프트: 다음 논리가 맞는지 판단하세요: 살인자는 배낭여행자가 아니고, 당신도 배낭여행자가 아니므로, 당신이 살인자입니다.

위는 HyperAI가 이번에 추천하는 튜토리얼입니다. 누구나 와서 체험해 보세요!

튜토리얼 링크: