Command Palette

Search for a command to run...

QwQ-32B 원클릭 배포 튜토리얼이 온라인에 있으며 성능은 DeepSeek-R1의 전체 기능 버전과 유사합니다.

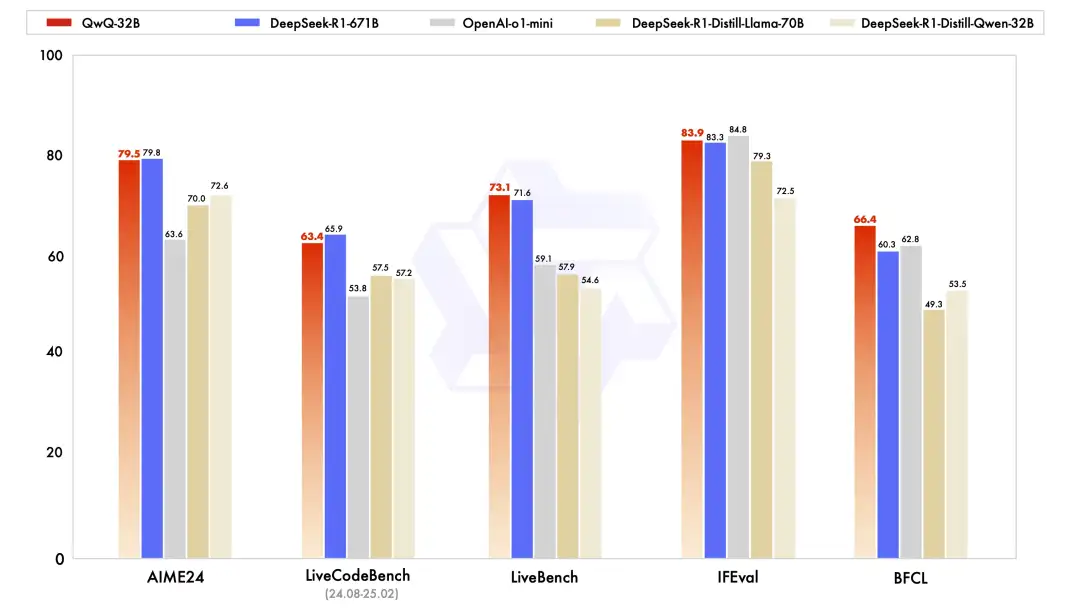

어제 알리바바 클라우드는 갑자기 큰 움직임을 보이며 새로운 추론 모델인 Tongyi Qianwen QwQ-32B를 오픈 소스로 공개했습니다.여러 주요 벤치마크에서 32B 매개변수로 OpenAI-o1-mini를 능가했으며, 671B 매개변수로 DeepSeek-R1의 순수 버전과 비슷한 수준이었습니다. QwQ-32B는 놀라운 성능을 제공할 뿐만 아니라, 강력한 성능을 유지하면서도 배치 비용을 크게 절감합니다. 또한 소비자용 그래픽 카드에 로컬로 배포할 수 있어 강도와 비용 효율성의 모델이 되었습니다.

기술적인 측면에서 QwQ-32B는 콜드 스타트 기반의 2단계 강화 학습 방법을 채택합니다. 첫 번째 단계에서는 수학과 코드 작업에 초점을 맞추고, 수학적 검증 도구와 코드 샌드박스를 사용하여 모델의 논리적 추론 능력을 향상시키는 데 집중합니다.

두 번째 단계에서는 기존 보상 모델을 대체하기 위해 답변 검증 메커니즘을 사용합니다. 수학 문제의 경우, 결과의 정확성에 따라 피드백이 제공됩니다. 프로그래밍 작업의 경우, 일반적인 기능을 개선하기 위해 테스트 케이스를 통해 서버에서 실시간 평가를 수행합니다. 또한, QwQ-32B는 에이전트 관련 기능도 통합하여 환경 피드백에 따라 추론 과정을 유연하게 조정할 수 있어 모델의 자율성과 적응성이 크게 향상됩니다.

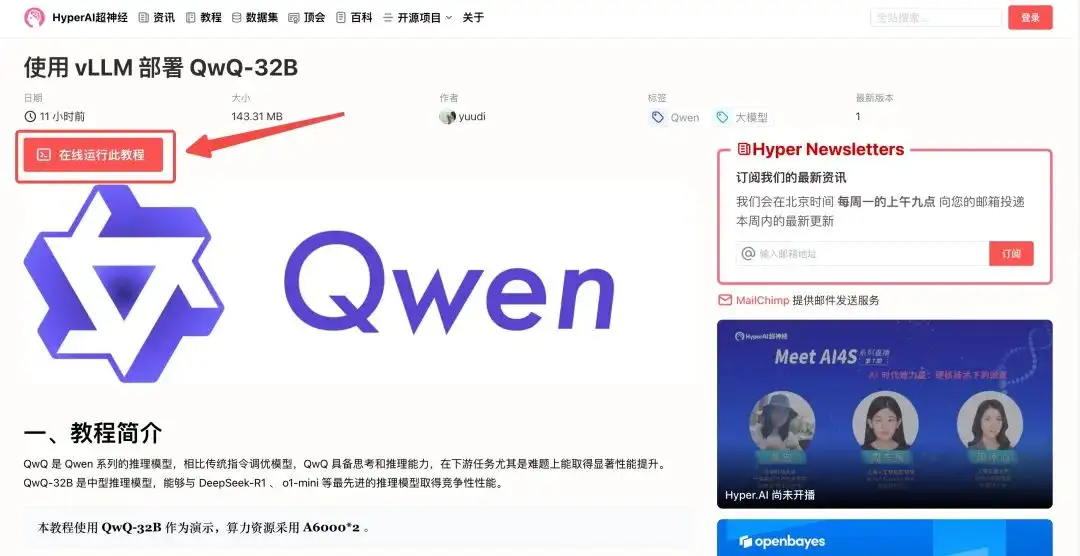

"vLLM을 사용하여 QwQ-32B 배포"는 이제 HyperAI 공식 웹사이트의 "튜토리얼" 섹션에서 이용할 수 있습니다.작은 매개변수와 큰 힘, 당신이 검증해 주기를 기다리고 있습니다!

튜토리얼 주소:

데모 실행

1. hyper.ai에 로그인하고 튜토리얼 페이지에서 'vLLM을 사용하여 QwQ-32B 배포'를 선택한 다음 '이 튜토리얼을 온라인으로 실행'을 클릭합니다.

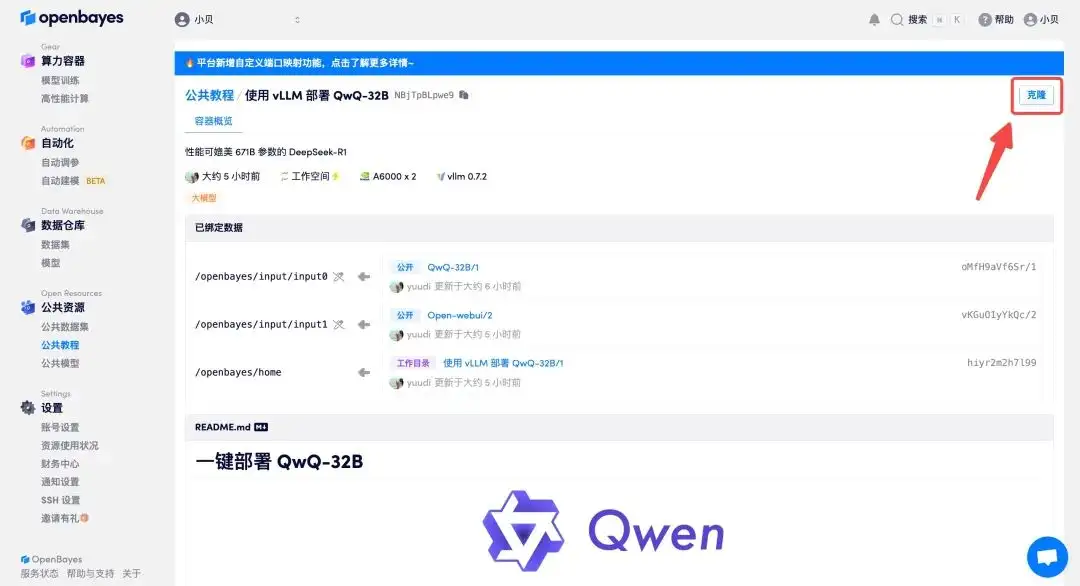

2. 페이지가 이동한 후 오른쪽 상단의 "복제"를 클릭하여 튜토리얼을 자신의 컨테이너로 복제합니다.

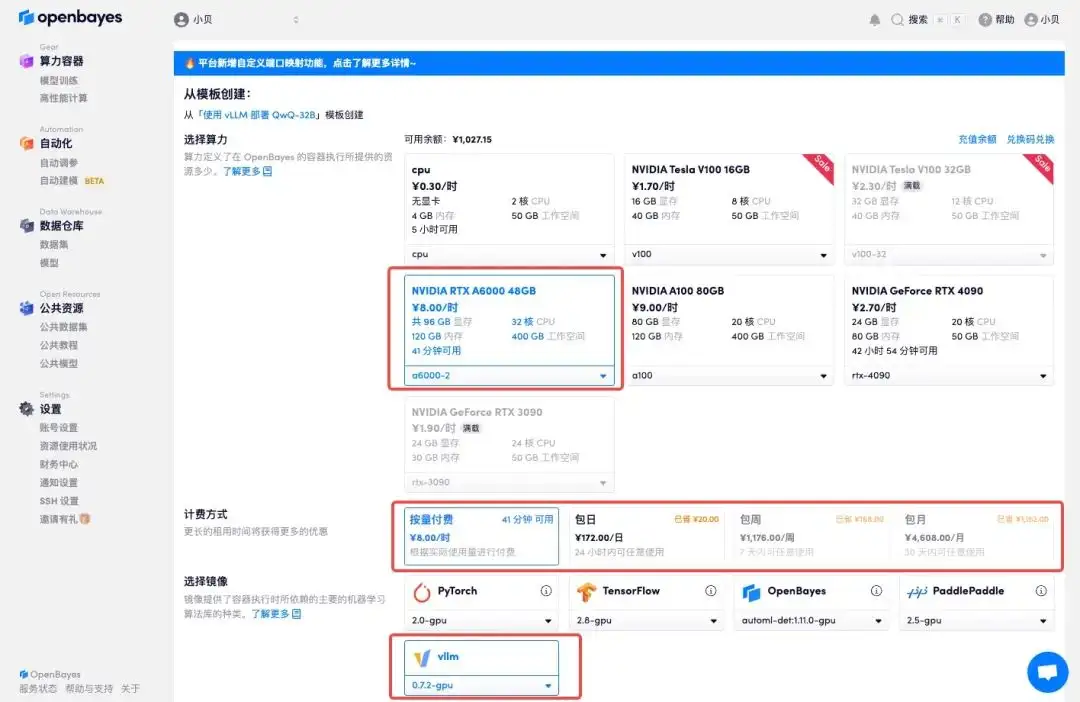

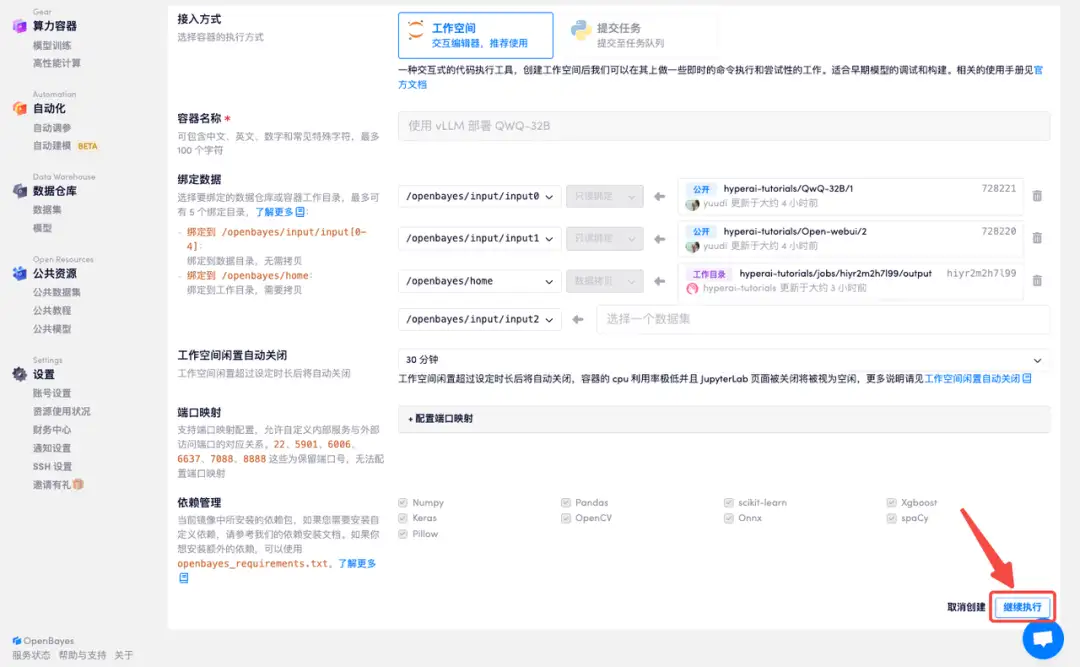

3. "NVIDIA A6000-2"와 "vllm" 이미지를 선택하세요. OpenBayes 플랫폼에서 새로운 청구 방법이 출시되었습니다. 귀하의 요구 사항에 따라 "사용 후 결제" 또는 "일일/주간/월간"을 선택할 수 있습니다. "계속"을 클릭하세요. 신규 사용자는 아래 초대 링크를 사용하여 등록하고 RTX 4090 4시간 + CPU 자유 시간 5시간을 받으세요!

HyperAI 독점 초대 링크(복사하여 브라우저에서 열기):

https://openbayes.com/console/signup?r=Ada0322_NR0n

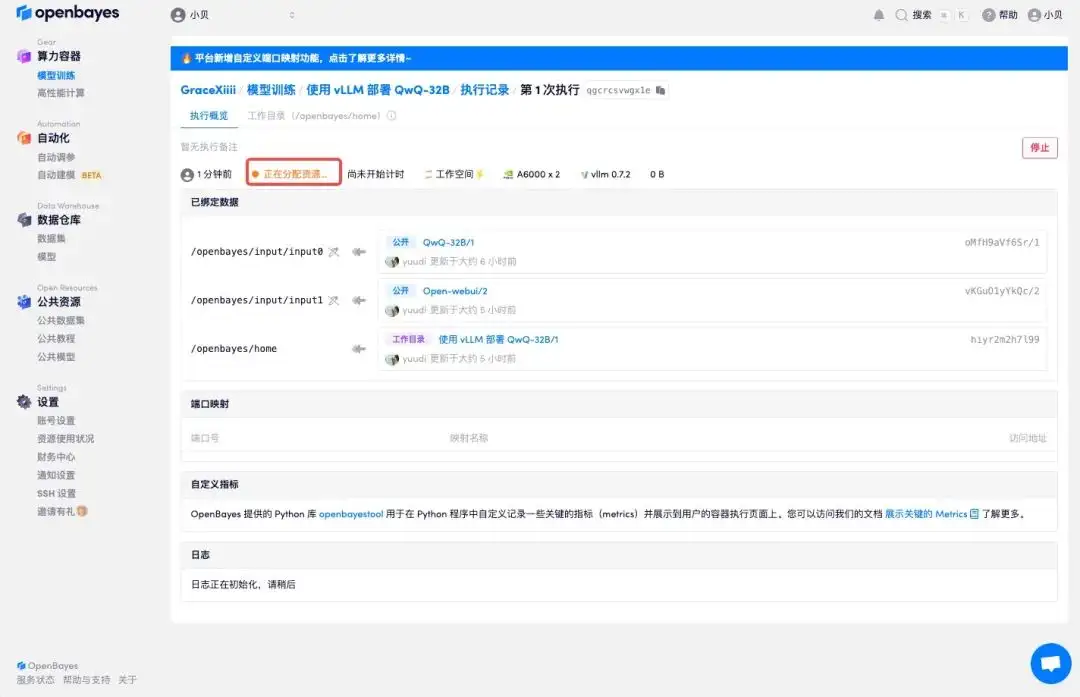

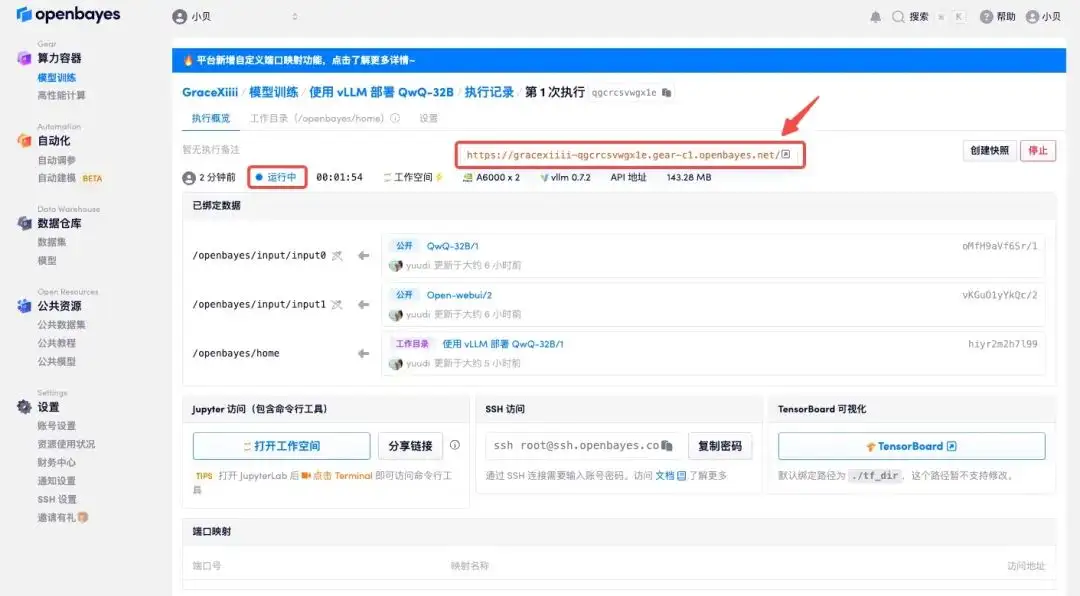

4. 리소스가 할당될 때까지 기다리세요. 첫 번째 클로닝 과정은 약 2분이 걸립니다. 상태가 "실행 중"으로 변경되면 "API 주소" 옆에 있는 점프 화살표를 클릭하여 데모 페이지로 이동합니다. API 주소 접근 기능을 이용하기 위해서는 이용자는 실명인증을 완료해야 합니다.

효과 표시

1. 온라인에서는 QwQ-32B와 DeepSeek 중 어느 것이 더 나은지에 대한 논의가 많이 있습니다. QwQ-32B에게 물어보고 어떻게 대답하는지 살펴보겠습니다.

2. QwQ-32B는 완전한 사고 과정을 보여주고 다각도에서 객관적으로 분석을 제공할 수 있음을 알 수 있습니다.