AAAI 2025에 선정되었습니다! 다중모달 의료영상의 정렬 및 융합을 실현할 수 있습니다. 국내 2대 대학, BSAFusion 공동 제안

2024년 말, 세계 최고 인공지능 학회인 제39회 AAAI 인공지능 학술대회(AAAI 2025)에서 해당 학회 논문 채택 결과가 발표되었습니다. 결국, 접수된 12,957편의 논문 중 총 3,032편이 돋보여 선정되었으며, 합격률은 23.4%에 불과했습니다.

안에,쿤밍과학기술대학교 정보공학 및 자동화학원의 Li Huafeng, Zhang Yafei, Su Dayong과 중국해양대학교 정보과학기술학과 컴퓨터과학기술학원의 Cai Qing이 공동으로 연구한 연구 프로젝트——"BSAFusion: 정렬되지 않은 의료 이미지 융합을 위한 양방향 단계별 특징 정렬 네트워크"는 AI for Science 연구자들의 주목을 받았습니다.본 주제는 최근 몇 년 동안 전례 없이 뜨거운 관심을 받고 있는 의료 영상 처리 분야에 초점을 맞추고, 양방향 단계별 특징 정렬(BSFA) 비정렬 의료 영상 융합 방법을 제안합니다.

이 연구는 통합된 처리 프레임워크 내에서 단일 단계 접근 방식을 통해 기존 방법과 비교하여 정렬되지 않은 다중 모드 의료 이미지를 동시에 정렬하고 융합하는 것을 달성했습니다. 이는 이중 작업의 조정을 달성할 뿐만 아니라, 여러 개의 독립적인 기능 인코더 도입으로 인해 발생하는 모델 복잡성 문제를 효과적으로 줄여줍니다.

공식 계정을 팔로우하고 "Multimodal Medical Images"에 답글을 남겨 전체 PDF를 받으세요.

오픈소스 프로젝트인 "awesome-ai4s"는 100개가 넘는 AI4S 논문 해석을 모아 방대한 데이터 세트와 도구를 제공합니다.

https://github.com/hyperai/awesome-ai4s

의료 초점—다중 모달 의료 이미지 융합

소위 다중모달 의료영상 융합(MMIF)CT, MRI, PET 등 다양한 영상 방법에서 얻은 의료 영상 데이터를 융합하여 더욱 포괄적이고 정확한 병변 정보가 담긴 새로운 영상을 생성하는 것입니다. 이 방향의 연구는 현대 의학과 임상 응용 분야에서 매우 가치가 있습니다.

그 이유는 간단합니다. 수십 년간의 기술 개발과 축적을 통해 의료 영상은 형태가 더욱 다양해졌을 뿐만 아니라 사용 범위도 점점 더 넓어졌습니다. 예를 들어, 사람이 심하게 넘어졌을 때 가장 먼저 생각하는 것은 병원에 가서 "엑스레이"를 찍어 골절이 있는지 확인하는 것입니다. "엑스레이 촬영"은 일반적으로 엑스레이, CT, MRI 등의 의료 영상 검사를 말합니다.

그러나 임상 의학에서 단일 의료 영상을 통해 임상 진단의 정확성을 보장할 만큼 충분한 정보를 추출하는 것만으로는 충분하지 않습니다. 특히 종양, 암세포 등과 같이 어렵고 복잡한 질병에 직면했을 때 더욱 그렇습니다. 다중 모달 의료 영상 융합은 현대 의료 영상 개발의 중요한 추세 중 하나가 되었습니다. 다중 모달 의료 영상 융합은 서로 다른 시간과 소스에서 얻은 영상을 하나의 좌표 시스템으로 통합하여 등록합니다. 이를 통해 의사의 진단 효율성이 크게 향상될 뿐만 아니라, 더욱 가치 있는 정보를 생성하여 의사가 보다 전문적인 질병 모니터링을 수행하고 효과적인 치료 계획을 제공하는 데 도움이 됩니다.

의료 영상이 응용되기 전에 많은 연구자들이 영상 융합의 문제를 인식하고 다중 소스 영상 등록 및 융합을 유명한 MURF와 같은 단일 프레임워크로 통합하는 방법을 더욱 탐구했습니다. 이는 1차원에서 영상 등록과 융합을 논의하고 해결하는 최초의 방법입니다. 핵심 모듈에는 공유 정보 추출 모듈, 다중 스케일 거친 등록 모듈, 미세 등록 및 융합 모듈이 포함됩니다.

그러나 앞서 언급했듯이, 첫째, 이러한 방법은 다중 모드 의료 영상 융합을 위해 설계되지 않았으며 의료 영상 분야에서 기대하는 이점을 보여주지 않습니다. 둘째, 이러한 방법은 다중 모드 의료 영상 융합에서 발생하는 가장 중요한 과제를 해결할 수 없습니다.융합에 사용되는 기능과 정렬에 사용되는 기능 간의 비호환성 문제.

구체적으로, 기능 정렬은 해당 기능이 일관성을 유지해야 하는 반면, 기능 융합은 해당 기능이 상호 보완적이어야 합니다.

사실, 이해하기 어렵지 않습니다. 기능 정렬은 다양한 기술적 수단을 통해 기능 수준에서 서로 다른 모달 데이터의 일치와 대응을 달성하는 것입니다. 기능 융합이란 서로 다른 모달리티 간의 상호 보완성을 최대한 활용하여 서로 다른 모달리티에서 추출한 정보를 안정적인 멀티모달 모델로 통합하는 것입니다.

그러므로 MMIF의 어려움은 상상할 수 있다. 이러한 격차는 누군가가 메워야 할 뿐만 아니라, 다중 모드 의료 영상 융합을 보다 효율적이고 편리하게 만들기 위해 기존 연구자들의 작업을 바탕으로 구축할 수 있어야 합니다. 논문에서,리화펑 교수팀과 차이칭 부교수팀은 모두 이러한 본래 의도를 표명하고 연구 실험을 통해 이를 실천에 옮겼습니다.

기술적 관점에서 볼 때, 이 방법은 혁신적인 가치를 지닌 몇 가지 디자인을 제안합니다.

* 첫째, 이 방법은 피처 인코더를 공유함으로써 정렬을 위한 추가 인코더 도입으로 인해 발생하는 모델 복잡도 증가 문제를 해결하고, 피처 교차 모달 정렬 및 융합을 통합하는 통합적이고 효과적인 프레임워크를 성공적으로 설계하여 원활한 정렬 및 융합을 달성합니다.

* 두 번째로, 모달 불일치 없는 특징 표현(MDF-FR) 방법을 통합하여 각 입력 이미지에 모달리티 특징 표현 헤드(MFRH)를 부착하여 전역적 특징 통합을 달성했습니다. 이를 통해 모달리티 차이와 다중 모달 정보 불일치가 특징 정렬에 미치는 영향을 크게 줄였습니다.

* 마지막으로, 두 지점 사이의 벡터 변위 경로의 독립성을 기반으로 하는 양방향 단계별 변형장 예측 전략이 제안되었습니다. 이는 기존의 단일 단계 정렬 방법에서 발생하는 넓은 범위와 부정확한 변형장 예측 문제를 효과적으로 해결할 수 있습니다.

BSAFusion, 의료 영상 융합을 위한 새로운 기술 방향 개척

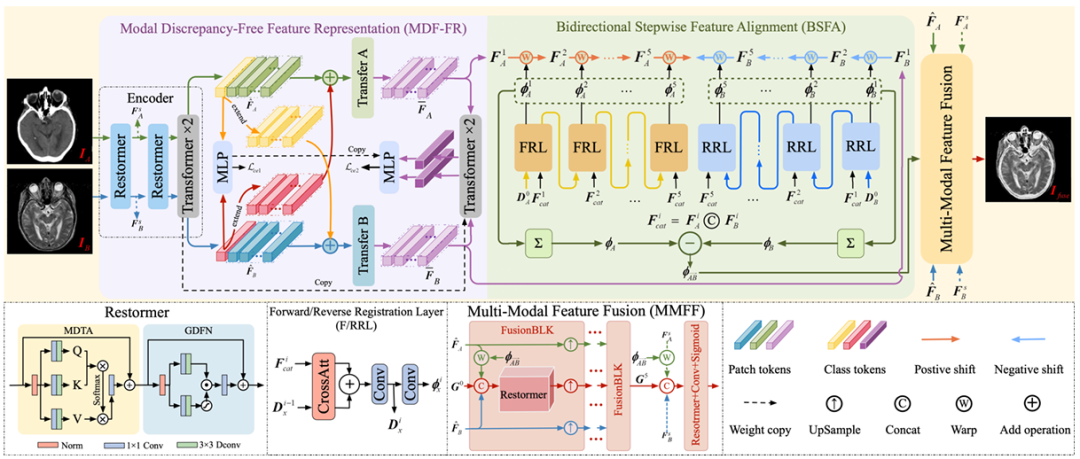

연구팀이 제안한 단일 단계 다중 모달 의료 영상 등록 및 융합 프레임워크는이는 주로 MDF-FR, BSFA, MMFF(Multi-Modal Feature Fusion)의 세 가지 핵심 구성 요소로 구성됩니다.자세한 내용은 아래 그림과 같습니다.

MDF-FR에서는 그것이 어렵지 않다는 것을 보는 것은 어렵지 않습니다.Restormer와 Transformer 레이어는 네트워크의 인코더를 형성하여 정렬되지 않은 이미지 쌍에서 기능을 추출합니다. Restormer와 Transformer는 각각 두 개의 레이어를 갖습니다. 두 가지 특징의 정렬과 융합이 끝나면, 특징은 후속 MLP에 입력되어 예측 결과를 얻습니다.

여기서 두 모드가 상당히 다르기 때문에 이러한 특징에 대한 교차 모드 매칭과 변형장 예측도 큰 어려움에 직면하게 될 것입니다. 따라서 모달리티별 특징 표현 헤드를 생성함으로써 변형장 예측에 대한 모달리티 차이의 영향을 줄이고 공유 정보 추출로 인해 공유되지 않는 정보가 손실되는 것을 방지할 수 있습니다.

이후 팀은 모드 간 차이를 없애기 위해 Transfer A와 Transfer B를 계속 사용했습니다. 각 전송 블록은 두 개의 변환기 레이어로 구성되며, 변형 지점을 예측하는 데 필요한 기능을 추가로 추출하기 위해 두 레이어 간에 매개변수가 공유되지 않습니다.

BSFA에 도착하여,연구팀은 입력 이미지의 특징을 두 방향에서 예측하기 위해 변형 필드를 설계했습니다. 이는 양방향 단계별 특징 정렬 방법입니다. 5개 계층의 변형장 예측 연산은 두 개의 입력 소스 이미지 사이에 삽입된 5개의 중간 노드에 대응하여 전방 예측과 후방 예측을 위해 설계되었습니다. 이 방법은 정렬 과정의 전반적인 견고성을 향상시킵니다. 전방 등록을 담당하는 계층은 FRL이고, 역방향 등록을 담당하는 계층은 RRL입니다.

마지막으로 MMFF 모듈에서는예측된 변형 필드가 피처를 정렬하는 데 적용된 다음 여러 개의 FusionBLK 모듈이 피처를 융합하는 데 사용됩니다. 마지막으로, 재구성 계층을 통해 융합된 이미지를 얻고, 다양한 손실 함수를 사용하여 네트워크 매개변수를 최적화합니다.

물론, 실험의 효과와 엄격성을 보장하기 위해 연구팀은 실험 세부 사항을 신중하게 준비했습니다. 이 모델을 기반으로 한 실험에서 연구팀은 기존 방법의 프로토콜을 따랐습니다.모델 학습에는 하버드의 CT-MRI, PET-MRI, SPECT-MRI 데이터 세트가 사용되었습니다.이러한 데이터 세트는 각각 144개, 194개, 261개의 엄격하게 등록된 이미지 쌍으로 구성되며, 각 객체 쌍의 크기는 256 x 256입니다.

실제 상황에서 수집된 정렬되지 않은 이미지 쌍을 시뮬레이션하기 위해 이 실험에서는 MRI 이미지를 특별히 참조로 지정하고, 강체 변형과 비강체 변형을 혼합하여 비MRI 이미지에 적용하여 필요한 훈련 세트를 생성했습니다. 또한 연구팀은 엄격하게 등록된 20쌍, 55쌍, 77쌍의 이미지에도 동일한 변형을 적용하여 정렬되지 않은 테스트 세트를 구성했습니다.

학습 과정은 종단 간 방식을 채택하여 각 데이터 세트에서 32의 배치 크기로 3,000개의 에포크를 학습합니다. 동시에 Adam 옵티마이저를 사용하여 초기 학습 속도 5 x 10⁻⁵로 모델 매개변수를 업데이트합니다. 시간이 지남에 따라 5 x 10⁻⁷로 감소하는 코사인 어닐링 학습률(LR)을 사용합니다.

실험에는 PyTorch 프레임워크가 사용되었으며 단일 NVIDIA GeForce RTX 4090 GPU에서 학습되었습니다.

연구팀의 정확한 실험 세부 사항과 훈련을 위한 표준 데이터 세트를 기반으로, 이 방법은 실험에서도 우수한 결과를 보였습니다.

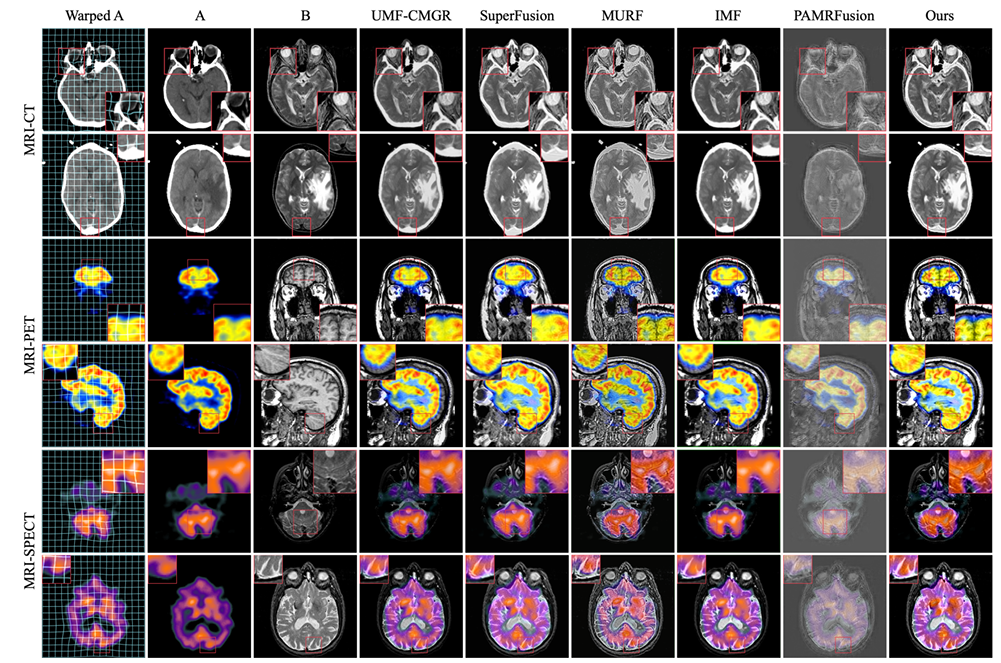

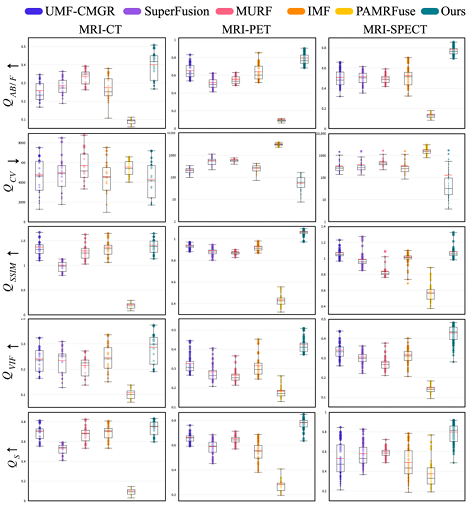

실험적 비교 대상은 UMF-CMGR, superFusion, MURF, IMF, PAMRFuse를 포함한 가장 진보된 5가지 공동 등록 방법입니다. 마지막 그룹을 제외한 처음 네 가지는 다중 모드 의료 영상 융합을 위해 특별히 설계된 것은 아니지만, 현재 가장 우수한 영상 융합 방법이며 MMIF에 적합합니다. 다음 그림과 같이:

결과는 명백합니다. 연구팀이 제안한 방법은 특징 정렬, 대비 유지, 세부 사항 유지 측면에서 더 강력한 우수성을 보였으며, 모든 지표 중에서 평균적으로 가장 좋은 성능을 보였습니다.

팀은 의료 임상 응용 프로그램을 보호하기 위해 협력합니다.

이 연구 주제의 책임 저자 중 한 명은 중국해양대학 정보과학 및 공학부 컴퓨터과학 및 기술대학의 부교수인 차이칭(Cai Qing)입니다. 그는 중국해양대학에서 근무하는 것 외에도 중국컴퓨터연맹(CCF) 등 여러 주요 학술기관에서 중요한 직책을 맡고 있습니다.

차이칭 교수의 주요 연구 분야는 딥러닝, 컴퓨터 비전, 의료 영상 처리입니다.다중 모달 의료 영상 융합은 의료 영상 처리의 하위 분야로서 강력한 전문 지식 장벽이 있지만, Cai Qing의 수년간의 경험은 이 프로젝트에 대한 지침과 도움을 제공할 수 있습니다.

작년 AAAI 2024에 선정된 논문의 제1저자로 선정된 Cai Qing 부교수가 올해에도 공동 제1저자이자 교신저자로 참여했으며, 총 3개의 연구 프로젝트가 AAAI 2025에 포함되었습니다. 여기에는 "SGTC: 희소 주석 반지도 의료 영상 분할을 위한 의미론적 기반 트리플릿 공동 학습"이라는 제목의 의료 영상 처리 연구가 포함됩니다. 본 논문에서 연구진은 의미론적으로 안내되는 3중 공동 학습 프레임워크를 제안했습니다. 이는 소수의 볼륨 샘플에서 3개의 직교 슬라이스에만 주석을 달아 신뢰할 수 있는 의료 이미지 분할을 달성하고, 시간이 많이 걸리고 노동 집약적인 이미지 주석 프로세스의 문제를 해결할 수 있습니다.

서류 주소:

https://arxiv.org/abs/2412.15526

이 프로젝트에 참여한 또 다른 팀은 쿤밍 과학기술대학교 정보공학 및 자동화 학원의 리 화펑 교수와 장 야페이 팀입니다.그중 리화펑 교수는 2021년 세계 2% 과학자 최고 과학자 목록에 선정되었습니다. 그는 주로 컴퓨터 비전, 이미지 처리 및 기타 분야의 연구에 참여하고 있습니다. 본 논문의 또 다른 책임저자인 장야페이 부교수의 주요 연구 분야는 영상 처리와 패턴 인식이며, 중국 국가자연과학기금의 여러 지역 프로젝트와 중국 윈난자연과학기금의 일반 프로젝트를 주관했습니다.

이 프로젝트의 중요한 학문적 리더 중 한 명인 리 화펑 교수는 의료 영상 처리에 대한 연구를 여러 번 발표했습니다. 2017년에는 "희소 표현에 기반한 의료 영상 융합"이라는 제목의 연구를 발표했고, 2023년에는 "적외선-가시광선 영상 융합을 위한 특징 동적 정렬 및 개선: 변환 강건 융합"이라는 제목의 연구를 발표했습니다.

서류 주소:

https://liip.kust.edu.cn/servletphoto?path=lw/00000311.pdf

서류 주소:

https://www.sciencedirect.com/science/article/abs/pii/S1566253523000519

또한, 리화펑은 장야페이 교수와 여러 차례 협력하여 관련 연구를 공동으로 발표했는데, 그 중 하나가 2022년에 공동으로 발표한 "다중 스케일 특징 학습 및 엣지 향상을 통한 의료 이미지 융합"이라는 연구입니다. 본 연구에서 연구팀은 다중 스케일 특징 학습과 에지 강화를 기반으로 한 의료 영상 융합 모델을 제안하였는데, 이는 의료 영상 융합에서 서로 다른 장기 간의 경계가 모호해지는 문제를 완화할 수 있다. 제안된 방법으로 얻은 결과는 주관적인 시각적 효과와 객관적인 양적 평가 측면에서 모두 비교 방법보다 더 우수했습니다.

서류 주소:

https://researching.cn/ArticlePdf/m00002/2022/59/6/0617029.pdf

속담에도 강력한 동맹은 흠잡을 데가 없다고 하죠. 리화펑 교수, 장야페이 팀, 그리고 차이칭 부교수의 의료 영상 처리 분야의 전문적인 학문적 역량은 의심할 여지 없이 이 프로젝트의 성공의 열쇠입니다. 우리는 앞으로도 두 당사자 간의 지속적인 협력과 과학을 위한 AI 분야에서 최첨단 연구 결과의 지속적인 발표를 기대합니다.

하이브리드 멀티모달 의료영상 융합이 트렌드로 떠오르다

다중 모드 의료 영상 융합이 점점 더 중요한 역할을 함에 따라, 기술 개발은 통합과 지능화 방향으로 나아갈 수밖에 없습니다.

이 주제에서 언급했듯이, 딥러닝을 기반으로 한 융합 방법을 연구하면서 연구자들은 CNN 기반 방법과 트랜스포머 기반 방법이 상호 보완적인 장점을 가지고 있다는 것을 발견했습니다. 따라서 일부 연구자들은 DesTrans, DFENet, MRSC-Fusion을 제안했습니다. 이러한 연구에서는 두 기술의 장점을 상호 보완하는 하이브리드 방식을 사용하여 융합 방법의 효율성을 향상시킵니다.

딥 러닝 기반 융합 방법 외에도 다중 모달 의료 영상 융합 방법에는 다중 스케일 변환, 희소 표현, 부분 공간 기반, 두드러진 특징 기반, 하이브리드 모델 등과 같은 기존 융합 방법도 포함됩니다. 마찬가지로 딥 러닝과 기존 방법을 결합한 하이브리드 접근 방식도 등장했습니다.

위의 연구 동향을 보면 다음과 같습니다.앞으로 멀티모달 의료영상 융합 방식은 딥러닝을 주류로 하고, 다양한 기술 지원을 융합하는 방향으로 발전할 것으로 예상된다.