Command Palette

Search for a command to run...

최초의 vLLM 중국어 문서가 온라인에 공개되었습니다! 최신 버전에서는 처리량이 2.7배 증가하고 대기 시간은 5배 단축되어 대규모 언어 모델 추론이 더욱 빨라졌습니다!

오늘날 대규모 언어 모델(LLM)의 개발은 규모 매개변수의 반복적 업그레이드에서 응용 프로그램 시나리오의 적응 및 혁신으로 확대되고 있습니다. 이 과정에서 여러 가지 문제점도 드러난다. 예를 들어, 추론 링크의 효율성이 낮고 복잡한 작업을 처리하는 데 시간이 오래 걸려 실시간 요구 사항이 높은 시나리오의 요구를 충족하기 어렵습니다. 리소스 활용 측면에서 모델의 규모가 크기 때문에 컴퓨팅 및 저장 리소스의 소모가 엄청나고 어느 정도 낭비가 발생합니다.

이를 고려하여,캘리포니아 대학교 버클리(UC 버클리) 연구팀은 2023년에 vLLM(가상 대규모 언어 모델)을 오픈 소스로 공개했습니다.이는 대규모 언어 모델의 추론을 가속화하기 위해 특별히 설계된 프레임워크입니다. 탁월한 추론 효율성과 자원 최적화 기능으로 전 세계적으로 널리 주목을 받았습니다.

국내 개발자들이 vLLM 버전 업데이트 및 최신 개발 내용을 보다 쉽게 접할 수 있도록,HyperAI 슈퍼 신경망이 최초의 vLLM 중국어 문서를 출시했습니다.기술적인 지식에서 실용적인 튜토리얼까지, 최첨단 트렌드에서 주요 업데이트까지, 초보자와 숙련된 전문가 모두 필요한 필수 콘텐츠를 찾을 수 있습니다.

vLLM 중국어 문서:

vLLM 추적: 오픈 소스 역사와 기술 발전

vLLM의 프로토타입은 2022년 말에 탄생했습니다. 캘리포니아 대학교 버클리의 한 연구팀이 "알파"라는 자동 병렬 추론 프로젝트를 배포했을 때, 이 프로젝트가 매우 느리게 실행되고 GPU 사용률이 낮다는 것을 발견했습니다. 연구자들은 대규모 언어 모델 추론에 최적화의 여지가 매우 크다는 사실을 잘 알고 있습니다. 하지만 대규모 언어 모델 추론에 최적화된 오픈소스 시스템이 시중에 없었기 때문에 그들은 대규모 언어 모델 추론 프레임워크를 직접 만들기로 결정했습니다.

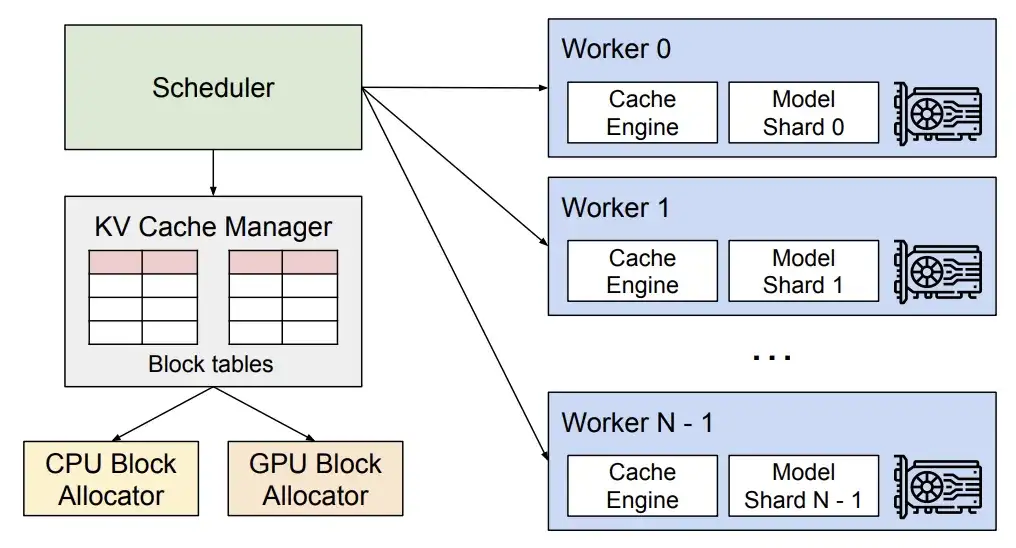

수많은 실험과 디버깅을 거쳐 그들은 운영체제의 가상 메모리와 페이징 기술에 주목했고, 이를 바탕으로 2023년에 어텐션 키와 값을 효과적으로 관리할 수 있는 선구적인 어텐션 알고리즘인 PagedAttention을 제안했습니다. 이를 바탕으로 연구진은 KV 캐시 메모리 낭비를 거의 없애는 고처리량 분산형 LLM 서비스 엔진 vLLM을 구축했습니다.대규모 언어 모델 추론에서 메모리 관리 병목 현상을 해결했습니다.Hugging Face Transformers와 비교했을 때 처리량이 24배 더 높으며, 이러한 성능 향상을 위해 모델 아키텍처를 변경할 필요가 없습니다.

더욱 언급할 가치가 있는 점은 vLLM이 하드웨어에만 국한되지 않는다는 것입니다. 이는 Nvidia GPU에만 국한되지 않고 AMD GPU, Intel GPU, AWS Neuron, Google TPU 등 시중에 나와 있는 다양한 하드웨어 아키텍처에도 적용이 가능하며, 이를 통해 다양한 하드웨어 환경에서 대규모 언어 모델의 효율적인 추론 및 적용이 진정으로 촉진됩니다. 현재 vLLM은 40개 이상의 모델 아키텍처를 지원할 수 있으며 Anyscale, AMD, NVIDIA, Google Cloud를 포함한 20개 이상의 회사로부터 지원과 후원을 받았습니다.

2023년 6월, vLLM의 오픈 소스 코드가 공식적으로 출시되었습니다. 단 1년 만에 vLLM의 Github 별점은 21.8k를 넘어섰습니다.현재 이 프로젝트는 31,000개의 별을 받았습니다.

같은 해 9월, 연구팀은 "PagedAttention을 활용한 대규모 언어 모델 제공을 위한 효율적인 메모리 관리"라는 논문을 발표하여 vLLM의 기술적 세부 사항과 장점에 대해 더욱 자세히 설명했습니다. 이 팀은 vLLM에 대한 연구를 중단하지 않았으며 호환성과 사용 편의성 등의 영역에서 반복적인 업그레이드를 계속 진행하고 있습니다. 예를 들어, 하드웨어 적응 측면에서 Nvidia GPU 외에도 vLLM은 어떻게 더 많은 하드웨어에서 실행될 수 있을까요? 예를 들어, 과학 연구에서 시스템 효율성과 추론 속도를 더욱 개선하는 방법입니다. 이러한 사항은 vLLM 버전 업데이트에도 반영됩니다.

서류 주소:

https://dl.acm.org/doi/10.1145/3600006.3613165

vLLM v0.6.4 업데이트

2.7배 더 높은 처리량과 5배 더 낮은 지연 시간

지난달에 vLLM이 버전 0.6.4로 업데이트되었는데, 이를 통해 성능 개선, 모델 지원, 멀티모달 처리 측면에서 중요한 진전이 이루어졌습니다.

성능 측면에서 새로운 버전은 다단계 스케줄링과 비동기 출력 처리를 도입했습니다.GPU 활용도를 최적화하고 처리 효율성을 높여 전반적인 처리량을 개선했습니다.

vLLM 기술 분석

* 다단계 스케줄링을 통해 vLLM은 여러 단계의 스케줄링과 입력 준비를 한 번에 완료할 수 있으므로 GPU는 각 단계에 대한 CPU 명령을 기다리지 않고도 여러 단계를 연속적으로 처리할 수 있습니다. 이를 통해 CPU 작업 부하를 분산시키고 GPU의 유휴 시간을 줄일 수 있습니다.

* 비동기 출력 처리를 통해 모델 실행과 병렬로 출력 처리를 수행할 수 있습니다. 구체적으로, vLLM은 더 이상 출력을 즉시 처리하지 않고 대신 처리를 지연시켜서 n+1단계를 실행하는 동안 n단계의 출력을 처리합니다. 이로 인해 요청당 단계가 하나 더 늘어날 수 있지만, GPU 활용도가 크게 향상되어 이러한 비용을 충분히 상쇄할 수 있습니다.

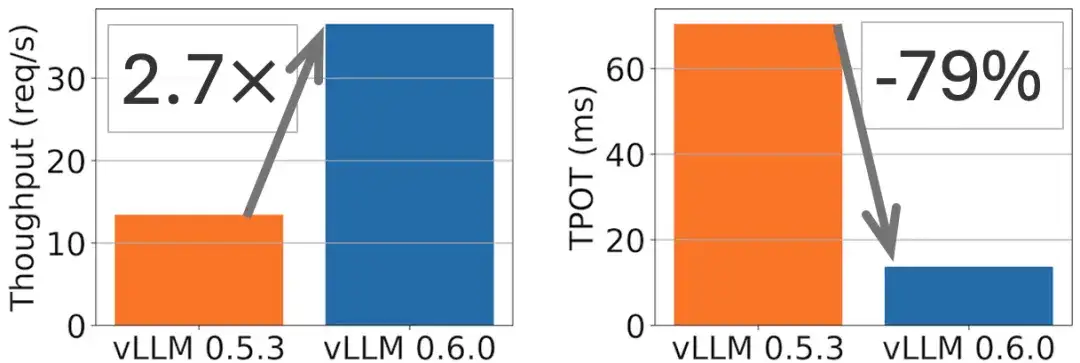

예를 들어, 다음 그림에서 볼 수 있듯이 Llama 8B 모델에서는 처리량이 2.7배 향상되고 TPOT(Token Per Output Time)는 5배 감소합니다.

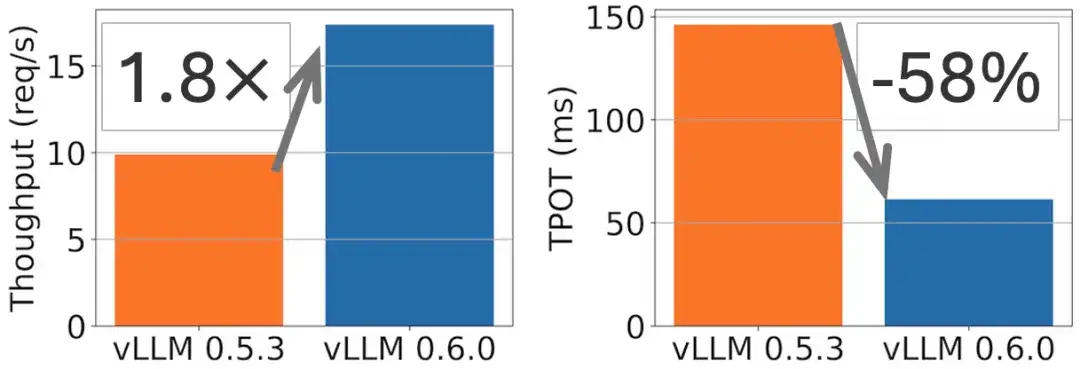

다음 그림에서 볼 수 있듯이 Llama 70B 모델에서는 처리량이 1.8배 향상되고 TPOT는 2배 감소했습니다.

모델 지원 측면에서 vLLM은 Exaone, Granite, Phi-3.5-MoE와 같은 최첨단 대규모 언어 모델에 대한 새로운 적응 기능을 통합했습니다. 멀티모달 분야에서는 다중 이미지 입력 기능이 추가되었고(공식 문서에서는 Phi-3-vision 모델을 예로 사용함), Ultravox의 다중 오디오 블록을 처리할 수 있는 기능이 추가되어 멀티모달 작업에서 vLLM의 적용 범위가 더욱 확장되었습니다.

vLLM 중국어 문서의 첫 번째 완전한 버전이 온라인에 있습니다.

vLLM이 대규모 모델 분야의 중요한 기술 혁신으로서 효율적 추론의 현재 개발 방향을 나타낸다는 점에는 의심의 여지가 없습니다. 국내 개발자들이 그 이면에 있는 첨단 기술 원리를 보다 편리하고 정확하게 이해할 수 있도록 vLLM을 국내 대형 모델 개발에 도입하여 이 분야의 발전을 촉진할 것입니다. HyperAI 커뮤니티 자원봉사자들은 공개 협업과 번역 및 교정의 이중 검토를 통해 최초의 vLLM 중국어 문서를 성공적으로 완성했습니다.이제 hyper.ai에서 완전히 출시되었습니다.

vLLM 중국어 문서:

vLLM 이 문서는 다음을 제공합니다.

* 기본 개념부터 처음부터

* 빠른 시작 원클릭 복제 튜토리얼

* 적시에 업데이트된 vLLM 지식 기반

* 친절하고 개방적인 중국인 커뮤니티 생태

오픈소스 브릿지 구축:

TVM, Triton 및 vLLM 커뮤니티 공동 구축 여정

2022년 HyperAI는 중국 최초의 Apache TVM 중국어 문서를 출시했습니다. (원문을 보려면 클릭하세요: TVM 중국어 웹사이트가 공식 출시되었습니다! 가장 포괄적인 머신러닝 모델 구축 "참고서"가 여기 있습니다)국내 칩의 급속한 발전에 따라, 우리는 국내 컴파일러 엔지니어들에게 TVM을 이해하고 학습할 수 있는 인프라를 제공합니다.동시에 우리는 아파치 TVM PMC인 펑시위안 박사와 다른 사람들과 협력하여 중국에서 가장 활동적인 TVM 중국인 커뮤니티를 형성했습니다.온라인과 오프라인 활동을 통해 우리는 천 명이 넘는 칩 개발자와 컴파일러 엔지니어를 포함하여 국내 주요 칩 제조업체의 참여와 지원을 얻었습니다.

TVM 중국어 문서 주소:

2024년 10월, 트리톤 중국어 웹사이트를 출시했습니다. (원본 텍스트를 보려면 클릭하세요: 최초의 완전한 트리톤 중국어 문서가 온라인에 공개되었습니다! GPU 추론 가속의 새로운 시대를 열다)AI 컴파일러 커뮤니티의 기술적 경계와 콘텐츠 범위를 더욱 확장합니다.

Triton 중국어 문서 주소:

AI 컴파일러 커뮤니티를 구축하는 여정에서 우리는 모든 사람의 목소리에 귀를 기울이고 업계 동향을 주시해 왔습니다. vLLM 중국어 설명서를 출시한 이유는 대규모 모델의 급속한 개발로 인해 vLLM 사용에 대한 사람들의 관심과 수요가 증가하고 있다는 것을 확인했기 때문입니다. 우리는 개발자들을 위한 학습, 소통, 협력을 위한 플랫폼을 제공하고, 중국 내에서 최첨단 기술의 대중화와 개발을 공동으로 촉진하고자 합니다.

TVM, Triton, vLLM 중국어 문서의 업데이트와 유지관리는 중국어 커뮤니티를 구축하는 데 있어 우리의 기본 작업입니다. 앞으로 더욱 개방적이고 다양하며 포용적인 AI 오픈소스 커뮤니티를 구축하기 위해 더 많은 파트너가 참여하기를 기대합니다!

vLLM 중국어 문서 전체를 보려면 여기를 클릭하세요.

GitHub vLLM 중국어:

https://github.com/hyperai/vllm-cn

이번 달, HyperAI는 상하이에서 Meet AI Compiler라는 오프라인 기술 교류 회의를 개최할 예정입니다. QR 코드를 스캔하고 "AI 컴파일러"에 댓글을 남겨주시면 이벤트 그룹에 가입하여 최대한 빨리 이벤트에 대한 관련 정보를 받아보실 수 있습니다.

참고문헌:

1.https://blog.vllm.ai/2024/09/05/perf-update.html