ECCV 2024에 선정되었습니다! MIT는 54,000개 이상의 이미지를 포괄하는 의료 이미지 분할을 위한 일반 모델인 ScribblePrompt를 제안했으며 이는 SAM보다 성능이 뛰어납니다.

일반인은 흥분을 지켜보지만, 전문가는 세부 사항을 지켜본다. 이 문장은 의료 영상 분야에서는 절대적인 진실입니다. 그뿐 아니라, 전문가라도 엑스레이, CT 스캔, MRI 등 복잡한 의료 영상 속의 '비결'을 정확하게 파악하기는 쉽지 않습니다. 의료 영상 분할은 복잡한 의료 영상에서 특별한 의미를 지닌 특정 부분을 분리하고 관련 특징을 추출하는 것으로, 의사가 환자에게 보다 정확한 진단과 치료 계획을 제공하는 데 도움을 주고, 과학 연구자가 병리학 연구를 수행할 수 있는 보다 신뢰할 수 있는 기반을 제공합니다.

최근 컴퓨터와 딥러닝 기술의 발전으로의료 영상 분할 방법은 수동 분할에서 자동 분할로 점차 가속화되고 있으며, 훈련된 AI 시스템은 의사와 연구자에게 중요한 도움이 되고 있습니다.그러나 의료 이미지 자체의 복잡성과 전문성으로 인해 시스템 학습 작업의 상당 부분은 여전히 숙련된 전문가가 수동으로 세분화하고 학습 데이터를 생성하는 데 의존하고 있는데, 이는 시간이 많이 걸리고 노동 집약적인 과정입니다. 동시에 기존의 딥러닝 기반 분할 방법 역시 실제로 적용성 문제, 유연한 상호작용 요구 사항 등 많은 과제에 직면했습니다.

기존의 대화형 분할 시스템이 실제 적용에 있어 갖는 한계를 해결하기 위해, 매사추세츠 공과대학 컴퓨터 과학 및 인공지능 연구소(MIT CSAIL)의 한 팀은 매사추세츠 종합병원과 하버드 의대의 연구자들과 협력하여 얼굴을 식별하고 분할하는 데 사용할 수 있는 새로운 대화형 분할 시스템을 개발했습니다.우리는 ScribblePrompt라는 신경망 기반 분할 도구를 사용하여 대화형 생물의학 이미지 분할을 위한 일반 모델을 제안합니다. 이 도구는 낙서, 클릭, 경계 상자와 같은 다양한 주석 방법을 사용하는 주석자를 지원하여 훈련되지 않은 레이블과 이미지 유형에 대해서도 생물의학 이미지 분할 작업을 유연하게 수행합니다.

"ScribblePrompt: 모든 생물의학 이미지를 위한 빠르고 유연한 대화형 분할"이라는 제목의 연구는 국제적으로 유명한 학술 플랫폼인 arXiv에 포함되었고, 최고의 국제 학술 회의인 ECCV 2024에서 채택되었습니다.

연구 하이라이트:

* 특히 훈련되지 않은 레이블 및 이미지 유형에 대해 기존 최첨단 모델보다 우수한 성능을 발휘하여 모든 생의학 이미지 분할 작업을 빠르고 정확하게 수행합니다.

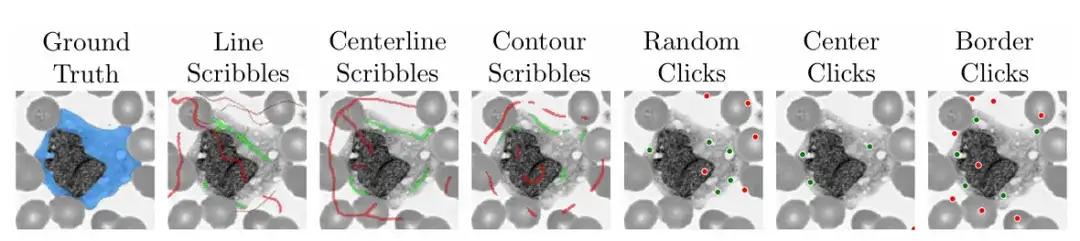

* 낙서, 클릭, 경계 상자 등 유연하고 다양한 주석 스타일을 제공합니다.

* 더 높은 계산 효율성으로 단일 CPU에서도 빠른 추론이 가능

* 도메인 전문가를 대상으로 한 사용자 연구에서 이 도구는 SAM에 비해 주석 시간을 28% 단축했습니다.

서류 주소:

https://arxiv.org/pdf/2312.07381

MedScribble 데이터 세트 다운로드 주소:

HyperAI Super Neural Tutorial 섹션에서 "ScribblePrompt 의료 이미지 분할 도구"가 출시되었습니다. 한 번의 클릭으로 복제를 시작할 수 있습니다. 튜토리얼 주소는 다음과 같습니다.

대규모 데이터 세트, 모델 학습 및 성능 평가에 대한 포괄적인 범위

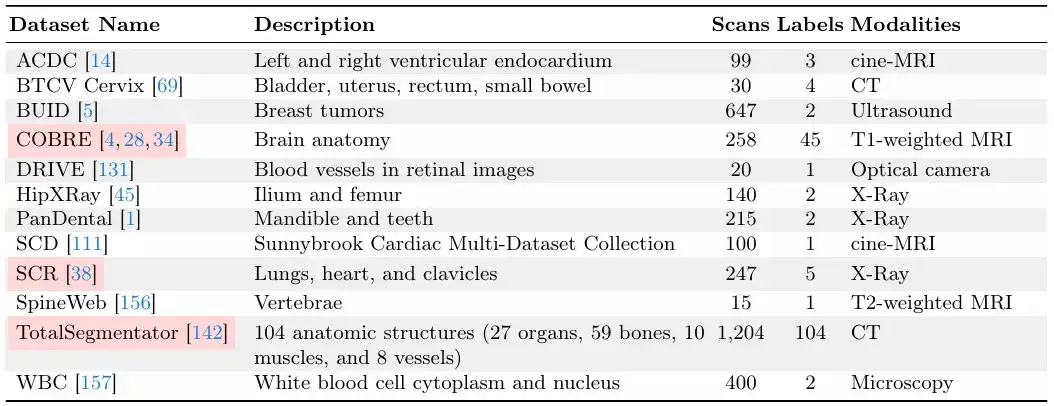

이 연구는 54,000개의 스캔, 16개의 이미지 유형, 711개의 레이블을 포함하는 77개의 오픈 액세스 생물의학 영상 데이터 세트를 수집하여 교육 및 평가를 실시하는 MegaMedical과 같은 대규모 데이터 세트 수집 노력을 기반으로 합니다.

이러한 데이터 세트 이미지는 눈, 흉부, 척추, 세포, 피부, 복부 근육, 목, 뇌, 뼈, 치아 및 병변 스캔을 포함한 다양한 생물의학 분야를 포괄합니다. 이미지 유형에는 현미경, CT, X선, MRI, 초음파 및 사진이 포함됩니다.

훈련과 평가의 구분에 있어서,연구팀은 77개의 데이터 세트를 65개의 훈련 데이터 세트와 12개의 평가 데이터 세트로 나누었습니다.12개의 평가 데이터셋 중 9개의 평가 데이터셋의 데이터는 모델 개발, 모델 선정 및 최종 평가에 사용되었으며, 나머지 3개의 평가 데이터셋의 데이터는 최종 평가에만 사용되었습니다.

각 데이터 세트는 아래 그림에서 볼 수 있듯이 6:2:2의 비율로 훈련 세트, 검증 세트, 테스트 세트로 나뉩니다.

다음 두 그림은 "검증 및 테스트 데이터 세트"와 "훈련 데이터 세트"입니다.그 중 "검증 및 테스트 데이터 세트"는 ScribblePrompt 모델 학습 중에는 보이지 않습니다.

연구팀은 데이터 세트의 상대적 크기를 고려하여 각 데이터 세트에 고유한 수의 스캔이 포함되도록 했습니다.

빠른 추론을 위한 효율적인 아키텍처, 실용적인 세분화 도구 구축

연구팀은 새로운 생물의학 영상 분야와 관심 영역으로 확장이 가능한, 실용적 적용성이 뛰어난 유연하고 상호작용적인 분할 방법을 제안했습니다.

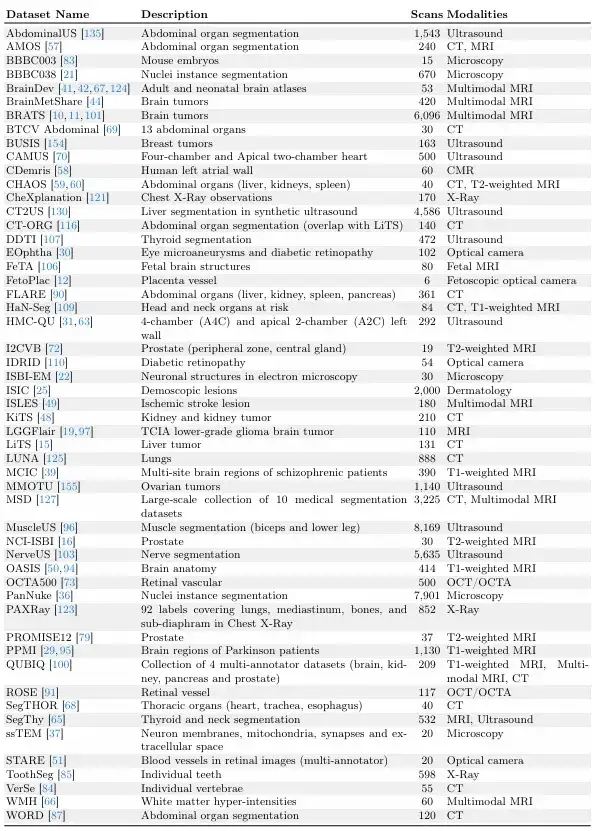

연구팀은 아래 그림에서 보듯이 훈련 중에 상호작용 분할을 시뮬레이션하는 순차적 단계를 시연했습니다. 입력에는 이미지 분할 쌍 (xᵗ,yᵗ)이 주어집니다. 팀은 먼저 경계 상자, 클릭 또는 낙서 등을 포함할 수 있는 초기 상호작용 세트 u₁를 시뮬레이션한 다음, 초기값을 0으로 설정하여 예측의 첫 번째 단계로 들어갑니다. 두 번째 단계에서 팀은 오차 영역에서 이전 예측을 시뮬레이션하고 시뮬레이션 보정 후 초기 상호작용 세트에 추가하여 u₂를 구합니다. 이를 반복하면 일련의 예측이 생성됩니다.

모델의 실용성과 사용 편의성을 보장하기 위해,연구팀은 또한 훈련 중에 이 알고리즘을 사용하여 의료 이미지의 다양한 영역에 낙서, 클릭, 경계 상자 입력 방법에 대한 실제 시나리오를 시뮬레이션했습니다.

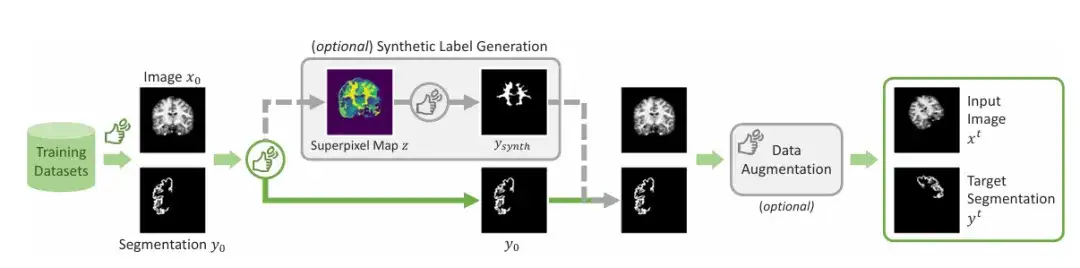

일반적으로 표시된 영역 외에도연구팀은 합성 라벨을 생성하는 메커니즘을 도입했습니다.슈퍼픽셀 알고리즘을 적용하여 잠재적인 합성 레이블 맵을 생성한 다음 레이블을 샘플링하여 그림에 표시된 "Ysynth"를 생성하고 마지막으로 무작위 데이터 증가를 적용하여 최종 결과를 얻습니다. 이 접근 방식은 비슷한 값을 가진 이미지 부분을 찾은 다음 의학 연구자에게 흥미로울 수 있는 새로운 영역을 식별하고 ScribblePromt를 훈련하여 이를 분할하는 방식으로 작동합니다. 아래 그림과 같습니다.

이 연구 프레젠테이션에서는 주로 두 가지 네트워크 아키텍처를 사용하여 설명합니다. 하나는 UNet과 유사한 효율적인 완전 합성 아키텍처를 사용하여 ScribblePrompt를 시연하는 것이고, 다른 하나는 시각적 변환 아키텍처를 사용하여 ScribblePrompt를 시연하는 것입니다.

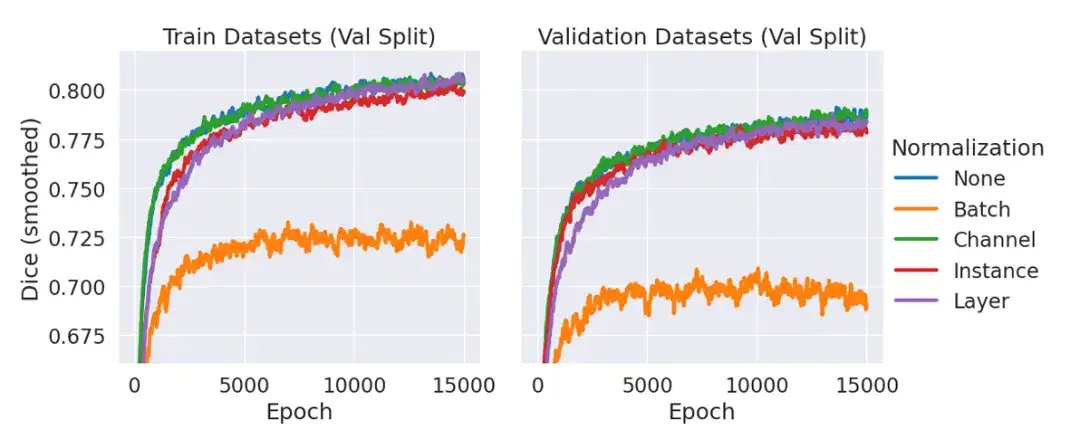

이 중 ScribblePrompt-UNet은 8개 계층의 CNN을 사용하고 배치 정규화가 없는 인기 있는 UNet 아키텍처와 유사한 디코더 구조를 따릅니다. 각 합성곱 계층은 192개의 특징을 가지고 있으며 PReLu 활성화를 사용합니다. 정규화 계층이 없는 이유는 예비 실험에서 정규화를 포함하더라도 정규화 계층을 사용하지 않은 경우와 비교했을 때 검증 데이터의 평균 주사위가 개선되지 않는다는 것을 팀이 발견했기 때문입니다(아래 그림 참조).

ScribblePrompt-SAM은 최소 SAM 모델 ViT-b를 채택하고 디코더를 미세 조정합니다. SAM 아키텍처는 단일 마스크 모드 또는 다중 마스크 모드에서 예측을 수행할 수 있으며, 이 경우 디코더는 입력 이미지와 사용자 상호 작용이 주어지면 단일 예측 분할을 출력합니다. 멀티 마스크 모드에서 디코더는 3가지 가능한 분할을 예측한 다음 MLP 출력을 통해 가장 높은 IoU를 갖는 분할을 예측합니다. 아키텍처의 표현력을 극대화하기 위해 멀티 마스크 모드에서 ScribblePrompt-SAM을 훈련하고 평가합니다.

ScribblePrompt는 기존 방법보다 우수함을 입증합니다.

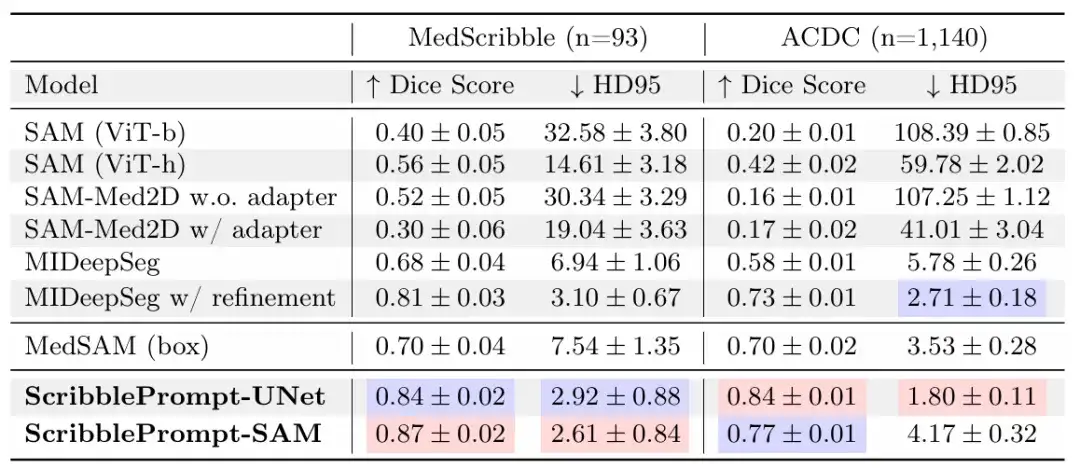

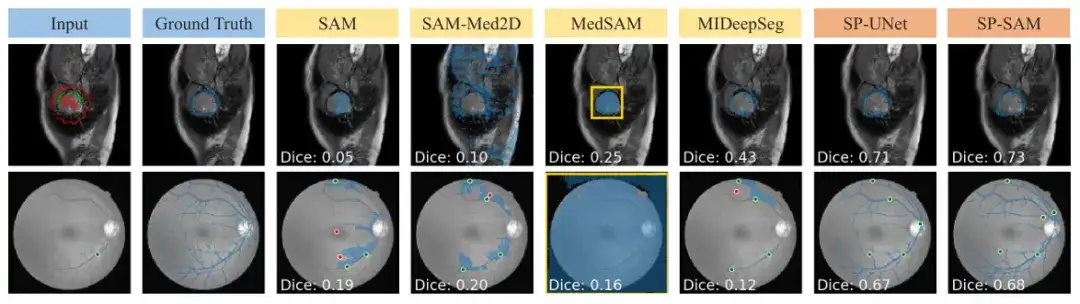

이 연구에서 연구팀은 수동 스크리블 실험, 시뮬레이션된 상호작용, 경험이 풍부한 주석을 사용한 사용자 연구를 통해 ScribblePrompt-UNet과 ScribblePrompt-SAM을 SAM, SAM-Med2D, MedSAM, MIDeepSeg 등 기존의 최첨단 방법과 비교했습니다.

수동 그래피티 실험에서,결과는 ScribblePrompt-UNet과 ScribblePrompt-SAM이 실험적 수동 스크리블 데이터 세트와 ACDC 스크리블 데이터 세트의 단일 단계 수동 스크리블에서 가장 정확한 분할을 생성한다는 것을 보여줍니다(아래 표 참조).

SAM과 SAM-Med 2D는 훈련되지 않았기 때문에 낙서 입력으로 원활하게 일반화할 수 없습니다. MedSAM은 SAM 아키텍처를 사용하여 다른 SAM 베이스라인보다 예측 성능이 뛰어나지만, 부정적인 스크리블을 활용할 수 없어 아래 그림에서 볼 수 있듯이 홀이 있는 분할을 놓치는 경우가 많습니다. 또한 MIDeepSeg 네트워크의 초기 예측은 좋지 않지만 개선 과정을 적용한 후에는 개선되었습니다.

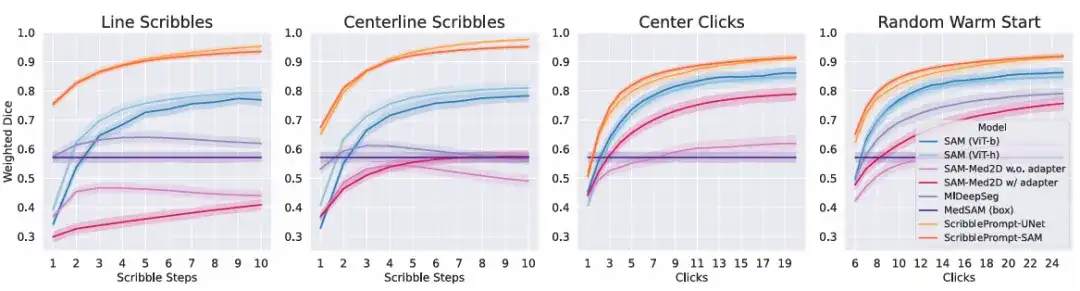

시뮬레이션된 상호작용 실험에서,결과에 따르면 모든 상호작용 시간에 대한 모든 시뮬레이션 상호작용 과정에서 ScribblePrompt의 두 버전 모두 기준 방법보다 우수성이 나타났습니다. 아래 그림과 같습니다.

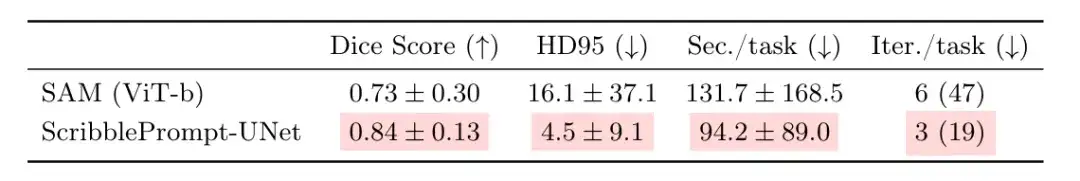

ScribblePrompt의 실제 유용성을 더욱 평가하려면해당 팀은 경험이 풍부한 주석 작성자들을 대상으로 사용자 연구를 수행했습니다.이번 비교는 ScribblePrompt-UNet과 위의 클릭 실험에서 가장 높은 주사위 점수를 얻은 SAM(Vit-b) 간의 비교입니다. 결과는 아래 표에서 볼 수 있듯이 참가자들이 ScribblePrompt-UNet을 사용했을 때 더 정확한 세분화를 생성했다는 것을 보여주었습니다. 한편, ScribblePrompt-UNet을 사용하면 각 세분화에 평균 1.5분이 소요되는 반면, SAM을 사용하면 세분화당 2분이 넘었습니다.

16명의 참가자는 ScribblePrompt를 사용하면 SAM보다 타겟 세분화가 더 쉽다고 보고했으며, 15명은 ScribblePrompt를 사용하는 것을 선호한다고 답했고, 나머지 참가자는 선호도가 없다고 답했습니다. 또한, 참여자의 93.8%는 ScribblePrompt가 낙서 수정에 대한 해당 세그먼트를 개선했기 때문에 SAM 기준선보다 ScribblePrompt를 선호했으며, 참여자의 87.5%는 클릭 기반 편집을 위해 ScribblePrompt를 사용하는 것을 선호했습니다.

위의 결과는 참가자들이 ScribblePrompt를 선호하는 가장 일반적인 이유, 즉 자기 교정과 풍부한 대화형 기능을 다시 한번 확인시켜 주었습니다. 다른 방법으로는 불가능합니다. 예를 들어, 망막 정맥 분할의 경우 SAM은 여러 번 수정하더라도 정확한 예측을 내리는 데 어려움이 있습니다.

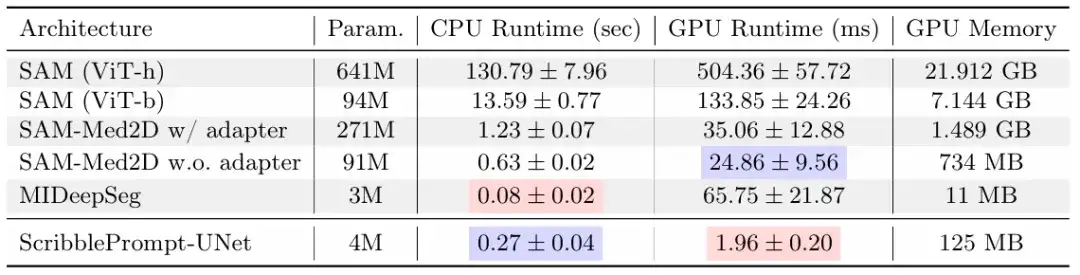

또한, ScribblePrompt는 비용이 저렴하고 배포가 쉽다는 장점도 있습니다. 연구 결과, ScribblePrompt-UNet은 단일 CPU에서 예측당 0.27초만 걸리고 오류는 0.04초 미만인 것으로 나타났습니다. 위 그림에서 볼 수 있듯이 GPU는 Nvidia Quatro RTX8000 GPU입니다. SAM(Vit-h)이 CPU에서 예측당 2분 이상 걸리는 반면, SAM(Vit-b)은 예측당 약 14초가 걸립니다. 이는 의심할 여지 없이 이 모델이 자원이 매우 부족한 환경에도 적용 가능하다는 것을 보여줍니다.

의료진과 연구원들을 시간 소모적이고 노동 집약적인 작업에서 해방시켜줍니다.

인공지능은 오랫동안 이미지 분석 및 기타 고차원 데이터 처리 분야에서 큰 잠재력을 보여왔습니다. 생물학적 영상 분석 및 처리에서 가장 흔한 작업인 의료 영상 분할은 자연스럽게 인공지능 활용을 위한 중요한 테스트 분야 중 하나가 되었습니다.

이 연구 외에도,기사에서 언급했듯이 SAM은 최근 몇 년 동안 관련 과학 연구팀의 가장 많은 관심을 끈 주요 도구 중 하나이기도 합니다.HyperAI는 이전에 다음과 같은 관련 문제에 대한 후속 연구를 수행했습니다. SAM 2의 최신 애플리케이션이 출시되었습니다! 옥스퍼드 대학교 팀이 Medical SAM 2를 출시하여 SOTA 의료 영상 분할 목록을 새롭게 업데이트했습니다.옥스퍼드 대학 연구팀은 논문에서 의료 이미지 분할에 있어서 SAM의 잠재력을 발견한 내용을 공유했습니다.

이 연구에서는 옥스퍼드 대학의 팀이 개발한 Medical SAM 2라는 의료 이미지 분할 모델을 소개했습니다. SAM 2 프레임워크를 기반으로 설계된 이 솔루션은 의료 영상을 비디오로 처리하여 3D 의료 영상 분할 작업에 탁월할 뿐만 아니라 새로운 단일 프롬프트 분할 기능도 제공합니다. 사용자는 새로운 특정 객체에 대한 힌트만 제공하면 되고, 후속 이미지에서 유사한 객체의 분할은 추가 입력 없이 모델에 의해 자동으로 완료됩니다.

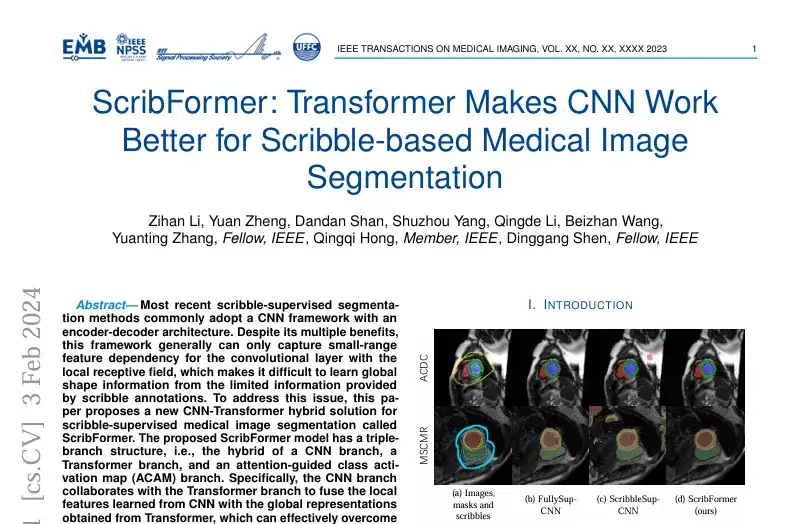

틀림없이,SAM 외에도 딥러닝을 기반으로 한 의료 영상 분할 방법에 대한 연구가 많이 있습니다.예를 들어, "Scribformer: Transformer를 이용한 Scribble 기반 의료 이미지 분할을 위한 CNN의 성능 향상"이라는 제목의 연구는 국제적으로 유명한 저널이자 잡지인 IEEE Transactions on Medical Imaging에 포함되었습니다.

이 연구는 샤먼 대학, 베이징 대학, 홍콩 중국 대학, 상하이 기술 대학, 영국의 헐 대학을 포함한 여러 기관의 연구진으로 구성된 팀에 의해 발표되었습니다.이 연구에서는 ScribFormer라 불리는 그래피티 감독 의료 이미지 분할을 위한 새로운 CNN-Transformer 하이브리드 솔루션을 제안했습니다.

간단히 말해서, MIT의 연구 결과이든, SAM에 기반한 혁신이든, 아니면 다른 새로운 방법이든 목적은 모두 같습니다. 속담에도 '모든 길은 로마로 통한다'고 했잖아요. 의료 분야에 인공지능을 적용하는 것은 의학과 사회에 이롭습니다.

ScribblePrompt 논문의 주저자이자 MIT 박사과정 학생인 Hallee E Wong은 다음과 같이 말했습니다."우리는 상호작용 시스템을 통해 의료 종사자의 노력을 대체하는 것이 아니라 증강하고 싶습니다."

참고문헌:

1.https://news.mit.edu/2024/scribbleprompt-helping-doctors-annotate-medical-scans-0909

2.https://arxiv.org/pdf/2312.0738