Command Palette

Search for a command to run...

Llama 3.2가 출시되었습니다! 멀티모달, 오픈 소스입니다! 황인순, AR 안경 최초 체험, 퀘스트 3S 헤드셋 가격 터무니없이 저렴

OpenAI의 ChatGPT가 "100 Model Wars"를 시작했다면,메타의 레이밴 메타 스마트 안경은 의심할 여지 없이 "백개의 거울 전쟁"을 촉발한 도화선이었습니다.Ray-Ban Meta는 작년 9월 Meta Connect 2023 개발자 컨퍼런스에서 데뷔한 이후 단 몇 개월 만에 100만 장 이상 판매되었습니다.마크 주커버그"어메이징"이라는 이름으로 구글, 삼성, 바이트댄스 등 국내외 주요 기업들이 이 시장에 참여하게 되었습니다!

1년 후, Meta는 Connect Developer Conference에서 다시 한번 새로운 스마트 안경 제품인 Orion을 출시했습니다.이것은 이 회사 최초의 홀로그램 AR 안경입니다.주커버그는 이 안경을 미래에 사람들이 세상과 상호작용하는 방식을 바꿀 세계에서 가장 진보된 안경이라고 불렀습니다.

또한, Meta는 평소처럼 Connect 컨퍼런스에서 새로운 Quest 헤드셋 제품을 출시해 왔으며, 올해도 예외는 아니었습니다. 작년에 Meta가 출시된 것을 감안하면 퀘스트 3 사용자들은 일반적으로 가격이 너무 비싸다고 불평합니다.올해 Meta는 Quest 3와 비슷한 성능을 제공하지만 가격이 더 저렴한 새로운 헤드셋 Quest 3S를 출시했습니다.이 헤드셋은 현재 시중에서 가장 뛰어난 혼합 현실 기기로 간주되며, 탁월한 하이퍼 현실 경험을 제공합니다.

물론, Meta의 가장 기대되는 핵심 기술 중 하나인 Llama 모델 역시 이번 기자 회견에서 대규모 업데이트를 거쳤습니다.다중 모드 Llama 3.2는 이미지와 텍스트를 모두 이해할 수 있으며, 모바일 폰에서도 대형 모델을 실행할 수 있어 오픈 소스 생태계에 더 많은 이점을 제공합니다.

메타의 AR 꿈이 현실이 되다, 오리온 안경이 상호작용의 새로운 시대를 열다

올해 4월, Reality Labs의 10주년을 기념하여 Meta는 부서의 개발 역사를 간략하게 설명하는 기사를 게재하고 다음 핵심 제품인 최초의 AR 안경을 미리 선보였습니다. Meta는 Quest 3를 통해 사용자가 물리적 세계에서 디지털 콘텐츠와 몰입적으로 상호 작용할 수 있고, Ray-Ban Meta 안경을 통해 사용자는 Meta AI의 실용성과 엔터테인먼트를 즐길 수 있으며, 새로운 AR 안경은 두 가지의 장점을 결합하여 최고의 기술 융합을 이룰 것이라고 밝혔습니다.

Meta Connect 2024가 다가오면서, 시장에서는 이 컨퍼런스에서 AR 안경이 출시될 것이라는 추측이 점점 더 많아지고 있습니다. 예상대로,오늘 Meta는 첫 번째 AR 안경인 Orion을 출시했습니다.

주커버그는 오리온이 사람들이 세상과 상호작용하는 방식을 바꾸는 데 전념하고 있다고 말했습니다. 이는 역대 가장 진보된 AR 안경으로, 개발하는 데 10년이 걸렸습니다. 가장 진보된 AR 디스플레이, 맞춤형 실리콘 칩, 실리콘 카바이드 렌즈, 복잡한 광파도관, uLED 프로젝터 등을 갖추고 있습니다.여러 기술을 결합하면 MR 헤드셋에 비해 전력과 무게가 훨씬 적으면서도 강력한 AR 경험을 안경 한 쌍으로 구현할 수 있습니다.

간단히 말해서,이 AR 안경은 새로운 디스플레이 아키텍처를 사용합니다.사용피코 프로젝터빛은 광파관에 투사되고, 그 다음에 다양한 깊이와 크기가홀로그램세상이 사용자 앞에 투사되고 안경의 관자놀이에 장착된 배터리로 전원을 공급받습니다. 예를 들어, 사용자가 멀리 떨어진 친구를 만나고 싶어하면 마치 그 자리에 있는 것처럼 홀로그램으로 거실에 나타납니다.

Orion의 경우 프레임 가장자리에 7개가 내장되어 있다는 점이 언급할 가치가 있습니다.미니 카메라음성, 눈, 제스처 추적 기능을 갖춘 센서와 EMG 손목 밴드가 장착되어 있어 사용자는 쉽게 스와이프, 클릭, 스크롤을 할 수 있습니다. 예를 들어, 아침 달리기 중에 사진을 찍고 싶다면 오리온은 손가락을 한 번 탭하기만 하면 그 순간을 정지시켜줍니다. 또한, 손가락만 탭하면 카드 게임, 체스, 홀로그램 탁구 등의 엔터테인먼트를 불러올 수 있습니다.

엔비디아의 창립자이자 CEO 젠쉰 황꼭 시도해보고 싶어요!

최고의 혼합 현실 기기: Quest 3S, 가성비 최고

작년 Connect 컨퍼런스에서 Meta가 세계 최초의 혼합 현실 헤드셋인 Meta Quest 3를 발표한 이후,Meta는 올해 Quest 3의 간소화된 버전인 Quest 3S를 출시했습니다.

주커버그는 말했다,"Quest 3S는 가격 대비 가치가 뛰어날 뿐만 아니라, 시중에서 구입할 수 있는 최고의 혼합 현실 기기입니다!"Quest 3와 비슷한 핵심 기능, 즉 고해상도, 풀컬러 혼합 현실을 갖추고 있어 사용자가 실제 세계와 가상 세계를 "원활하게 이동"하고 엔터테인먼트, 피트니스, 게임, 소셜 경험 등 다양한 활동에 참여할 수 있습니다. 차이점은 Quest 3S가 렌즈를 개선하고 기술 스택, 효과적인 해상도와 지연 시간을 최적화했으며, 혼합 현실 손 추적 소프트웨어의 성능이 더 뛰어나다는 것입니다.

혼합 현실의 매력은 현실적인 공간을 제공한다는 것입니다.메타버스사용자에게 몰입감을 제공하고 다양한 경험을 자유롭게 전환할 수 있게 해줍니다. 예를 들어, 사용자는 영화 모드를 선택하여 화면을 영화관처럼 확대하고 최고의 영화관 시청 경험을 얻을 수 있습니다.

라이브 데모에서 Zuckerberg는 사용자가 화면을 열고 어디에나 놓아 거대한 화면을 형성할 수 있는 2D 모바일 앱에서 원격 데스크톱 PC로의 몰입형 경험을 보여주었습니다.가상 디스플레이, 그리고 일을 합니다. 그는 Meta가 Microsoft와 협력하여 원격 데스크톱 기능을 업그레이드하고 있으며, 곧 Windows 11 컴퓨터에 연결할 수 있게 될 것이라고 언급했습니다.

Meta Quest 3S는 믿을 수 없는 가격으로 매우 사실적인 경험을 제공하며, 가격은 단 299.99달러부터 시작하며 10월 15일에 출시될 예정입니다. 이번 가을에 구매하세요 퀘스트 3S 사용자는 또한 게임 '배트맨: 아캄 섀도우'의 무료 VR 체험을 받을 수 있습니다.

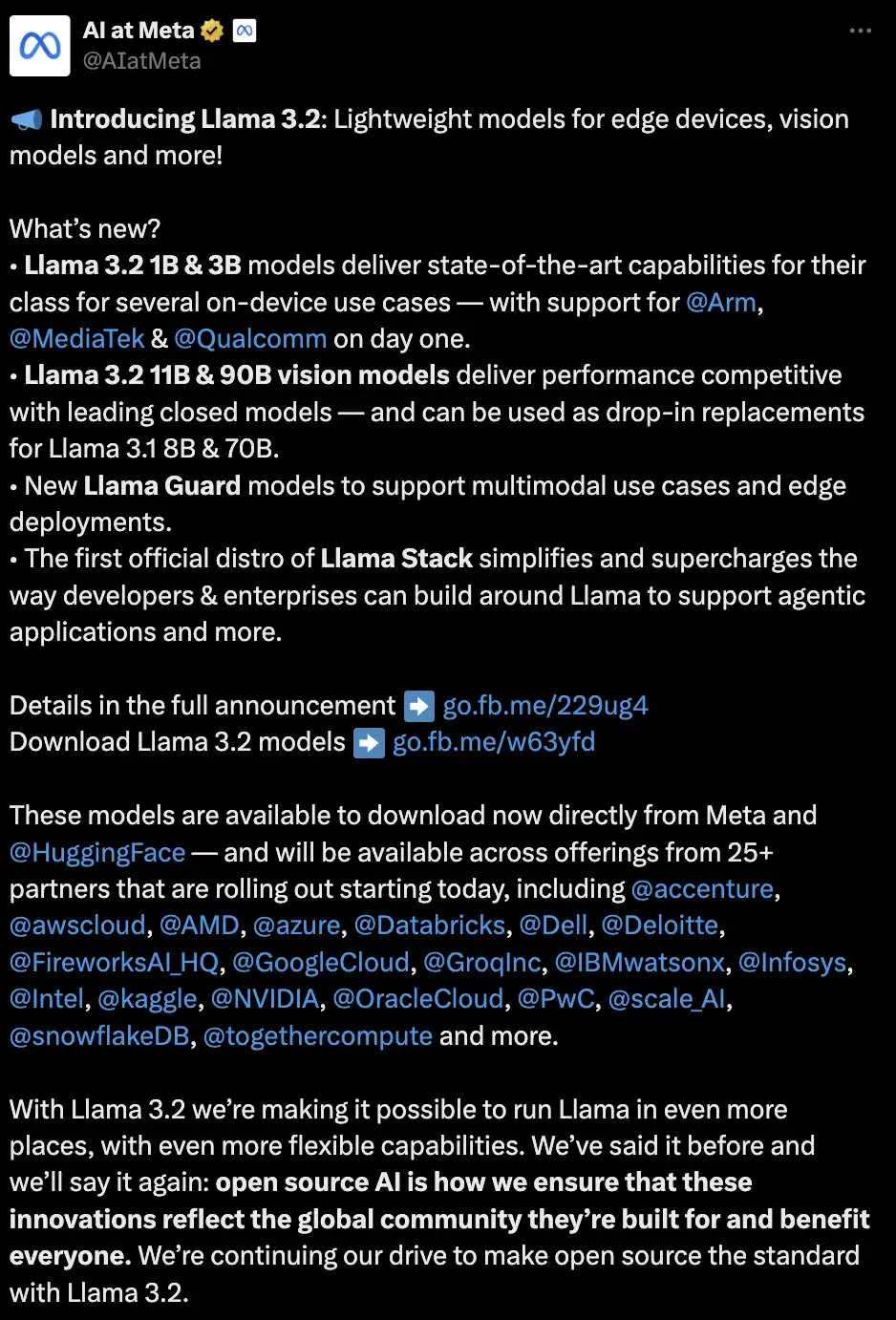

시각적 작업, 멀티모달 및 오픈 소스를 지원하는 최초의 Llama 모델

주요 하드웨어 출시와 더불어, 주커버그는 Llama에 대한 업데이트도 가져와서 Llama 3.2 모델을 출시했습니다. 시각 작업을 지원하는 최초의 Llama 모델인 Llama 3.2는 이미지와 텍스트를 모두 이해할 수 있습니다. 여기에는 에지 및 모바일 기기에 적합한 소형 및 중형 비전 모델(11B 및 90B)과 경량 일반 텍스트 모델(1B 및 3B)이 포함되며, 두 범주 모두 사전 학습된 버전과 지침 미세 조정 버전을 포함합니다. 이러한 다양한 사양의 모델은 Meta AI를 통해 시도해 볼 수 있다는 점도 언급할 가치가 있습니다.

모델 성능 평가

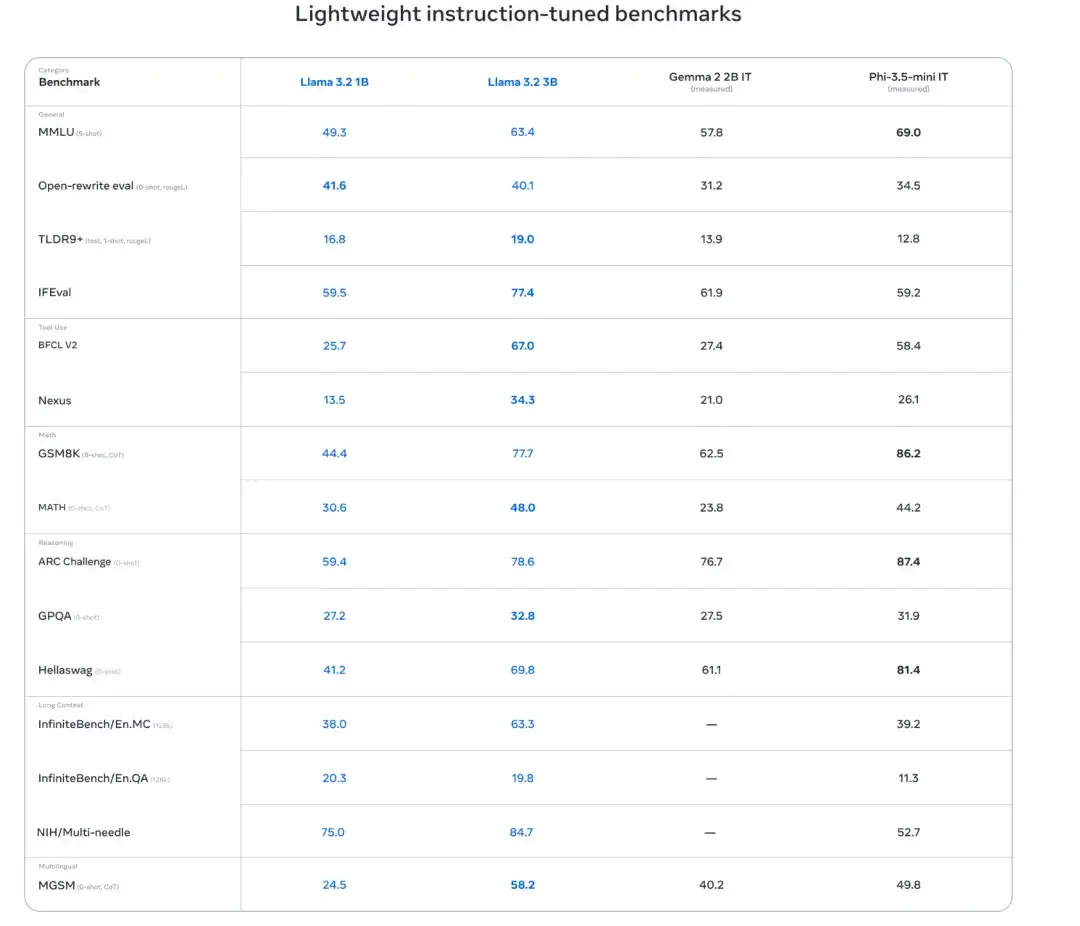

연구자들은 150명 이상을 대상으로 언어 간 조사를 실시했습니다.벤치마크 데이터 세트모델 성능을 평가합니다. 결과에 따르면 Llama 3.2 1B 및 3B 모델은 128K 토큰의 컨텍스트 길이를 지원합니다. 지시 따르기, 요약하기, 신속한 재작성, 도구 사용과 같은 작업에서 3B 모델은 Gemma 2 2.6B 및 Phi 3.5-mini 모델보다 우수한 성과를 보이는 반면, 1B 모델은 Gemma 모델과 경쟁할 수 있습니다.

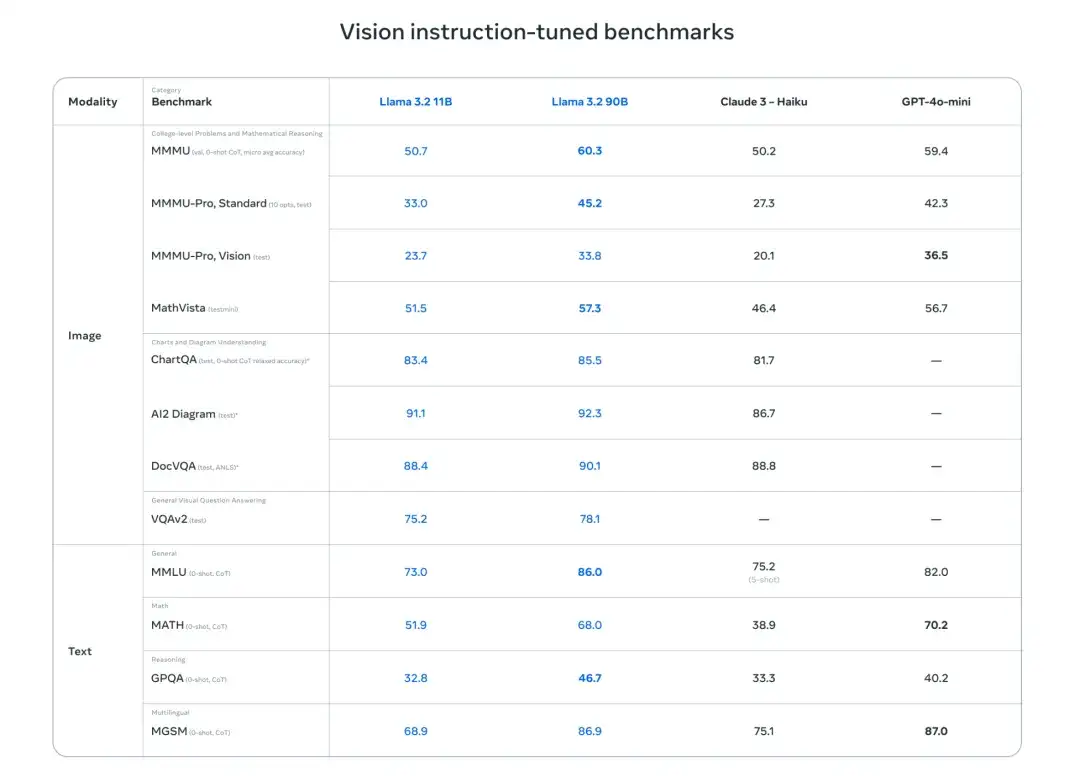

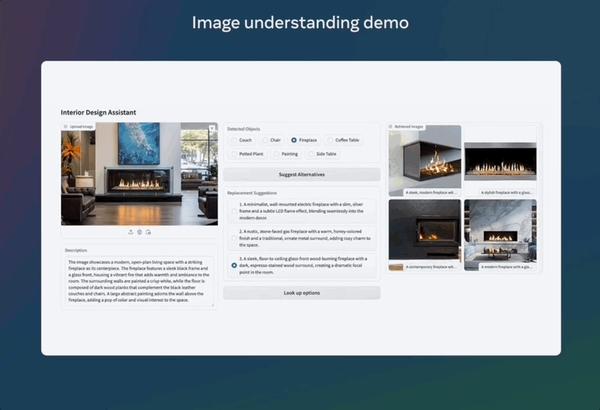

또한 연구자들은 이미지 이해와 시각적 추론 벤치마크에서 모델의 성능을 평가했습니다. 연구 결과에 따르면 Llama 3.2 11B와 90B 비전 모델은 해당 텍스트 모델을 완벽하게 대체할 수 있으며, 이미지 이해 작업에서는 Claude 3 Haiku와 같은 폐쇄형 소스 모델을 능가하는 것으로 나타났습니다.

경량 모델 학습

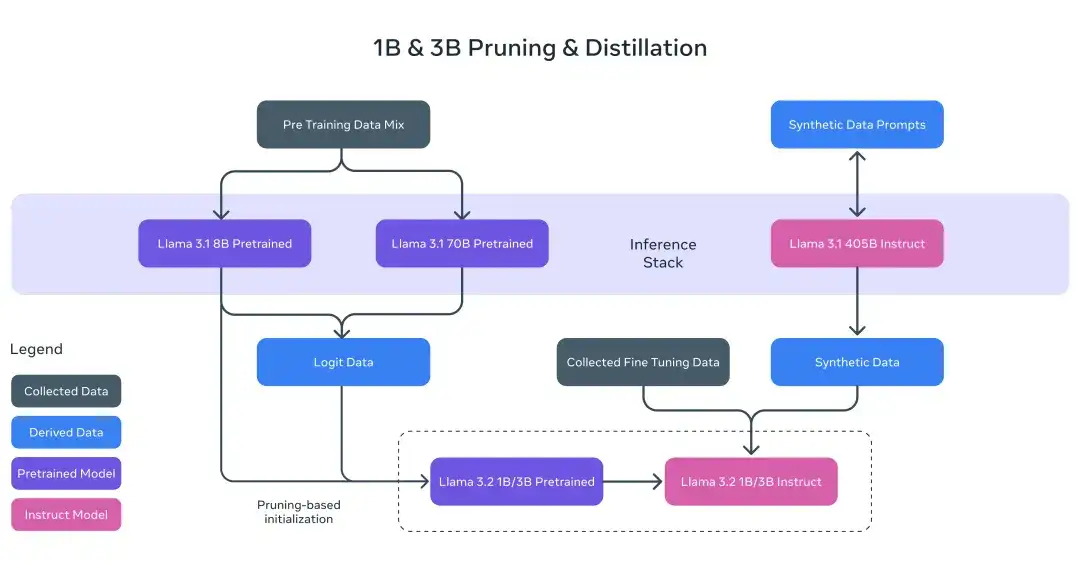

Llama 3.2 1B 및 3B 모델의 경우, 연구자들은 가지치기 및 증류 방법을 사용하여 8B/70B 모델에서 효율적인 1B/3B 모델을 추출했습니다.

구체적으로 연구진은 Llama 3.1의 8B 및 70B 모델의 Logit Date를 사전 학습 단계에 통합하고 이러한 대규모 모델의 출력(Logit Date)을 구조적 가지치기를 위한 토큰 수준 대상으로 사용했습니다. 연구자들은 가지치기 후지식 증류모델의 성능을 복구합니다.

시각적 모델 훈련

Llama 3.2의 훈련 과정은 여러 단계로 나뉩니다. 먼저, 사전 훈련된 Llama 3.1 텍스트 모델부터 시작합니다. 다음으로, 연구진은 이미지 어댑터와 인코더를 추가하고 대규모 노이즈가 있는(이미지, 텍스트) 쌍 데이터에 대해 사전 학습을 실시했습니다. 그런 다음 중간 규모의 고품질 도메인 내 데이터와 지식 증강(이미지, 텍스트) 쌍으로 구성된 데이터를 사용하여 학습합니다.

연구자들은 훈련의 후반 단계에서 텍스트 모델과 유사한 접근 방식을 채택하여 감독 미세 조정, 거부 샘플링, 직접 선호도 최적화를 위해 여러 라운드의 정렬을 사용했습니다. 연구진은 Llama 3.1 모델을 사용하여 합성 데이터를 생성하고, 도메인 내 이미지에 대한 질문과 답변을 필터링하고 향상시켰으며, 보상 모델을 사용하여 모든 후보 답변의 순위를 매겨 고품질 미세 조정 데이터를 보장했습니다.

또한 연구진은 보안 완화 데이터를 도입하여 보안성이 높고 실용적인 모델을 만들었습니다. 마침내 이미지와 텍스트를 모두 이해할 수 있는 Llama 3.2 모델이 탄생했습니다. 이는 더욱 풍부한 에이전트 기능을 향한 Llama 모델의 또 다른 중요한 단계를 의미합니다.

로컬 배포 모델은 시기적절하고 안전합니다.

연구자들은 Llama 3.2 모델을 지역적으로 운영하는 데는 두 가지 주요 이점이 있다고 지적합니다. 첫째, 응답 속도 측면에서 모든 처리가 로컬에서 이루어지므로 프롬프트와 응답 속도가 거의 즉각적일 수 있습니다.

둘째, 개인정보 보호 및 보안 측면에서 로컬에서 모델을 실행하면 메시지, 캘린더 등의 데이터를 클라우드로 전송할 필요가 없으므로 사용자 개인정보가 보호되고 애플리케이션의 개인정보 보호가 강화됩니다. 로컬 처리를 사용하면 애플리케이션은 어떤 쿼리가 장치에 남아야 하는지, 어떤 쿼리가 클라우드의 대규모 모델에서 처리되어야 하는지를 명확하게 제어할 수 있습니다.

굳게 붙잡다오픈소스원래 의도: 모델 배포가 더 간단하고 효율적입니다.

메타는 언제나 오픈 소스의 본래 의도를 고수해 왔습니다. 다양한 환경(단일 노드, 온프레미스 배포, 클라우드 및 장치 포함)에서 Llama 모델을 사용하는 개발자의 프로세스를 크게 단순화하기 위해검색 향상Meta는 통합 보안 기능을 갖춘 RAG 및 도구 지원 애플리케이션을 한 번의 클릭으로 배포할 수 있는 최초의 공식 Llama Stack 배포판을 공유할 것이라고 발표했습니다.

공식 소개에 따르면 Llama 3.2 모델은 http://llama.com 및 Hugging Face와 협력하고 AMD, AWS, Databricks, Dell, Google Cloud, Groq, IBM, Intel, Microsoft Azure, NVIDIA, Oracle Cloud, Snowflake 등 파트너 플랫폼에서 즉각적인 개발 지원을 제공합니다.

오픈소스의 꾸준한 지지자인 주커버그는 황런쉰과의 대화에서 "메타는 오픈소스 생태계로부터 이익을 얻었고 수십억 달러를 절약했다"고 말한 적이 있습니다. 라마는 의심할 여지 없이 오픈소스 생태계를 구축하는 데 중요한 도구입니다. Llama 3.2는 시각적 작업을 더욱 확장하고 다중 모달성을 달성하여 오픈 소스 생태계에 많은 이점을 제공할 것으로 예상됩니다.