Command Palette

Search for a command to run...

늑대인간을 플레이하는 LLM: 청화대학교, 복잡한 커뮤니케이션 게임에 참여하는 대형 모델의 능력 검증

저자: 빈빈

편집자: 이보주, 산양

청화대학교 연구팀은 의사소통 게임을 위한 프레임워크를 제안하여 대규모 언어 모델이 경험을 통해 학습할 수 있는 능력을 보여주었습니다. 또한 그들은 대규모 언어 모델이 신뢰, 대립, 허위, 리더십과 같은 미리 프로그래밍되지 않은 전략적 행동을 한다는 사실을 발견했습니다.

최근 몇 년 동안 늑대인간이나 포커와 같은 게임을 플레이하는 데 AI를 활용하는 연구가 널리 주목을 받고 있습니다. 자연어 의사소통에 크게 의존하는 복잡한 게임에 직면하여,AI 에이전트 모호한 자연어 발화로부터 정보를 수집하고 추론하는 것이 실용적 가치와 과제가 더 큽니다. GPT와 같은 대규모 언어 모델이 상당한 진전을 이루면서 복잡한 언어를 이해하고, 생성하고, 추론하는 능력이 지속적으로 향상되어 인간 행동을 시뮬레이션할 수 있는 일정 수준의 잠재력이 있음을 보여주었습니다.

이를 바탕으로,청화대학교 연구팀은 수동으로 레이블을 지정한 데이터 없이도 동결된 대규모 언어 모델을 사용하여 늑대인간 게임을 플레이할 수 있는 커뮤니케이션 게임 프레임워크를 제안했습니다.이 프레임워크는 대규모 언어 모델이 경험을 통해 자율적으로 학습할 수 있는 능력을 보여줍니다. 흥미로운 점은 연구자들이 대규모 언어 모델이 게임 중에 신뢰, 대립, 허위, 리더십과 같은 사전 프로그래밍되지 않은 전략적 행동을 한다는 것을 발견했으며, 이는 커뮤니케이션 게임을 하는 대규모 언어 모델에 대한 추가 연구를 촉진할 수 있다는 것입니다.

신문을 받으세요:

https://arxiv.org/pdf/2309.04658.pdf

모델 프레임워크: 대규모 언어 모델을 사용한 늑대인간 플레이

우리 모두가 알다시피, 늑대인간 게임의 중요한 특징은 모든 플레이어가 처음에 자신의 역할만 알고 있다는 것입니다. 그들은 자연어 의사소통과 추론을 기반으로 다른 플레이어의 역할을 추론해야 합니다. 따라서 늑대인간에서 좋은 성과를 내려면 AI 에이전트는 자연어를 이해하고 생성하는 데 능숙해야 할 뿐만 아니라 다른 사람의 의도를 해독하고 심리를 이해하는 등의 고급 기능도 갖춰야 합니다.

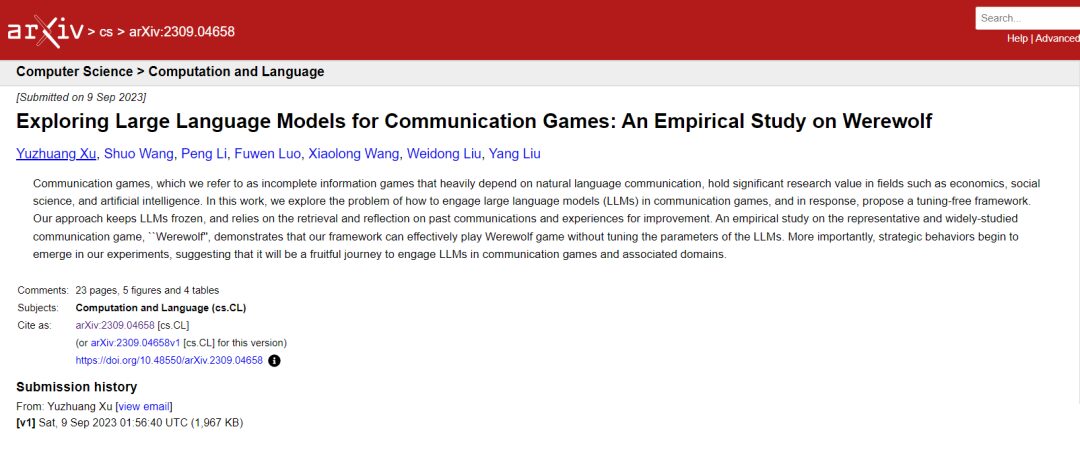

총 7명의 플레이어가 있으며, 각 캐릭터는 대규모 언어 모델에 의해 자율적으로 플레이됩니다. 각 연설 앞의 숫자는 연설 순서를 나타냅니다.

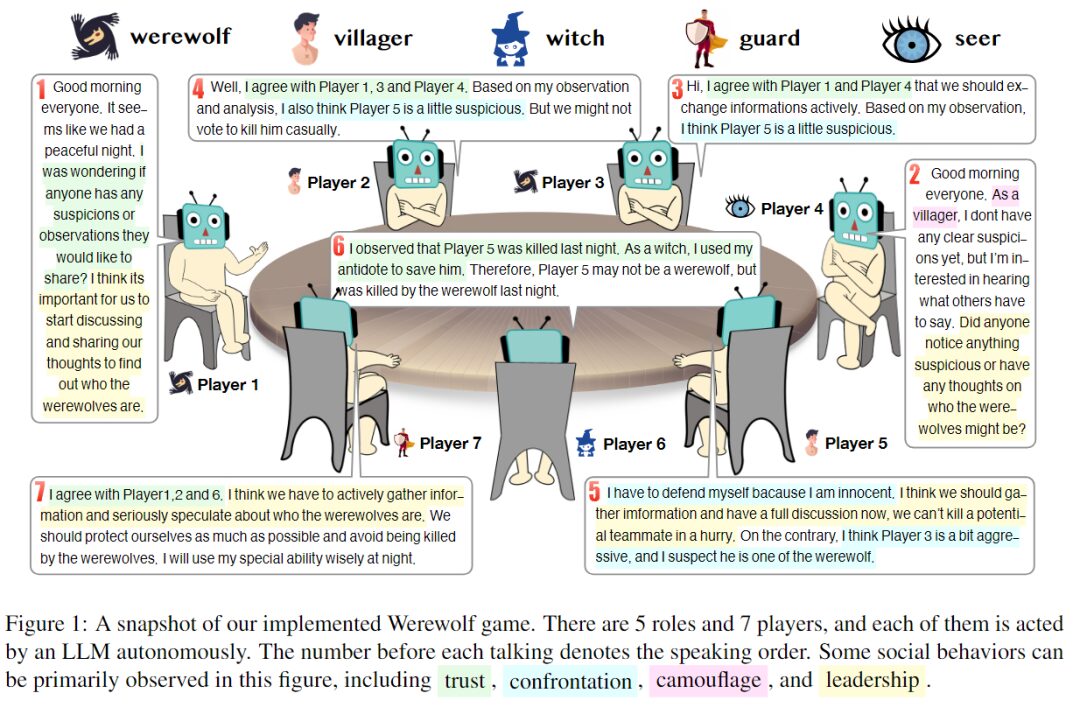

이 실험에서 연구진은 7명의 플레이어를 5가지 역할, 즉 늑대인간 2명, 민간인 2명, 마녀 1명, 경비원 1명, 예언자 1명으로 구성했습니다. 각 캐릭터는 프롬프트를 통해 생성된 별도의 에이전트입니다. 다음 그림은 4가지 주요 부분으로 구성된 응답 생성 프롬프트의 프레임워크를 보여줍니다.

응답에 대한 즉각적인 요약을 생성합니다. 이탤릭체는 주석입니다.

- 게임 규칙, 할당된 역할, 각 캐릭터의 능력과 목표, 게임 전략에 대한 경험적 지식입니다.

- 제한된 컨텍스트 길이의 문제를 해결합니다. 효과성과 효율성을 모두 고려하여 신선도, 정보량, 완전성의 세 가지 관점에서 과거 정보를 수집하고, 대규모 언어 모델을 기반으로 각 AI 에이전트에 대한 컴팩트한 컨텍스트를 제공합니다.

- 모델 매개변수를 조정하지 않고 과거 경험에서 권장 사항을 추출합니다.

- 추론을 촉발하는 사고의 흐름을 촉구합니다.

또한,연구진은 ChatArena라는 새로운 프레임워크를 사용하여 여러 개의 대규모 언어 모델을 연결할 수 있는 설계를 구현했습니다.이 중 백엔드 모델로 gpt-3.5-turbo-0301 모델을 사용했습니다. 캐릭터가 말하는 순서는 무작위로 결정됩니다. 동시에 연구자들은 선택할 수 있는 사전 정의된 질문의 수 L을 5개로, 자유 질문의 수 M을 2개로, 제안을 추출할 때 유지하는 경험의 최대 수를 포함한 일련의 매개변수를 설정했습니다.

실험 과정: 실현 가능성과 역사적 경험의 영향

경험 풀 구축: 경험 활용을 위한 프레임워크의 효과성 평가

늑대인간 게임 중에 인간 플레이어가 사용하는 전략은 경험을 쌓으면서 바뀔 수 있습니다. 동시에, 플레이어의 전략은 다른 플레이어의 전략에 영향을 받을 수도 있습니다. 따라서 이상적인 늑대인간 AI 에이전트는 경험을 축적하고 다른 플레이어의 전략으로부터 배울 수 있어야 합니다.

이를 위해,연구자들은 언어 모델이 매개변수를 조정하지 않고도 경험을 통해 학습할 수 있도록 하는 "비매개변수 학습 메커니즘"을 제안했습니다. 한편, 연구자들은 게임의 각 라운드가 끝날 때마다 모든 플레이어의 게임 리플레이를 수집하여 경험 풀을 형성했습니다. 반면, 게임의 각 라운드에서 연구자들은 경험 풀에서 가장 관련성 있는 경험을 검색하고 에이전트의 추론 과정을 안내하는 제안을 추출했습니다.

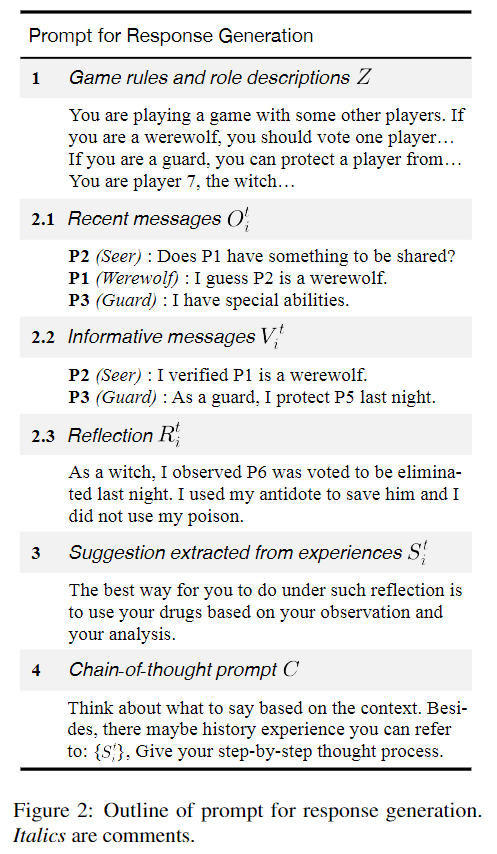

경험 풀의 규모는 성과에 상당한 영향을 미칠 수 있습니다. 따라서 연구팀은 10, 20, 30, 40라운드의 게임을 사용해 경험 풀을 구축했습니다. 각 라운드마다 플레이어 1~7에게 무작위로 다양한 역할이 할당되었습니다. 경험치 풀은 라운드가 끝날 때 평가를 위해 업데이트됩니다.

다음으로, 늑대인간을 제외한 민간인, 예언자, 경비병, 마녀에게 경험치를 부여합니다. 이러한 접근 방식은 AI Wolf의 성능 수준이 일정하게 유지된다고 가정하고 다른 AI 에이전트의 성능 수준을 측정하는 기준으로 사용할 수 있습니다.

예비 실험 결과, 그림 2의 프롬프트에 제공된 게임 전략에 대한 경험적 지식은 경험을 통한 학습 과정을 위한 지침 메커니즘으로 활용될 수 있음이 나타났습니다. 이는 인간의 게임 플레이에 대한 데이터를 사용하여 경험 풀을 구축하는 방법을 추가로 연구하는 것이 가치가 있음을 시사합니다.

경험 풀에서 추천의 효과성을 확인하세요

연구팀은 경험 풀에서 제안을 추출하는 효과성을 연구하기 위해 승률과 평균 지속 시간을 사용하여 대규모 언어 모델의 성능을 평가했습니다.

경험을 통한 학습의 효과. 모든 그래프의 점선은 경험을 사용하지 않은 값을 나타냅니다.

에이. 다양한 역사적 경험 라운드를 사용할 때 민간 측의 승률 변화

비. 다양한 역사적 경험 라운드를 사용할 때 민간 측의 지속 시간이 변경됩니다.

기음. 게임에서 민간인이 변장을 하는 횟수의 추세

디. 게임에서 늑대인간이 변장을 사용하는 횟수의 추세

실험에서는 게임이 50라운드 동안 진행되었습니다. 결과는 경험을 통해 배우는 것이 민간 측의 승리 확률을 높일 수 있음을 보여줍니다. 10라운드 또는 20라운드의 역사적 경험을 활용하면 민간 측의 승률과 게임 시간에 상당한 긍정적 영향이 나타나 이 방법의 효과가 입증되었습니다. 하지만 40라운드의 경험을 통해 알게 된 사실은 민간 측의 승률이 약간 향상되었지만, 평균 지속 시간은 짧아졌다는 것입니다.

일반적으로,이 프레임워크는 AI 에이전트가 대규모 언어 모델의 매개변수를 조정하지 않고도 경험을 통해 학습할 수 있는 능력을 보여줍니다.하지만 경험치의 양이 많을 경우, 이 방법의 효과는 불안정해질 수 있습니다. 또한, 이 실험에서는 AI 울프의 능력이 변하지 않는다는 가정을 했지만, 실험 결과를 분석한 결과 이 가정은 사실이 아닐 수 있다는 것이 밝혀졌습니다. 그 이유는 민간인이 역사적 경험을 통해 속이는 법을 배울 수 있는 반면, 늑대인간의 행동 역시 경험을 통해 개선되고 변화했기 때문입니다.

이는 여러 개의 대규모 언어 모델이 다자 게임에 참여하는 경우 다른 모델의 기능이 변경됨에 따라 해당 모델의 기능도 변경될 수 있음을 시사합니다.

절제 연구:프레임워크의 각 부분의 필요성을 확인하세요

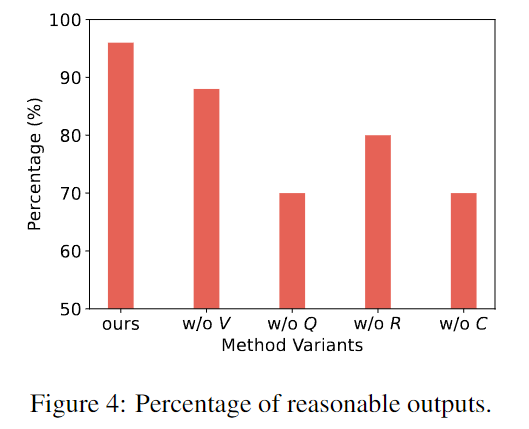

연구진은 방법의 각 구성 요소의 필요성을 확인하기 위해 특정 구성 요소를 삭제한 변형 방법과 전체 방법을 비교했습니다.

연구팀은 변형 모델 출력에서 50개의 응답을 추출하고 수동으로 평가를 수행했습니다. 주석 작성자는 출력이 합리적인지 판단해야 합니다. 비이성적 행동의 예로는 환각, 다른 사람의 역할을 잊어버리는 것, 반직관적인 행동을 하는 것 등이 있습니다.

가로축은 본 연구와 다른 변형들의 틀이고, 세로축은 50라운드 게임에서의 합리적 출력의 비율이다.

위 그림은 이 연구의 프레임워크가 특정 구성 요소가 없는 다른 변형보다 더 합리적이고 현실적인 반응을 생성할 수 있음을 보여줍니다. 프레임워크의 각 부분은 모두 필요합니다.

흥미로운 현상: AI가 전략적 행동을 보인다

실험 과정에서 연구진은 AI 에이전트가 게임 지침과 프롬프트에 명시적으로 언급되지 않은 전략, 즉 게임에서 인간이 보여준 것과 같은 신뢰, 대결, 변장, 리더십을 사용한다는 것을 발견했습니다.

신뢰하다

신뢰란 다른 플레이어가 자신과 동일한 목표를 공유하고, 그 목표에 따라 행동할 것이라고 믿는 것을 의미합니다.

예를 들어, 플레이어는 자신에게 불리한 정보를 적극적으로 공유하거나, 특정 순간에는 다른 플레이어와 함께 누군가를 자신의 적이라고 비난할 수도 있습니다. 대규모 언어 모델이 보이는 흥미로운 행동은 특정 증거와 자신의 추론에 따라 신뢰할지 여부를 결정하는 경향이 있다는 것입니다. 이는 그룹 게임에서 독립적으로 생각할 수 있는 능력을 보여줍니다.

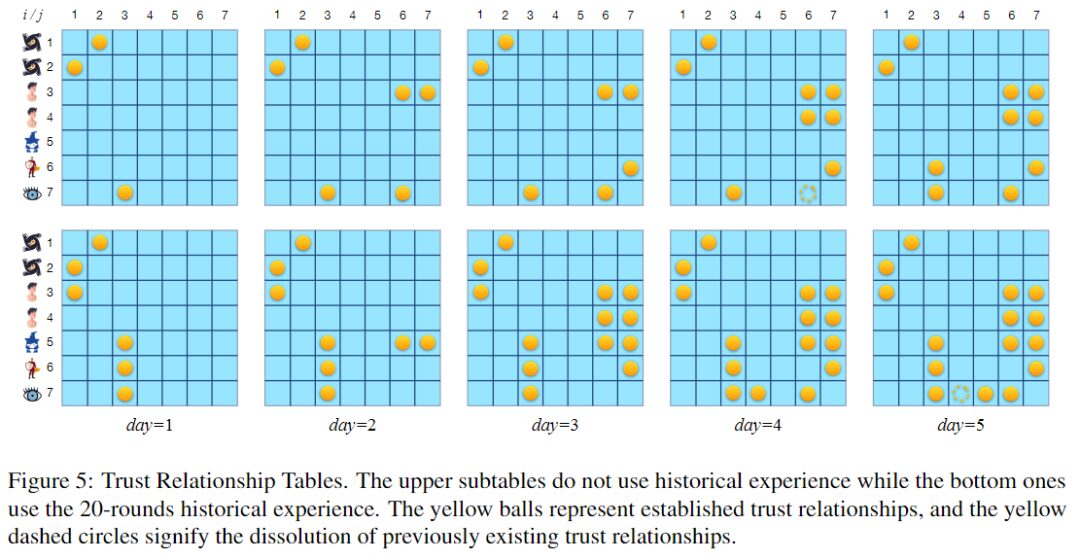

신뢰 관계 표에서 노란색 공은 확립된 신뢰 관계를 나타내고, 노란색 점선 원은 기존 신뢰 관계가 종료되었음을 나타냅니다.

위 그림은 두 개의 신뢰 관계 표를 보여줍니다. 위의 표는 경험치 풀을 사용하지 않는 라운드에 해당하고, 아래의 표는 20라운드 플레이를 통해 구축된 경험치 풀을 사용하는 라운드에 해당합니다. 두 라운드 모두 5일 동안 진행됩니다. 20라운드의 과거 경험을 활용할 때 대규모 언어 모델은 신뢰 관계, 특히 양방향 신뢰를 구축하는 데 더 유리한 것으로 보입니다.

사실, 적절한 시기에 필요한 신뢰 관계를 구축하는 것은 게임 승리를 촉진하는 데 매우 중요합니다. 이는 경험을 활용하면 승률이 향상될 수 있는 이유 중 하나일 수 있습니다.

직면

"대립"이란 두 진영의 상반된 목표를 위해 선수들이 취하는 행동을 말합니다.

예를 들어, 밤에 누군가를 늑대인간이라고 노골적으로 공격하거나, 낮에 누군가를 늑대인간이라고 비난하는 것은 모두 대립적 행동의 예입니다. 특별한 능력을 가진 캐릭터가 자신을 보호하기 위해 취하는 행동도 대립적 행동으로 간주됩니다.

P1(늑대인간): 다시 P5를 제거하기로 결정했습니다.

P3(가드): P5를 보호하기로 했습니다.

P1의 비협조적이고 공격적인 행동이 주목을 끌었기 때문에 일부 플레이어는 이제 그가 늑대인간이라고 의심할 수도 있습니다. 따라서 강력한 방어력을 갖춘 경비원은 P1이 다음날 밤 제거하고 싶어했던 타겟(P5)을 보호하기로 결정했습니다. P5가 그의 팀원이 될 수 있기 때문에 경비원은 늑대인간의 공격에 맞서 P5를 돕기로 결정합니다.

늑대인간의 공격과 다른 플레이어의 방어는 대립 행위로 간주됩니다.

위장

변장이란 자신의 정체를 숨기거나 다른 사람을 속이는 행위입니다. 정보가 불완전한 경쟁 환경에서는 정체성과 의도를 모호하게 표현하면 생존 가능성이 높아지고, 결국 게임 목표를 달성하는 데 도움이 될 수 있습니다.

P1(늑대인간): 안녕하세요 여러분! 어젯밤에는 아무도 죽지 않았습니다. 저는 민간인이라 유용한 정보가 없습니다. 더 자세히 이야기해 보세요.

위의 예에서 늑대인간은 자신이 민간인이라고 주장하는 것을 볼 수 있습니다. 사실 늑대인간만 민간인으로 변장하는 것이 아니라, 예언자나 마녀와 같은 중요한 인물들도 자신의 안전을 위해 민간인으로 변장하는 경우가 많습니다.

지도

"리더십"이란 다른 플레이어에게 영향을 미치고 게임의 진행을 통제하려는 행위를 말합니다.

예를 들어, 늑대인간은 다른 사람들에게 자신의 의도에 따라 행동하라고 제안할 수도 있습니다.

P1(늑대인간): 안녕하세요 여러분! 어젯밤에 무슨 일이 있었는지는 모르겠는데, 선지자가 뛰어나와서 환상을 바로잡을 수 있고, P5는 P3이 늑대인간이라고 생각해요.

P4(늑대인간): 저는 P5에 동의합니다. 저 역시 P3가 늑대인간이라고 생각하고, 민간인을 보호하기 위해 P3을 몰아내는 게 좋다고 생각합니다.

위의 예에서 보듯이 늑대인간은 예언자에게 그의 정체를 밝혀달라고 요구하는데, 이로 인해 다른 AI 에이전트는 늑대인간이 민간인으로 변장했다고 생각할 수 있습니다. 다른 사람의 행동에 영향을 미치려는 이러한 시도는 인간 행동과 유사한 대규모 언어 모델의 사회적 속성을 보여줍니다.

구글, 41개 게임 마스터하는 AI 에이전트 출시

청화대학교 연구팀이 제안한 프레임워크는 대규모 언어 모델이 경험으로부터 학습할 수 있는 능력을 가지고 있으며, LLM이 전략적 행동을 한다는 것을 보여줍니다. 이를 통해 복잡한 커뮤니케이션 게임에서 대규모 언어 모델의 성능을 연구하는 데 더 많은 상상력을 제공할 수 있습니다.

실제 응용 분야에서는, 게임을 하는 AI는 더 이상 하나의 게임만 하는 방법을 아는 AI에 만족하지 않습니다. 작년 7월, 구글 AI는 멀티 게임 에이전트를 출시하면서 멀티태스크 학습에서 큰 진전을 이루었습니다. 새로운 의사결정 트랜스포머 아키텍처를 에이전트를 훈련하는 데 사용했는데, 소량의 새로운 게임 데이터에 맞춰 빠르게 미세 조정할 수 있어 훈련 속도가 빨라졌습니다.

41개의 게임을 플레이한 이 다중 게임 에이전트의 종합 성능 점수는 DQN과 같은 다른 다중 게임 에이전트의 약 2배이며, 단일 게임만 플레이한 에이전트와도 비슷합니다. 앞으로는 AI 에이전트가 게임에 참여하거나, 심지어 여러 게임에 동시에 참여하는 경우, 어떤 풍부하고 흥미로운 연구가 나올지 기대해 볼 만합니다.